Posters & Infografías

Conocimiento en Imagenes

En esta sección se incluyen posters e infografías publicadas con periodicidad en redes sobre mis principales áreas de investigación y especialización.

Parece mentira, pero hace ya la friolera de 25 años que empezamos a entrar en Internet. En aquellos años navegar era una actividad efímera que se contaba por minutos. Primero esquilmábamos un terreno cuidadosamente elegido en el espacio de lo digital y sólo después, desconectados, rumiábamos con tranquilidad todos aquellos datos. Eran tiempos pasados de una nomadismo digital que muchos ni siquiera habrán vivido. Tiempos en los que nuestro nerviosismo atávico nos llevaba a consumir información como si no hubiera un mañana mientras que los negocios estaban explorando aquel nuevo espacio e intentando descubrir como sacarle partido como una valla publicitaria más. Te preguntarás que tiene que ver todo esto con la Inteligencia Artificial de nuestros días. Pues si me acompañas en las próximas tres semanas lo descubrirás.

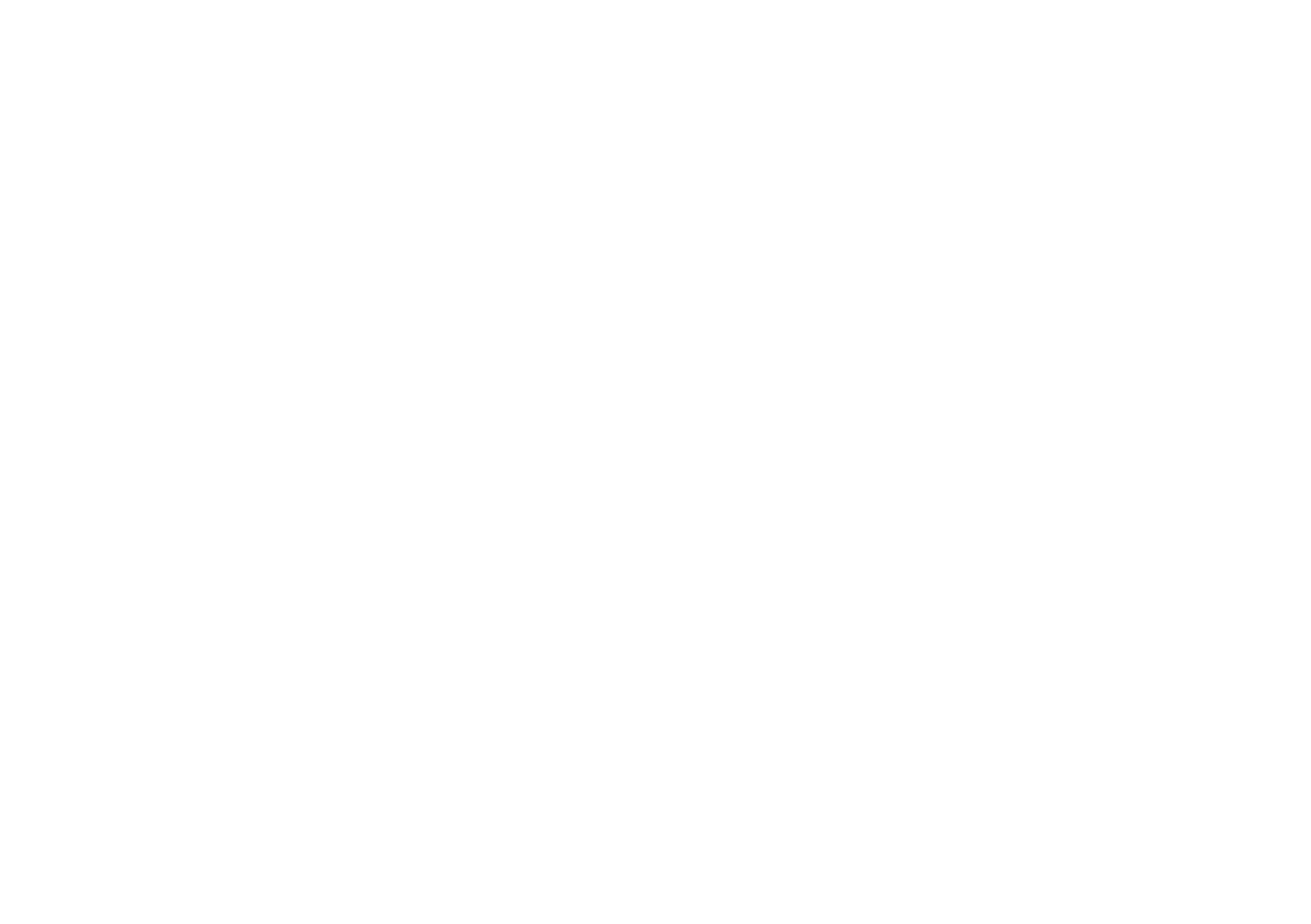

Los negocios aprendieron rápidamente la lección. El espacio digital no iba a ser un terreno abonado para todos. Solamente sería repartido entre grandes bastiones, que establecerían allí su feudo digital. Y de la noche a la mañana, articulando la mentira de una web democrática para todos basada en productores y consumidores, consiguieron convertirnos a los usuarios en fieles vasallos que entregaban de manera sistemática y recurrente sus vidas en forma de historia digital. No importaba la relevancia de todo aquello. Lo relevante era entrar en un círculo vicioso de entrega sistemática para poder nutrir al gran reino feudal. Ese era el precio por disponer de un terreno digital dentro del feudo aparentemente gratuito. Y nuestra recompensa, para mantenernos felizmente integrados en aquella realidad social, eran las métricas de aceptación basadas en los "likes". Hoy Hemos salido ya de este oscuro, ¿o no?

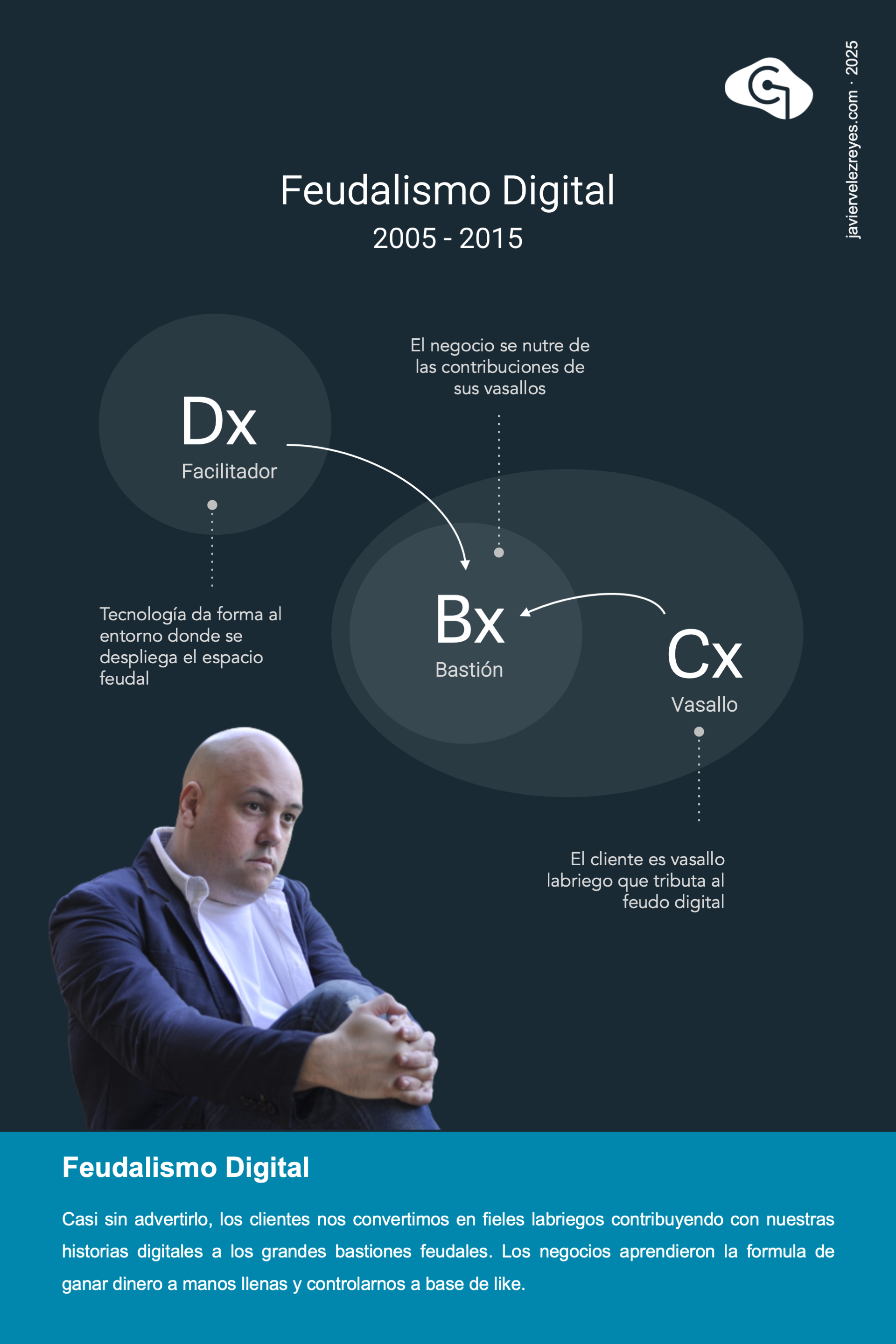

Fue la tecnología la que tuvo que venir a nuestro rescate para despertarnos del letargo del feudalismo digital. Los consumidores habíamos logrado independizarnos de la dominación de los negocios y la inversión de control se había producido. Ahora serían ellos los que deberían perseguir la atención de sus clientes, a través de un universo de interacciones basadas en notificaciones que debían ser convenientemente atendidas a través de microgestos, todo ello articulado en un momento de fuerte competitividad creciente. Teníamos la libertad de decidir cómo y cuándo atender. Pero no nos engañemos, todo eso no fue más que un mero espejismo. Las plataformas de hoy en día construyen cámaras de eco y resonancia para manipular nuestras actitudes y condicionar nuestro comportamiento activo a su favor. Y lo peor es que este hecho esta llegando a trascender los límites fronterizos de lo digital.

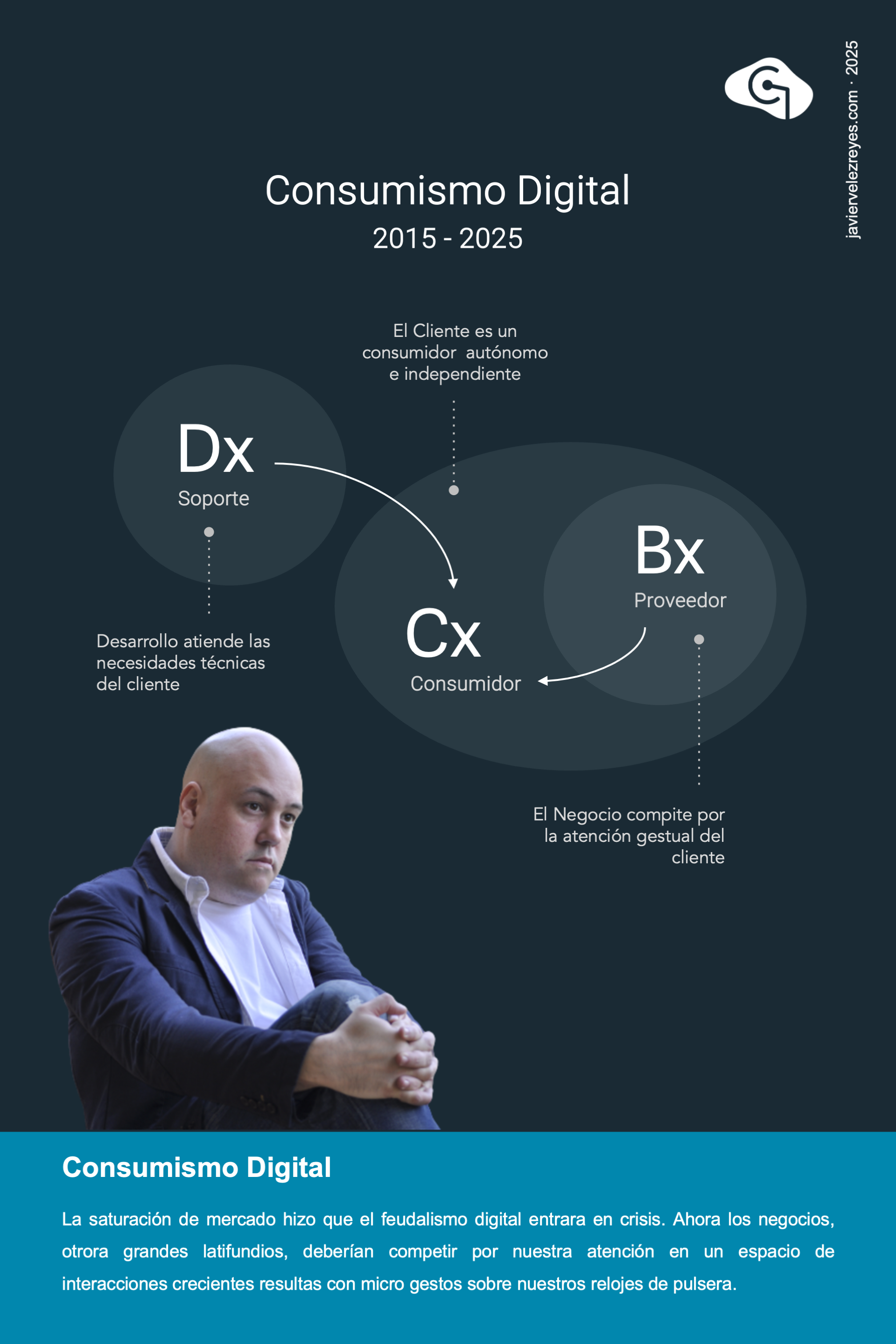

Hoy en día hemos llegado al modernismo digital y la interacción entre los negocios y los consumidores está vertebrada por la Inteligencia Artificial. Operamos a través de un Agente Inteligente responsable de responder a todas nuestras necesidades de consulta. Aún es pronto, pero seguramente estos agentes pronto presentarán capacidades para aprender de los intereses de cada usuario en base a su actividad y comportamiento digital, lo que permitirá una modulación adaptativa creciente en cada nueva respuesta emitida. Pero si bien las respuestas obtenidas por los clientes serán progresivamente más satisfactorias, ¿no corremos el riesgo de que los agentes de consulta realicen actividades de sesgo cognitivo basadas en una malentendida experiencia adaptativa? Tal vez llegue el momento en que la adaptación intencional de los agentes nos deje ciegos ante determinados espacios de conocimiento. Y poniéndonos algo más paranoicos, puede que los fabricantes de estos agentes utilicen esa tendencia natural para crear cámaras de eco y resonancia digital al servicio de intereses oscuros. Eso solo el futuro lo dirá, Lo que está claro es que los negocios en esta nueva era irán perdiendo progresivamente todo el control de su tráfico e incluso de la experiencia que pueden entregar a sus clientes.

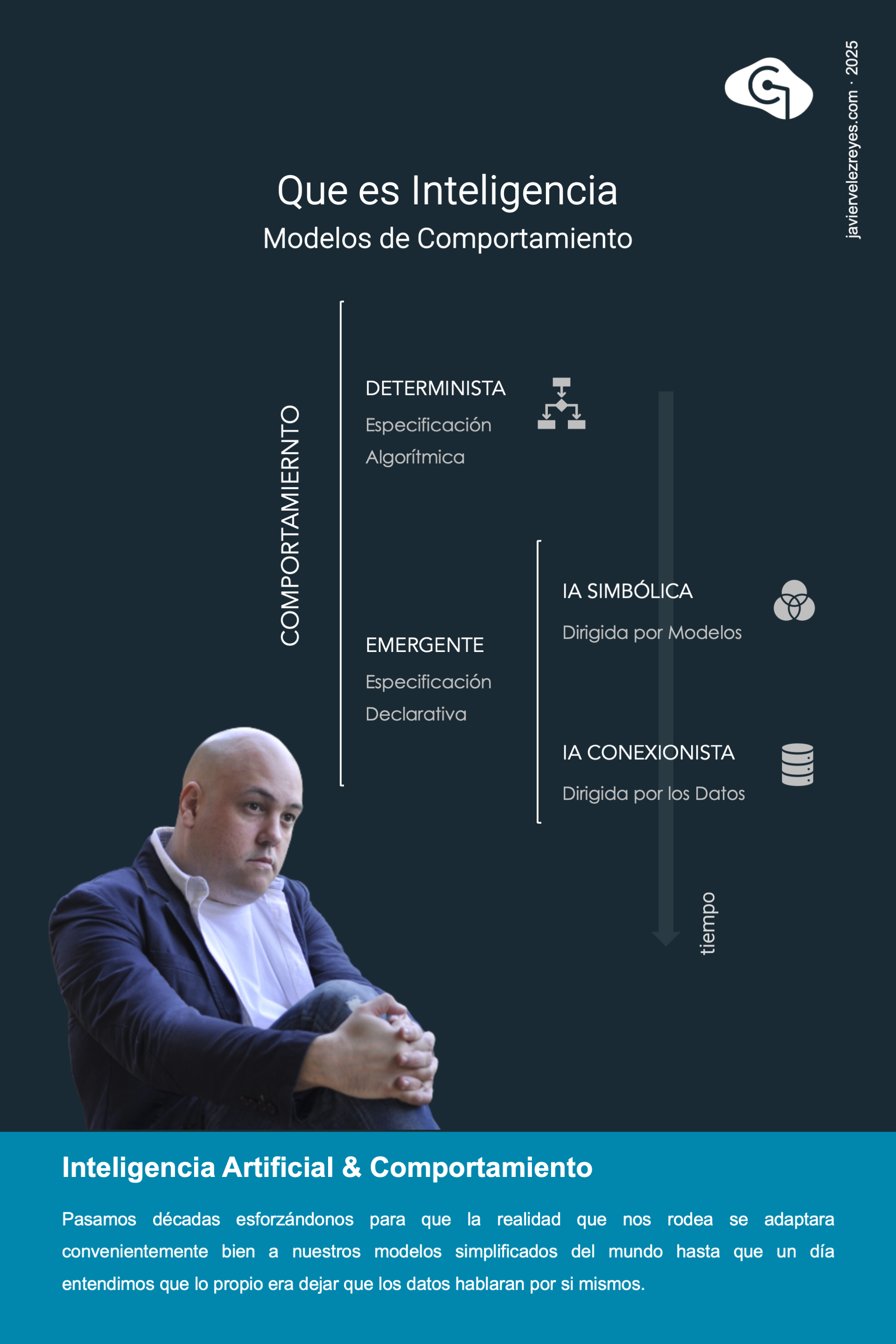

Hoy casi parece olvidado pero estuvimos la friolera de más de 30 años intentando hacer esa cuadratura del circulo en base a modelos de razonamientos capaces de operar con conocimiento formalmente representado. Intentábamos hacer un modelo del mundo para forzar después a que el mundo se adaptara a nuestro modelo. Aquella romántica idea de academia, aunque dio algunos frutos, nunca llego a funcionar. Tendrían que pasar muchos años más, casi hasta llegar a nuestros días, para darnos cuenta de que los comportamientos inteligentes se obtienen solamente a través de una confianza ciega en los datos. Había que entrenar los sistemas con grandes volúmenes de información y dejar que el comportamiento esperado emergiera por si mismo.

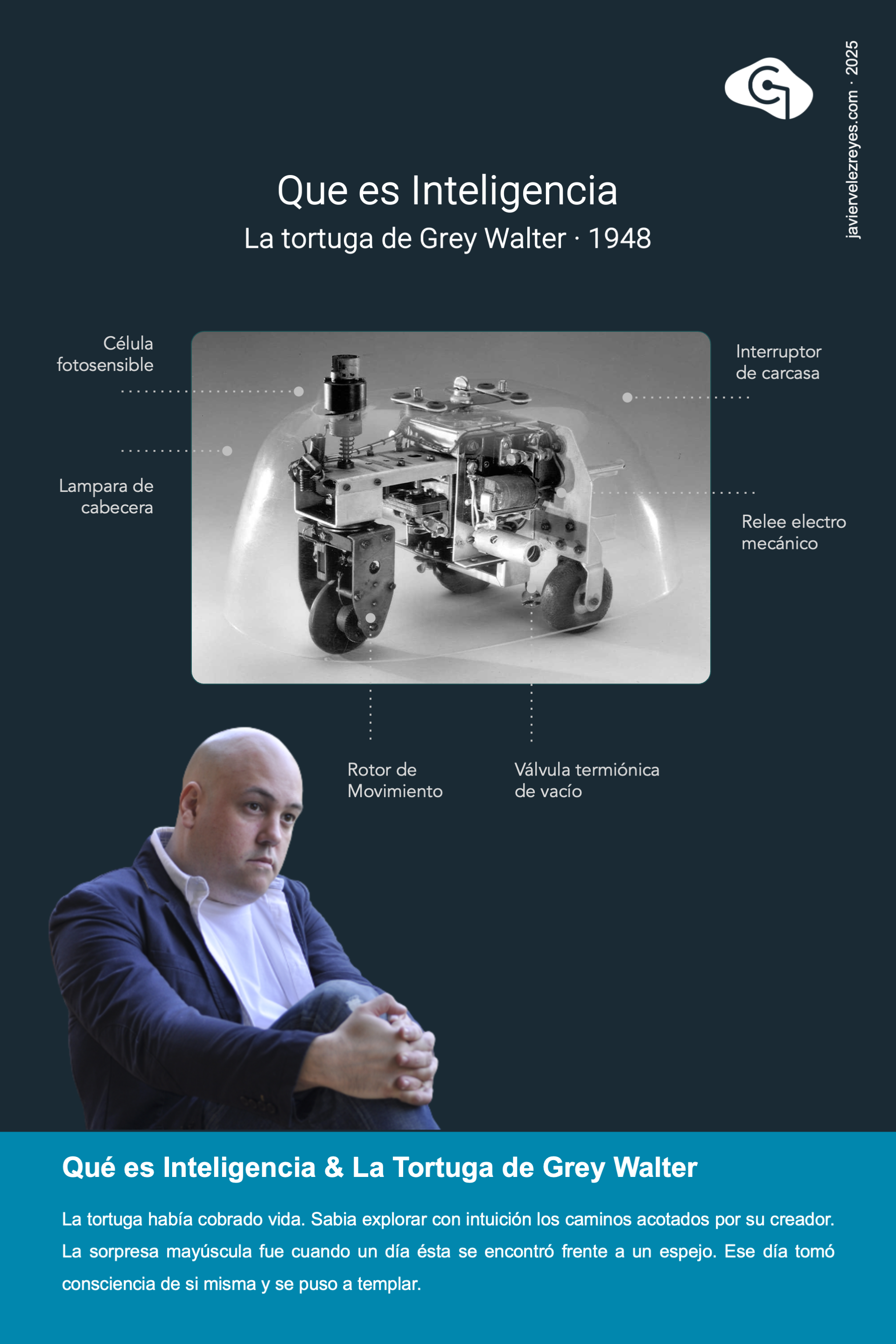

En 1948 Grey Walter decidió crear a Elmer y Elsie, dos tortugas robóticas. Parecían haber cobrado vida al mostraba un comportamiento emergente en la búsqueda incesante de fuentes de luz y alejándose de las zonas de penumbra. Pero lo que fue verdaderamente sorprendente es cuando se enfrentaron a un espejo. Entonces su propia imagen reflejada les hizo ponerse a templar. Cuando recuerdo esta historia siempre pienso en el valor que damos los humanos a nuestra propia inteligencia como factor de diferenciación. A la postre, no nos separan de otros animales más que algunos miles de años de evolución. Usamos iguales neuronas, mismos dendritas y axones e iguales convoluciones cerebrales por donde fluyen pensamientos en forma de impulsos eléctricos a través de sinapsis neuronales. Con la Inteligencia Artificial actual estamos creando esas mismas estructuras conexionistas en el laboratorio y los resultados de comportamiento emergente están resultando francamente sorprendentes. Quiza deberíamos dejar de pensar si la Inteligencia Artificial es verdaderamente inteligente para empezar a reflexionar sobre qué tiene de sublime lo que siempre hemos dado en llamar inteligencia humana.

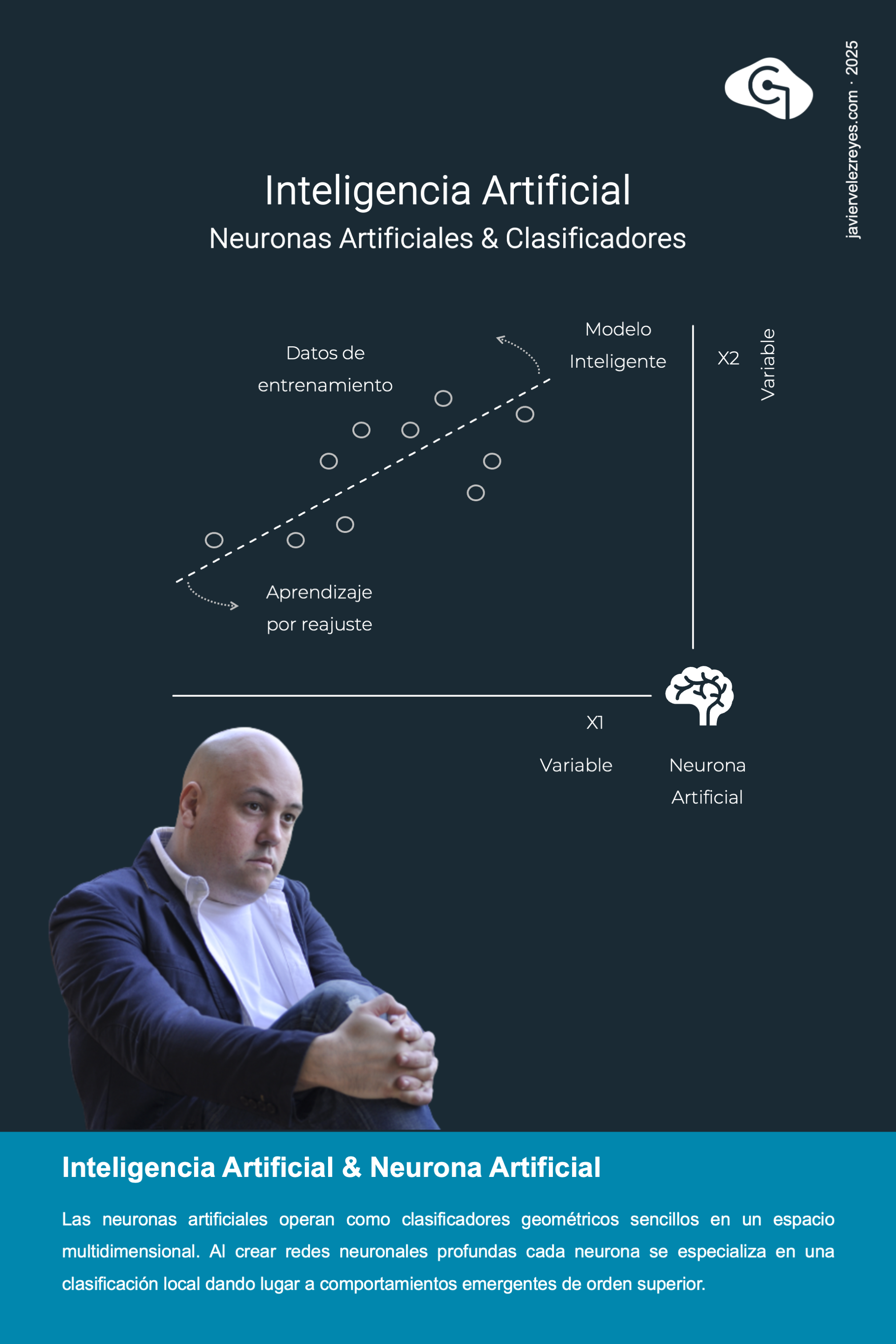

Si te doy un punto, serás capaz de trazar infinitas rectas que pasen por el. Si te doy dos, solo podrás trazar una. Si te doy una nube de puntos no serás capaz de trazar recta alguna. Para este último escenario los matemáticos y estadísticos nos vienen al rescate ideando una recta imaginaria que sea la solución de mejor ajuste promedio a todos los puntos de la nube. Pues bien, exactamente eso es lo que hace una neurona artificial en su etapa de entrenamiento. Con cada nuevo punto de entrada la recta se reajusta para encontrar la mejor solución de compromiso. Al conjunto de puntos utilizados para articular esta solución se le llama datos de entrenamiento, a la recta así obtenida se le llama modelo inferido y al procedimiento de reajusta algorítmico sistemático se le llama modelo de aprendizaje. Y es que, como explicaré en próximas semanas esto es lo único que necesitamos para hacer emerger inteligencia en sistemas artificiales.

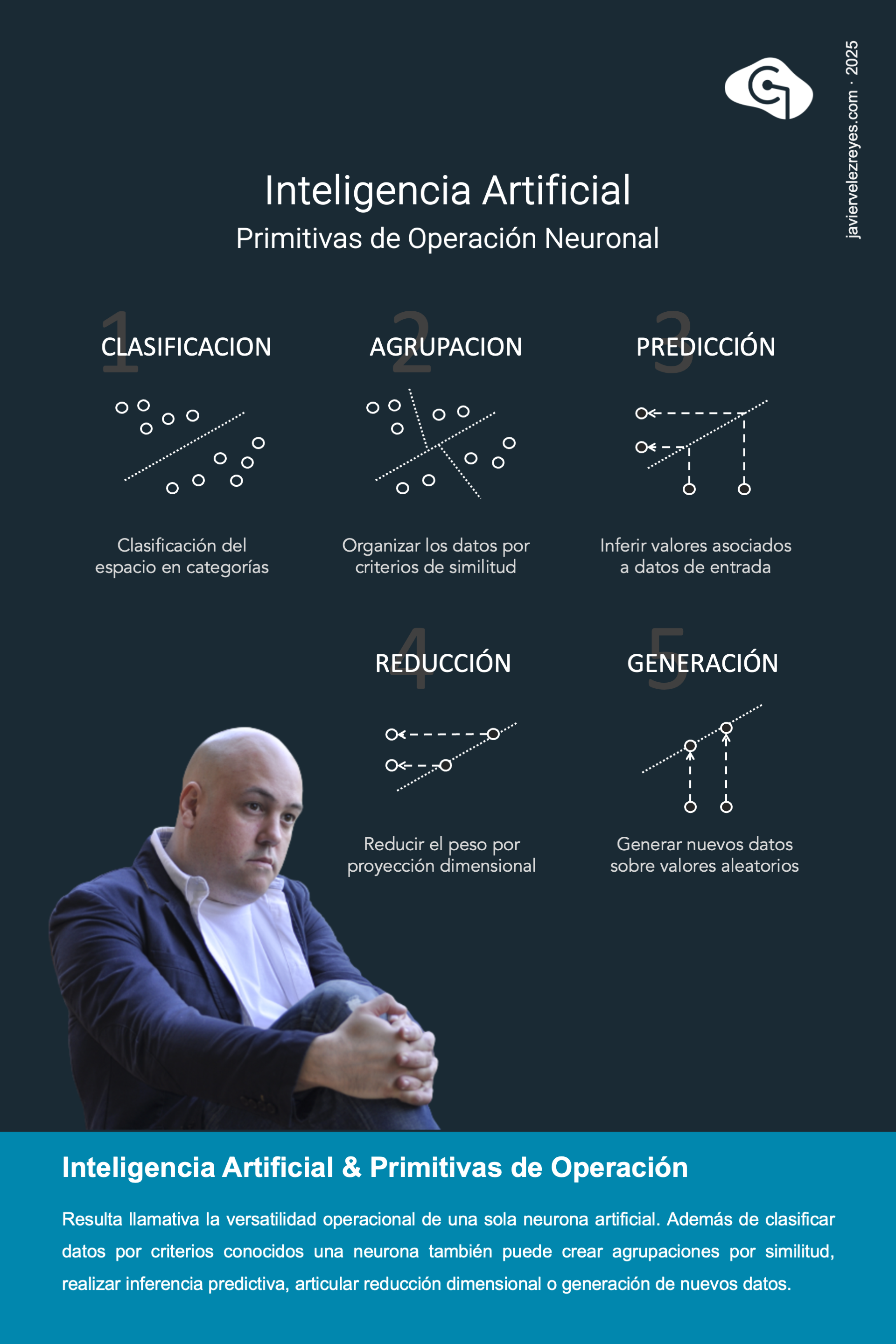

Con una sola neurona hemos conseguido crear un clasificador geométrico que opera sobre un espacio de múltiples dimensiones. Atravesada la fase de entrenamiento, el modelo puede usarse para clasificar. Todos los datos de entrada que lleguen en la fase de inferencia, caerán por encima o por debajo de la recta. Podemos ajustar nuestra neurona para que responda con un 1 si caen por encima o con un 0 si caen por debajo. Pero las posibilidades de un clasificador lineal no acaban ahí. Conjugando varias neuronas puedo identificar los clústeres en los que se subdivide un espacio de datos reales. Puedo predecir el valor de tendencia que tendrá un dato en la vertical a partir de su valor en la horizontal. O puedo usar el modelo para reducir por proyección la dimensionalidad de los datos. E incluso puedo generar nuevos datos sintéticos en la horizontal a partir de datos sorteados aleatoriamente en la vertical.

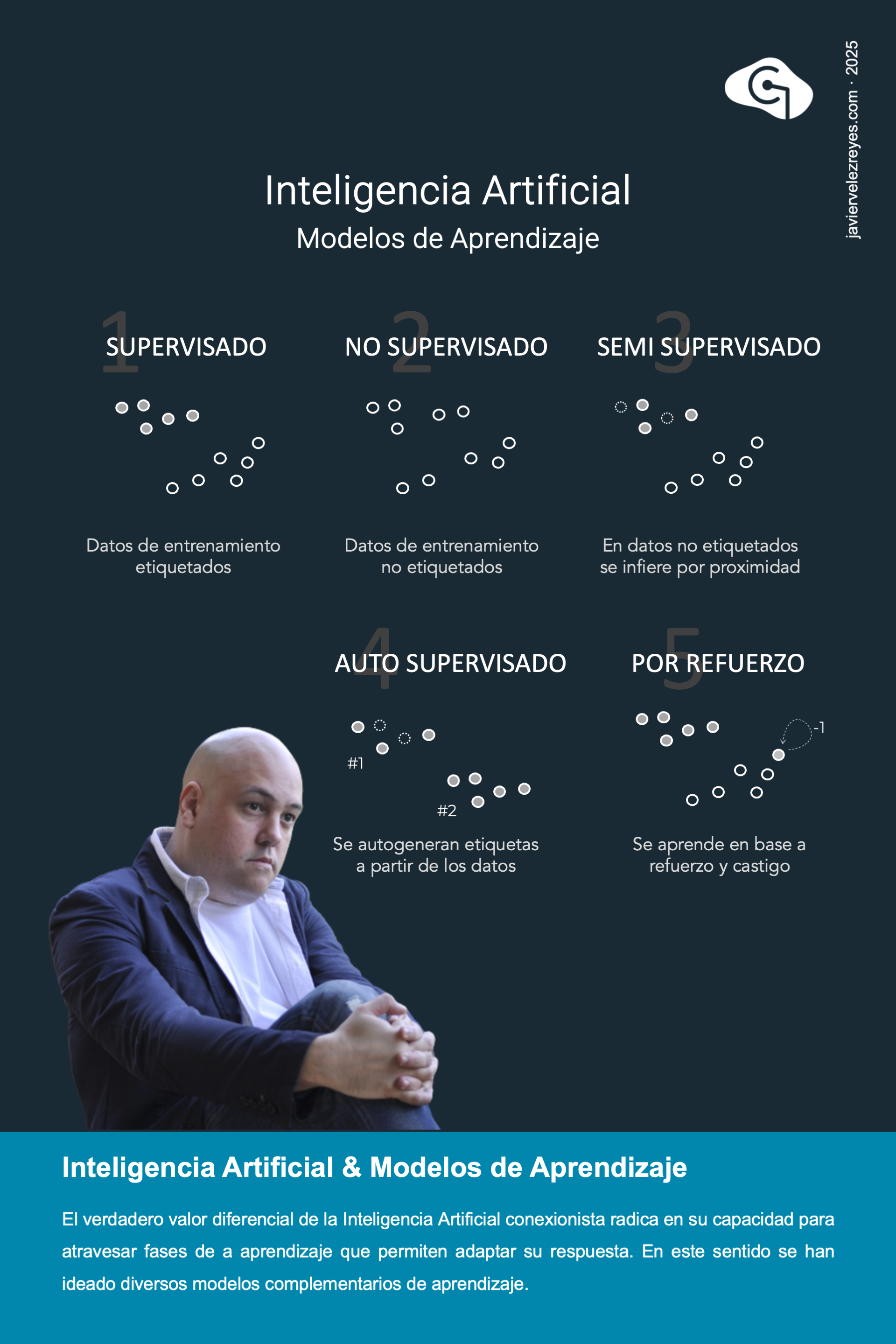

Las neuronas artificiales, a la postre no son nada si no se les hace atravesar por una fase adecuada de entrenamiento, y es aquí donde entran en juego los distintos modelos de aprendizaje. En el modelo de aprendizaje supervisado, los datos de entrenamiento se etiquetan con la respuesta que debe emitir la neurona. Sencillo pero pesado de construir. En el otro extremo los modelos no supervisados invitan a la neurona a ofrecer una respuesta intuitiva en base a la disposición espacial de los datos. Los modelos semi-supervisados y auto-supervisados resultan soluciones intermedias. En el primer caso se mezclan datos etiquetados con no etiquetados y para los segundos su respuesta se infiere por la respuesta que arrojan los datos de la vecindad. En el segundo caso, se generan de forma sintética datos de entrenamiento etiquetados a partir de valores reales. Pero sin lugar a dudas, los modelos de más rabiosa actualidad son los de aprendizaje por refuerzo en los que un agente inteligente es capaz de aprender iterativamente a partir de la observación de la respuesta que generan sus acciones en el entorno. Confía en los datos para crear inteligencia.

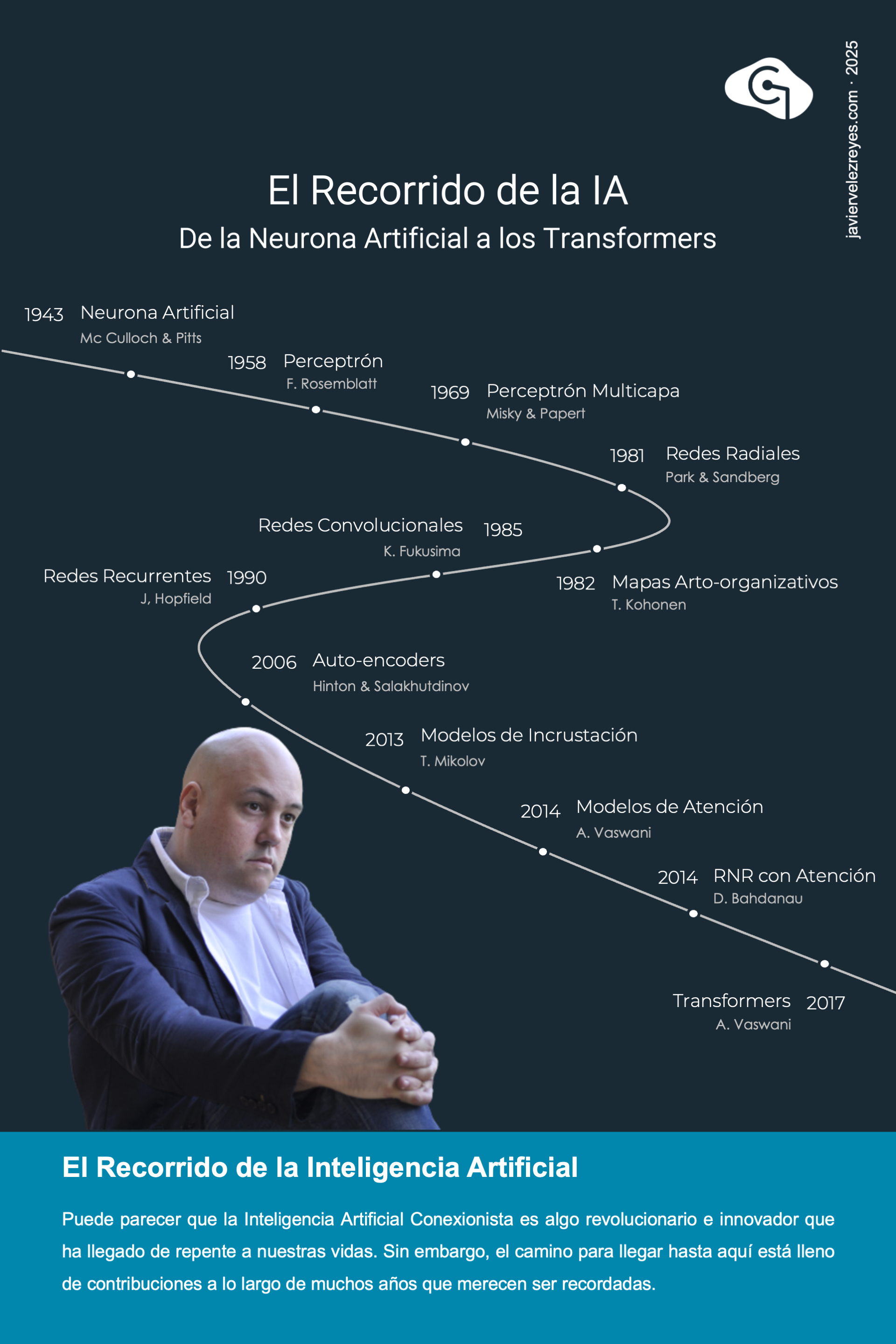

Parece que la Inteligencia Artificial es algo que acaba de nacer. Pero lo cierto es que el recorrido de toda esta disciplina ha sido un largo camino. Desde que Mc Culloch y Pitts idearan el primer modelo matemático sobre la neurona artificial y Rosemblatt descubriera su valor como operador geométrico de clasificación lineal hasta las más recientes arquitecturas de transformadores han pasado la friolera de 7 décadas. Y además todo ello atravesando dos periodos de inactividad por desanimo de los investigadores que se dieron en llamar los inviernos de la Inteligencia Artificial. Creo justo reclamar desde este rincón el mundo una merecida ovación y reconocimiento a todos aquellos incansables curiosos que hicieron sus contribuciones de academia para poder haber llegado hasta aquí.

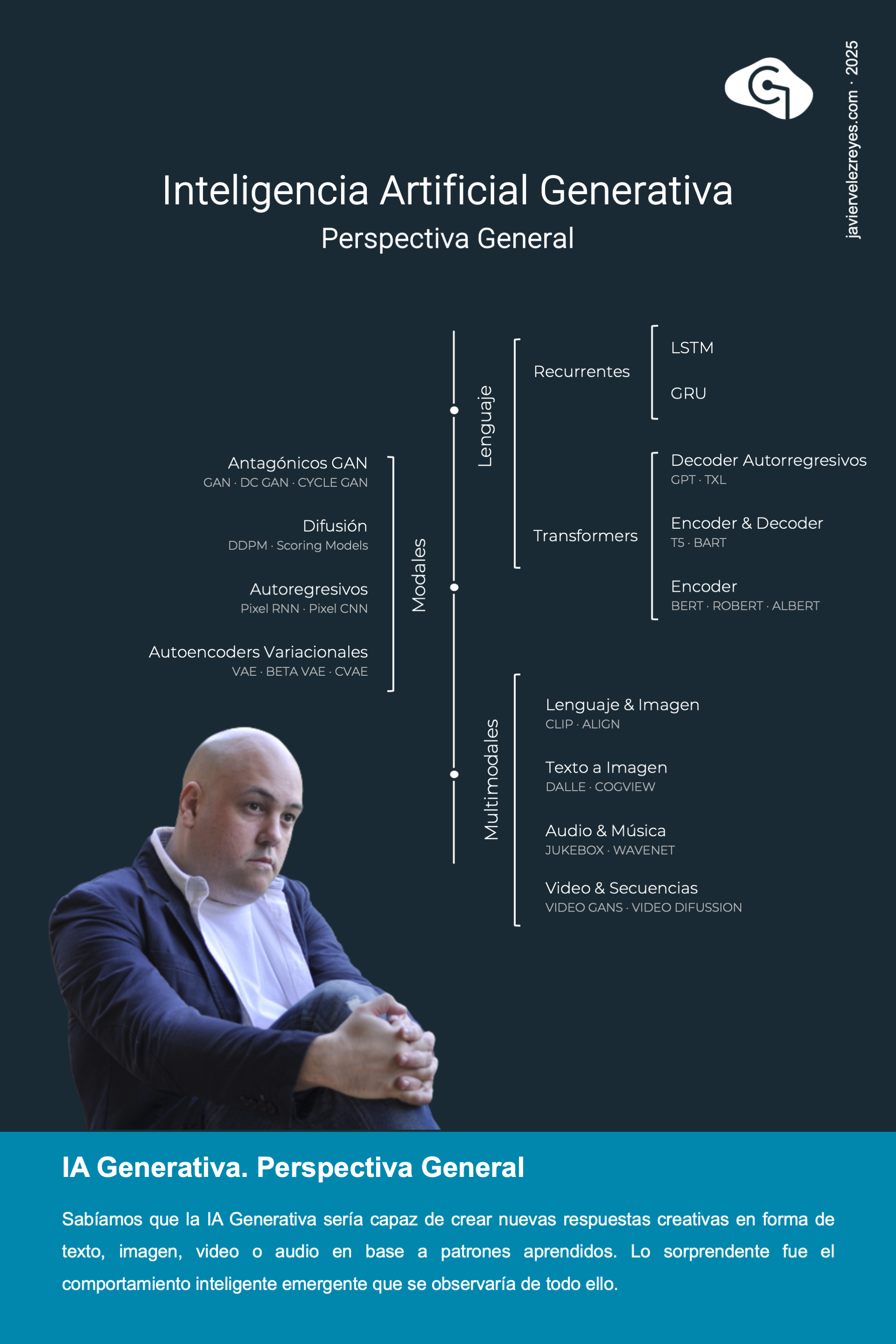

Puede resultar injusto pero el auge de atención de la Inteligencia Artificial se alcanzo con la llegada de los modelos generativos, sistemas capaces de mostrar un comportamiento emergente creativo en la generación de textos, imágenes, audio o video. Pero quizá la mayor contribución de valor ha sido la de los modelos de lenguaje. Se trata de redes neuronales con la capacidad de capturar todo el contenido semántico de una consulta de entrada, abrigada por su correspondiente contexto en forma de una codificación numérica vectorial y generar después una continuidad a dicho contexto que se devuelve como respuesta a la consulta. En una primera fase de entrada el sistema es capaz de adjudicar a cada palabra un significado local que depende de la relación semántica que ésta mantiene con sus anteriores. En la fase de salida la interpretación semántica así generada se utiliza para generar siguientes palabras que den una continuidad coherente al texto introducido. Hay variantes y matices en todo esto.

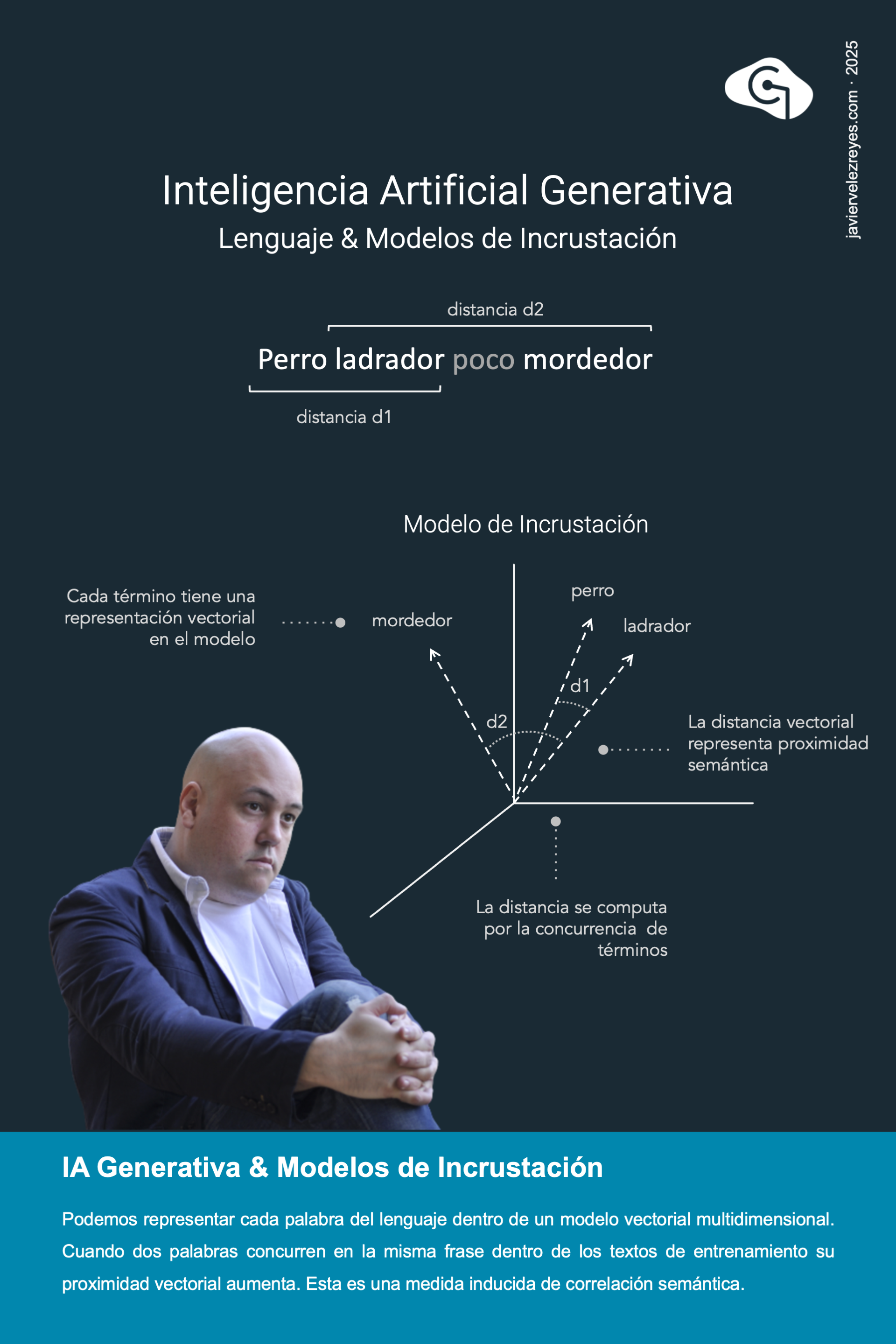

El primer paso tendría que ser capturar el significado esencial de cada palabra de nuestro lenguaje de forma precisa. Durante muchos años habíamos intentado, sin éxito, conquistar este esfuerzo a base de los modelos lingüísticos que nos enseñaron en la escuela. Pero si algo habíamos aprendido de tantos años de inteligencia conexionista es que debemos confiar más en los datos al diseñar nuestras soluciones. Idealmente se trataría en encontrar una representación numérica vectorial para cada término manteniendo una único idea subyacente en todo el constructo. Todas las palabras que, de algún modo, estuvieran relacionadas con una dada deberían alojarse en la vecindad proximal dentro de ese espacio vectorial. Esa sería la esencia de la captura semántica. Pero, ¿qué queríamos decir con eso de estar relacionadas? Juguemos a un juego. Supongamos que ponemos a un sistema inteligente a procesar toda la literatura del siglo de oro español. Ahora fabriquemos 4 vectores distintos con un solo 1 en una posición y 0 en el resto. Da igual que posición se escoja con tal de que en cada vector la posición activa sea distinta. Imaginemos que nos fijamos en 4 palabras de todo ese corpus de texto y se las asociamos a cada vector. Rocinante será uno de los vectores, Quijote otro, Dulcinea un tercero y Sancho el cuarto. Ahora empieza el entrenamiento. Durante el procesamiento de cada frase dentro de cada texto buscamos las coocurrencias de nuestras palabras. Por ejemplo al procesar la palabra Quijote dentro de una frase dada, si la palabra Dulcinea también aparece en la frase entonces sumamos una pequeña contribución a la posición de Dulcinea dentro del vector de Quijote. Lo recíproco haremos al analizar esa misma frase computando el vector Dulcinea y encontrando la coocurrencia Quijote. Con esto, ya finalizada la fase de entrenamiento, obtendremos vectores para cada palabra que capturan la relación semántica con otras palabras por coocurrencia. Esto no es del todo preciso pero sirve para ilustrar el proceso. Resulta asombroso que de manera tan trivial pueda capturarse el significado de las palabras de forma numérica.

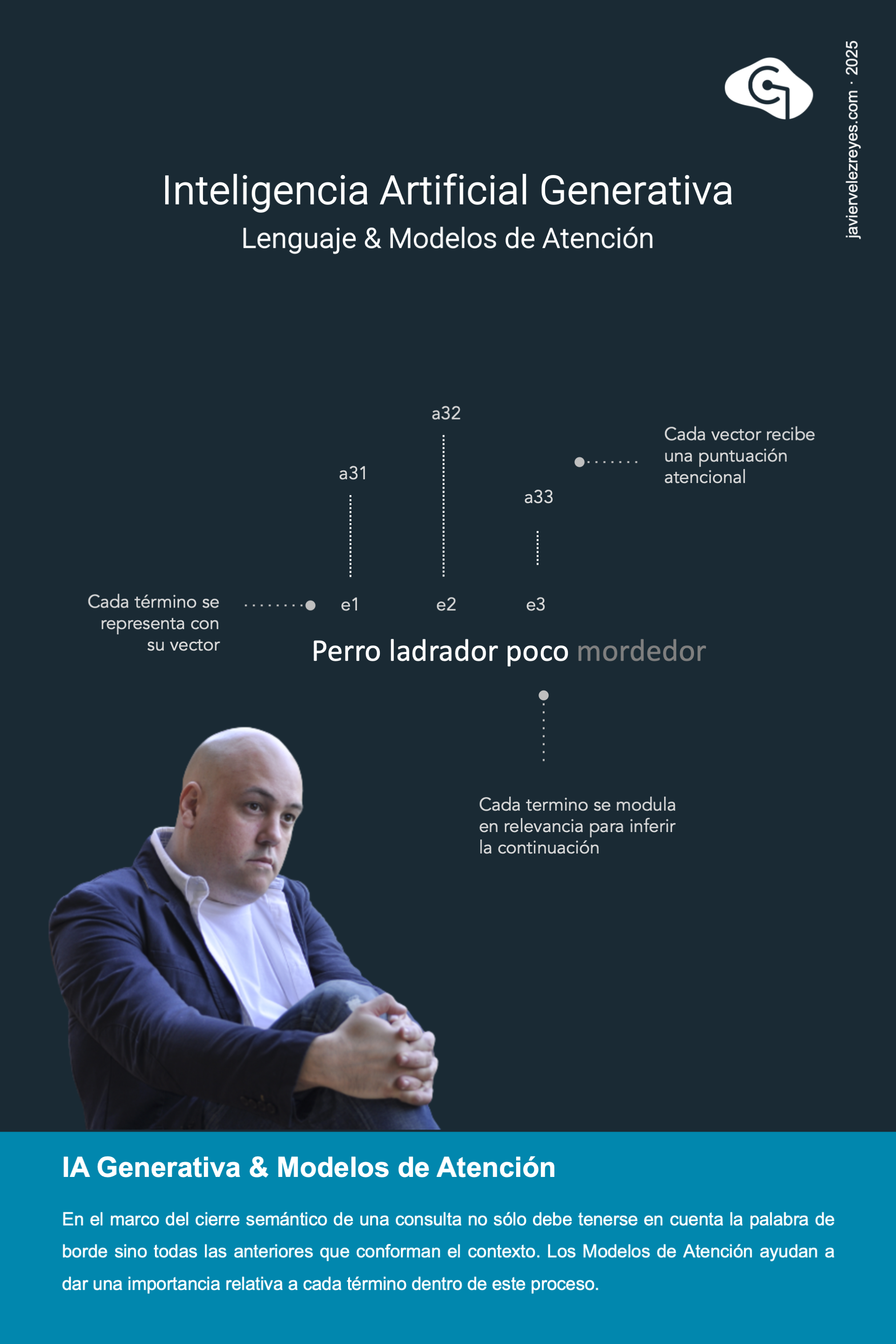

Mediante el uso de modelos de incrustación aprendimos a capturar el contenido semántico de cada palabra en el lenguaje en forma de una representación vectorial. Sin embargo, para capturar el significado completo de una frase no basta con disponer de todos esos significados. Necesitamos hacer una interpretación en términos de la estructura gramatical de la frase. Nuevamente aquí debemos alejarnos de modelos formales. Confiar en los datos en este punto también consiste en un proceso de composición vectorial. Para cada palabra dentro de una frase podremos calcular la distancia vectorial de las demás y eso nos da una medida de la relevancia de cada palabra en el proceso de interpretación de la frase completa. Este tipo de estrategias reciben el nombre de modelos de atención. Resulta confuso pensar que con tanto ajuste vectorial estemos moviendo el sistema a alguna suerte de representación formal del significado dirigido por los datos pero lo cierto es que de hecho es así. En la frase “El gato pardo se sentó en la alfombra” intuitivamente cabe pensar que cualquier proceso cognitivo de captura semántica pasa más cerca de hacer una interpretación semántica de las palabras “gato”, “sentó” y “alfombra” que de otras palabras presentes en la frase como “El”, “se” o “pardo”. Esa modulación en relevancia atencional es precisamente lo que consiguen discriminar los modelos de atención que aplican hoy en día con éxito todos los sistemas de Inteligencia Artificial Generativa centrados en lenguaje.

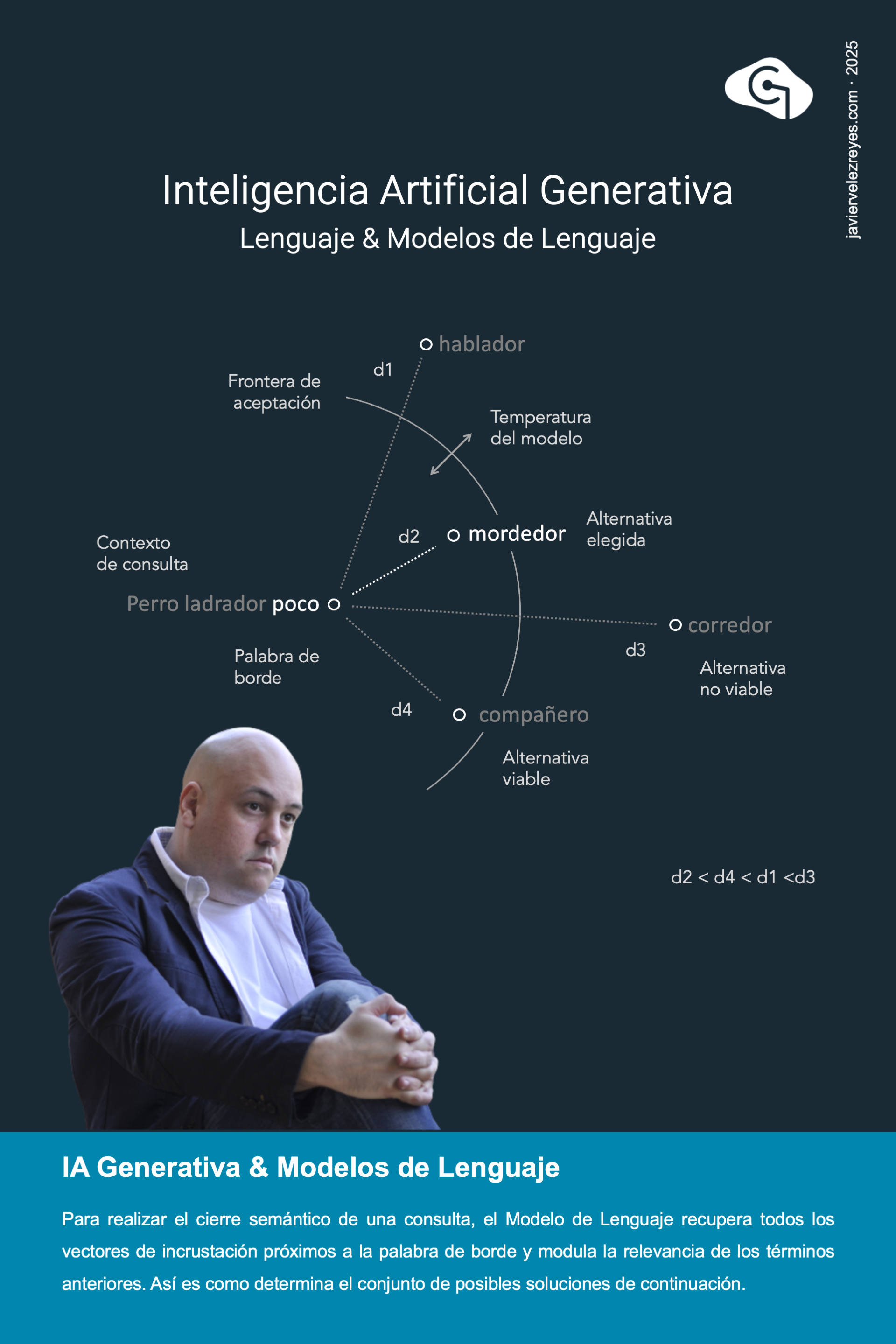

Hasta este punto del relato disponemos de los modelos de incrustación y los modelos de atención para capturar la esencia de significados que encierra cualquier frase en lenguaje natural. Pero ahora nuestros objetivos son otros. Tratamos de crear un sistema inteligente capaz de dar una respuesta como continuidad natural a la consulta abrigada de contexto enviada por el usuario. Se trata, en este sentido, de una actividad generativa que debe escoger nuevas palabras para extender creativa pero coherentemente al contexto recibido. Todo esto parece muy complejo pero si recordamos que nuestras palabras son vectores dispuestos por proximidad en nuestro espacio de incrustación entonces todo se simplifica. Situémonos en la última palabra del contexto, que llamaremos palabra de borde. Entonces busquemos en nuestro espacio vectorial aquel otro término que se encuentre más próximo a nuestra palabra de borde, escojámosla como solución de continuidad que da forma a nuestra respuesta y procedamos así nuevamente para generar la siguiente palabra hasta llegar a ciertas condiciones de cierre. Esto es, en esencia lo que hace un LLM cuando hablamos con él. Ya ves! Pensar, razonar, responder… es algo que se basa en esencia en dar saltos de vecindad en un espacio terminológico vectorial. Pero, ¿tiene todo esto sentido o estamos siendo ingenuamente simplistas? Lo cierto es que algo de sentido tiene. Si recordamos nuestras explicaciones anteriores, al entrenar nuestra inteligencia con los textos de la literatura de oro del siglo español ha creado un espacio de palabras dispuestas con la debida proximidad estratégica como para no sólo sabes responder en perfecto castellano sino también y sobre todo para capturar conocimiento especializado. Si preguntamos a nuestro sistema ¿Quién fue el amor de Quijote? Es de esperar que la respuesta sea Dulcinea, dado que es el primer nombre propio que se encuentre en las proximidades de la palabra Quijote. Aparentemente un mecanismo débil pero que se ha demostrado terriblemente eficaz. Ahora toca volver a reflexionar, ¿no será que nuestra inteligencia está regida por los mismos principios de aparente debilidad?

Pueden reconocerse 6 perímetros donde la Inteligencia Artificial Generativa impactará sonadamente dentro de nuestra profesión, y observo, en este sentido, que hay fuertes malentendidos dentro de todo este espacio de controversias cruzadas. Sin duda alguna, la Inteligencia Artificial cambiará la forma de entender el tipo de productos digitales pero no como se está explicando sino como un giro mucho mas copernicano. Las motivaciones de este cambio también están siendo mal entendidas, y también existe confusión sobre el locus donde se producirá el cambio y el momento del tiempo donde actúa la Inteligencia Artificial o sobre el impacto que ésta tendrá en los procesos de digitalización. Pero quizá el mayor eje de preocupación está en aventurar cómo este tsunami de transformación digital no afectará en lo laboral y profesional. Quisiera dedicar las próximas semanas a profundizar en todos estos perímetros.?

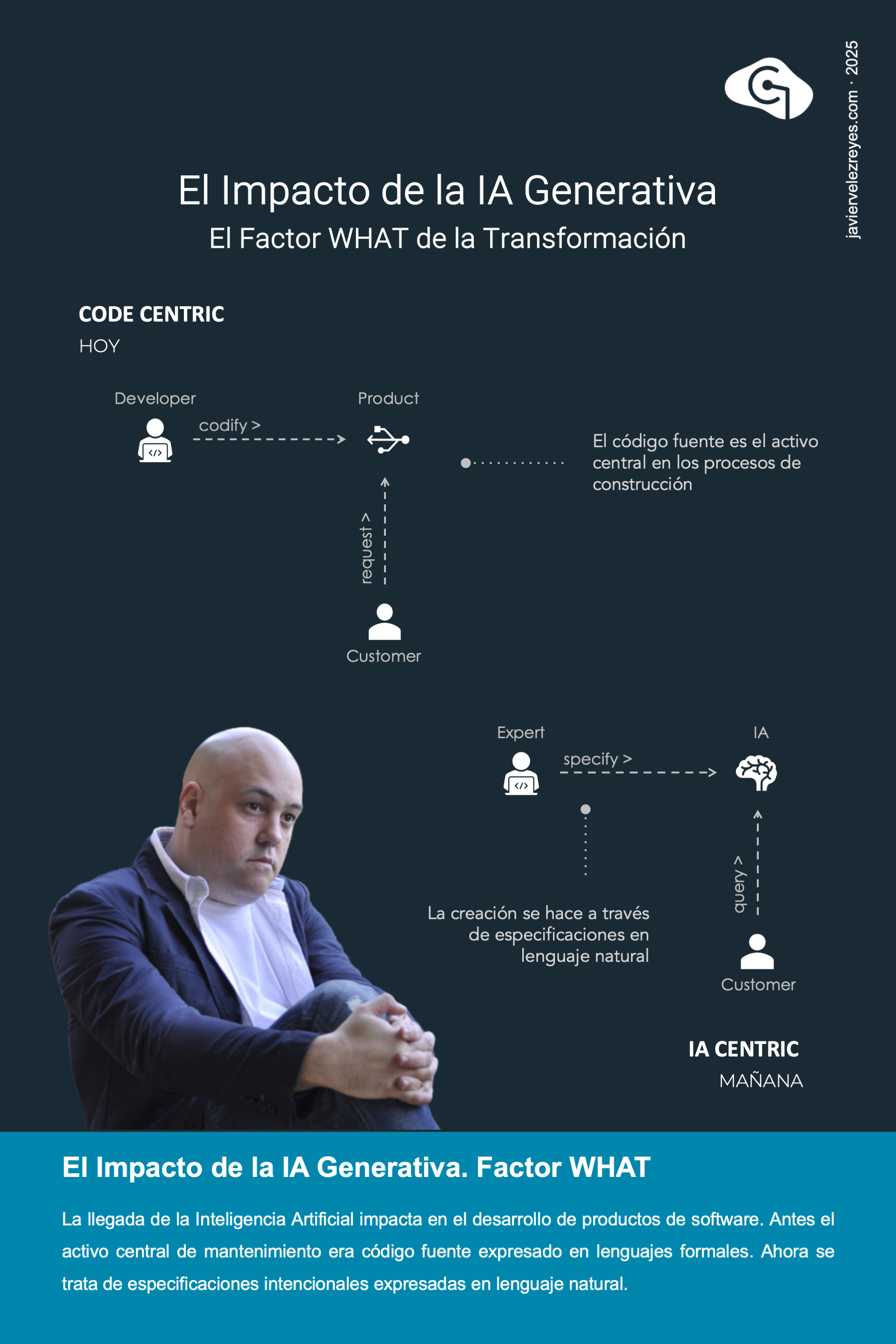

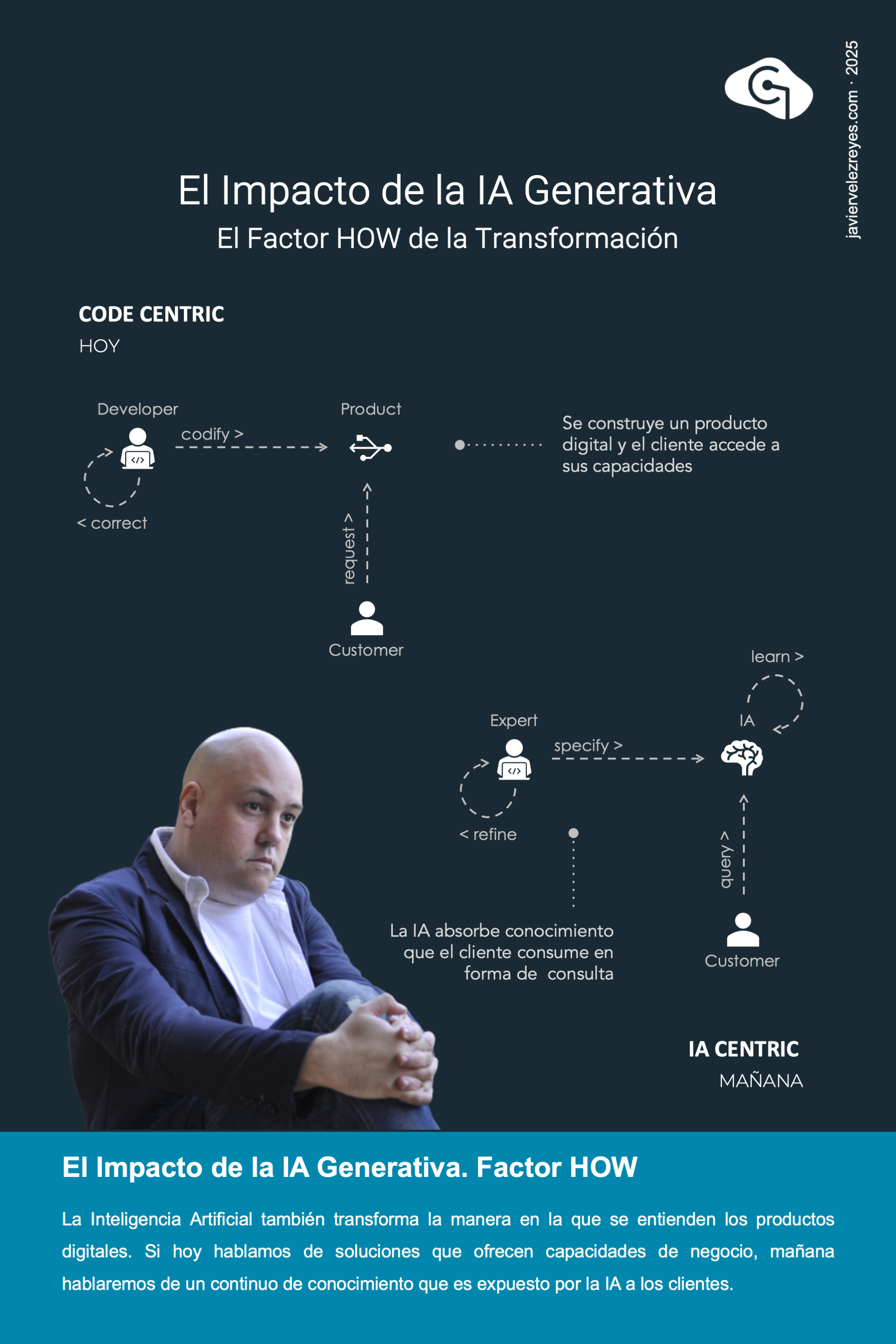

El espacio donde la llegada de la Inteligencia Artificial causará un mayor impacto gira en torno al tipo de productos que se construirán en el futuro y a cuáles serán los activos implicados en su construcción. Y es que es precisamente en este punto donde existe una confusión más generalizada. Se cree que el código fuente seguirá estando basado en especificaciones formales algorítmicas, Sin embargo, lo que verdaderamente constituirán es que los activos de valor digitales de un negocio u organización serán las especificaciones intencionales que dan forma al comportamiento emergente de sus arquitecturas centradas en Inteligencia Artificial.

Sobre el factor motivacional del cambio hacia un futuro digital centrado en la Inteligencia Artificial también hay mucha confusión. Aún creemos que los sistemas inteligentes serán asistentes al servicio de los humanos para ganar en productividad en sus tareas más rutinarias. Sin duda esa será una fuerte palanca de empuje. Pero el verdadero motivador para insertar la IA en los negocios aparecerá por la posibilidad de acortar intermediarios en la cadena de valor. Los sistemas inteligentes serán agentes con un comportamiento intencionalmente dictaminado por medio de especificaciones declarativas que se encontrará al servicio del cliente y del negocio. En el lado del cliente este tipo de agentes conformarán el canal de interacción principal con la organización. En el lado del negocio, este tipo de arquitecturas atesorarán de manera transversal todo el conocimiento e inteligencia empresarial necesaria para operar.

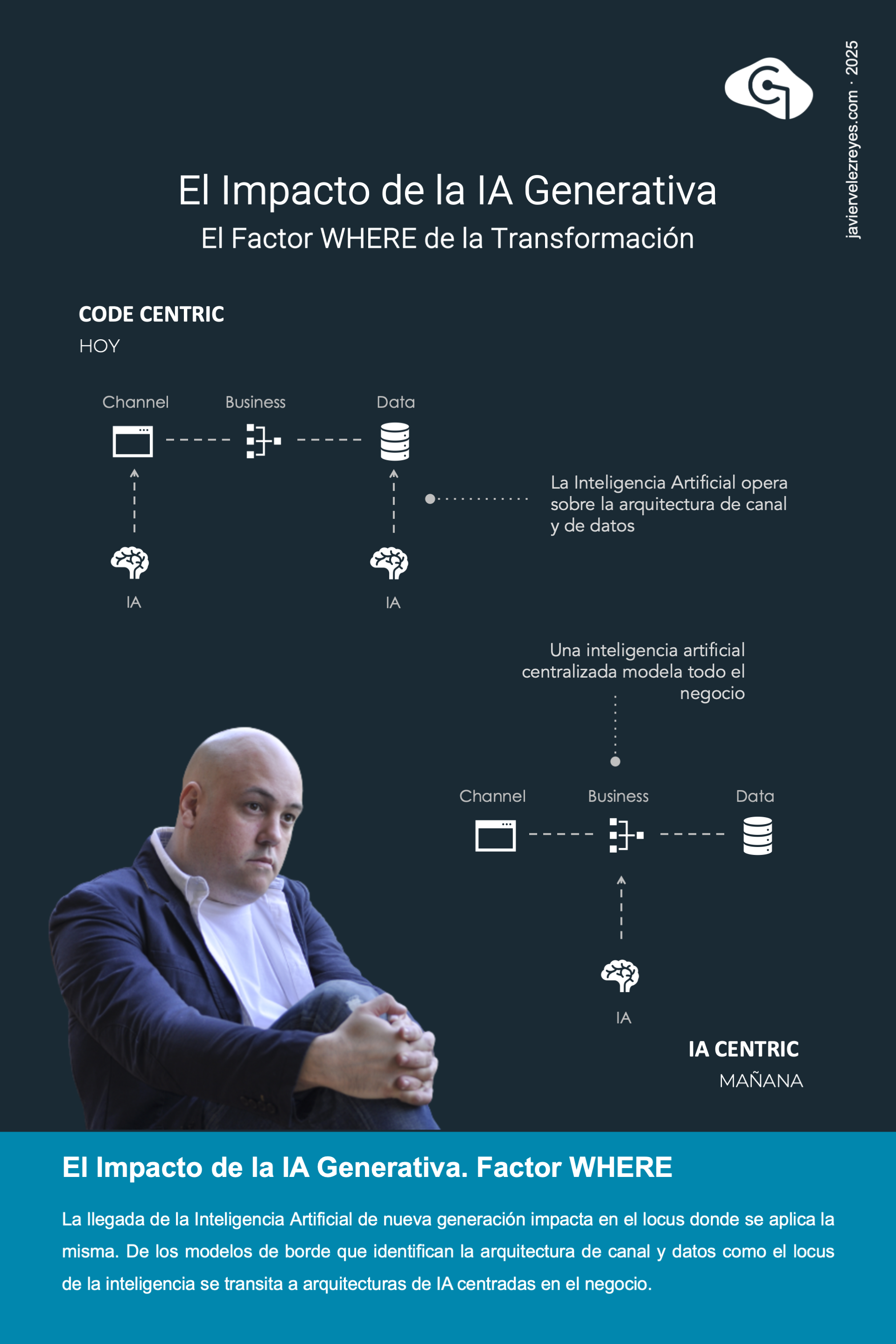

El locus de actividad de la Inteligencia Artificial Generativa también es un aspecto que genera grandes malentendidos. Es común encontrar voces que reclaman un espacio de actuación centrado los extremos de la arquitectura empresarial. Se dice que, o bien la IA será una herramienta que opera sobre la arquitectura de canales para mejorar los modelos de interacción y la experiencia de cliente, o bien se operará sobre la base de las arquitecturas de datos y persistencia especialmente centradas en hacer ingeniería analítica e inteligencia de negocio como ha venido ocurriendo de manera convencional. Si bien eso será una realidad de transición de los primeros estadios de la IA no lo será en absoluto a largo plazo. El nuevo paradigma de transición digital promoverá un modelo de arquitecturas donde la Inteligencia Artificial generativa sea el centro global que captura todo el conocimiento de negocio y es capaz de articula re manera fluida cualquier lógica de operación necesaria.

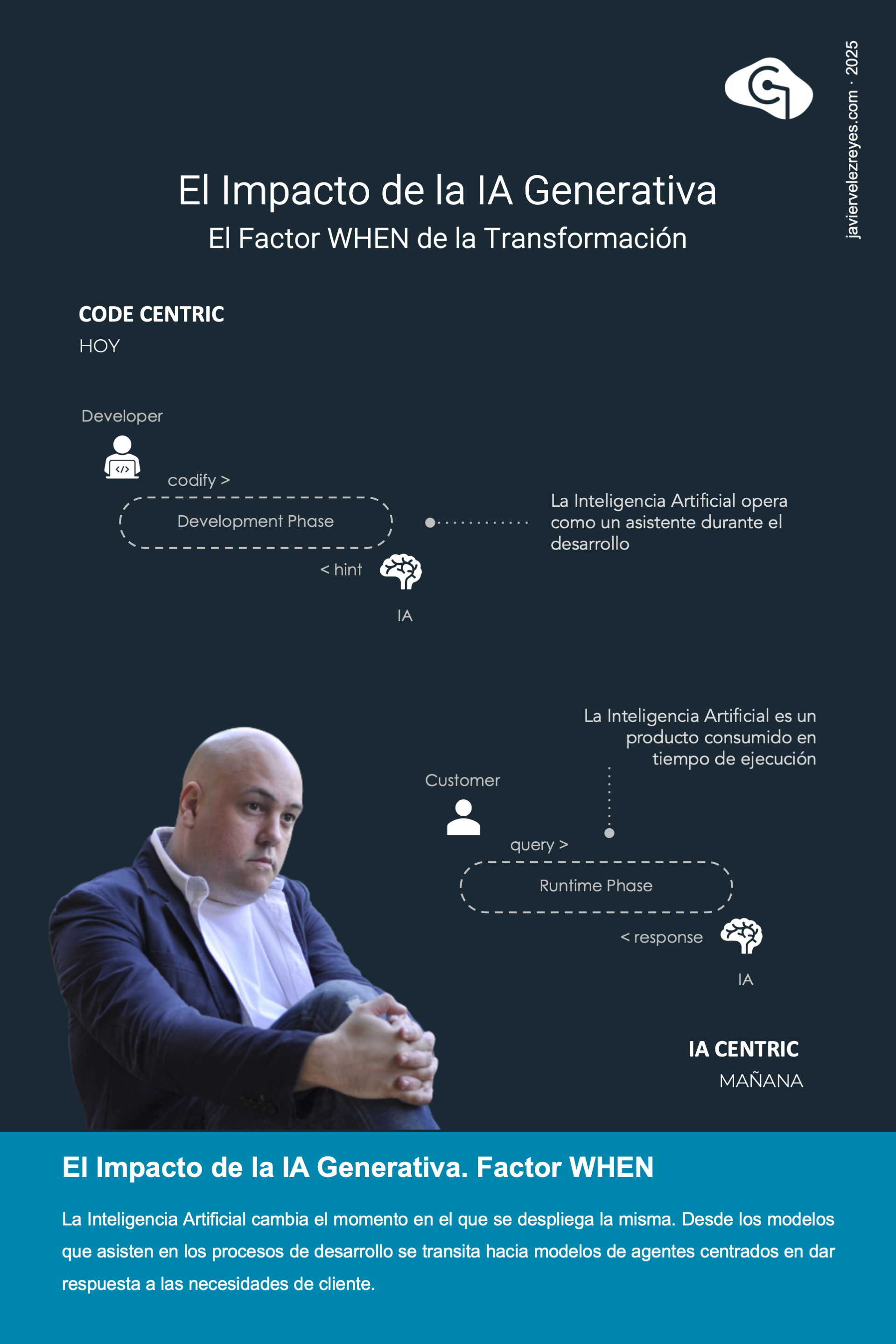

El espacio de tiempo donde la Inteligencia Artificial Generativa entrará en acción es otro de los elementos de fuerte discusión en la actualidad. Las voces más convencionales perciben la IA como un asistente que sólo ayudará en los procesos de construcción de productos de software liberando a los desarrolladores de las tareas más rutinarias y pesadas. Inteligencia Orientada al humano creo que lo llaman. Pero no, la Inteligencia Artificial es un potente activo que tendrá su espacio de intervención precisamente en tiempo de ejecución. En el transitorio ya encontramos soluciones de IA para asistir a crear productos convencionales de manera mas productiva. Pero el cambio de paradigma apuesta por un mañana en que la Inteligencia Artificial agentica será el verdadero artefacto sistémico que desarrollará la actividad empresarial manteniendo un diálogo vivo y contino con el cliente.

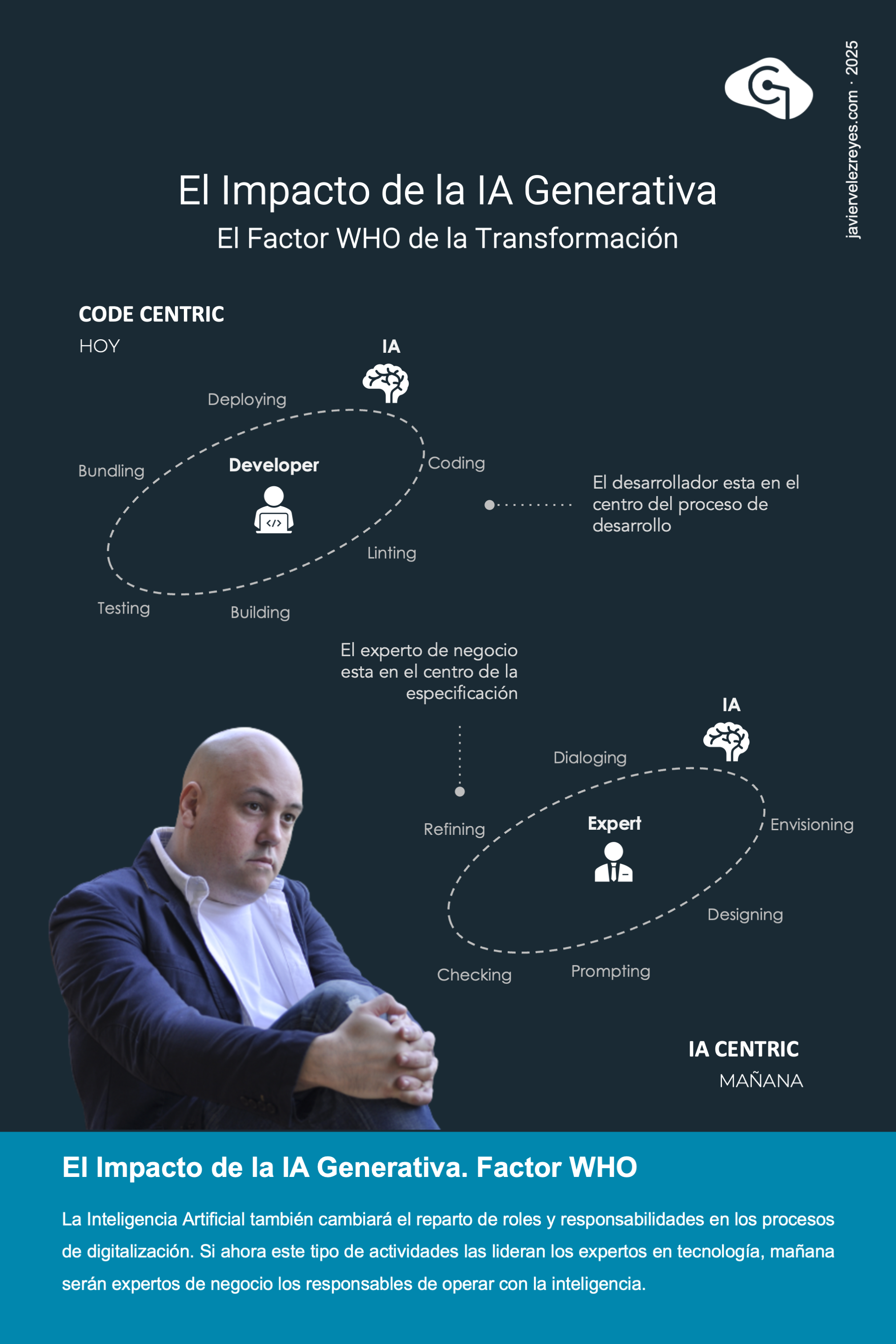

El espacio de actores implicados, sin lugar a dudas, es el mayor centro de impacto de la Inteligencia artificial generativa. Es aventurarse demasiado si decimos que los sistemas inteligentes del mañana acabarán con la profesión. Pero lo que si es una verdad tan posiblemente incomoda como insoslayable es que nuestro espacio de responsabilidad será desplazado. Al democratizar la especificación de comportamientos sistémicos inteligentes por medio de especificaciones intencionales expresadas en lenguaje natural parece que estamos cediendo nuestro espacio de técnicos expertos a los expertos de negocio, y esa es una realidad indiscutible que ya se está produciendo. Lo que parece que no advertirnos es que lejos de un perjuicio eso nos dará a los expertos en digitalización una dosis de oxigeno para podernos centrar en el diseño e ideación de productos desde una perspectiva más madura y sistemática. Es importante entender que el nuevo perímetro de acción requerirá de los técnicos habilidades en el diseño y desarrollo de productos dirigidos por un diálogo argumentativo e intencional. Esa es una nueva escuela que está aún por construir.

En no pocas ocasiones me han preguntado cuál es el camino de futuro de la Inteligencia Artificial. En mis últimas conferencias suelo usar este modelo de madurez para dar respuesta a esta pregunta. Asumiendo que todo este movimiento se popularizó a mediados de 2020 podemos reconocer 6 claros horizontes temporales dentro de este recorrido. A fecha de esta publicación, estamos entrando en la etapa deliberativa marcada por el uso masivo de cadenas de razonamiento profundo y ya se empieza a hablar de una subsiguiente fase operacional caracterizada por una inteligencia agentica capaz de operar de forma autónoma o supervisada en nombre del usuario. En las próximas semanas me gustaría repasar con vosotros cada una de las fases de esta hoja de ruta.

En no pocas ocasiones me han preguntado cuál es el camino de futuro de la Inteligencia Artificial. En mis últimas conferencias suelo usar este modelo de madurez para dar respuesta a esta pregunta. Asumiendo que todo este movimiento se popularizó a mediados de 2020 podemos reconocer 6 claros horizontes temporales dentro de este recorrido. A fecha de esta publicación, estamos entrando en la etapa deliberativa marcada por el uso masivo de cadenas de razonamiento profundo y ya se empieza a hablar de una subsiguiente fase operacional caracterizada por una inteligencia asistencial capaz de operar de forma autónoma o supervisada en nombre del usuario. En las próximas semanas me gustaría repasar con vosotros cada una de las fases de esta hoja de ruta.

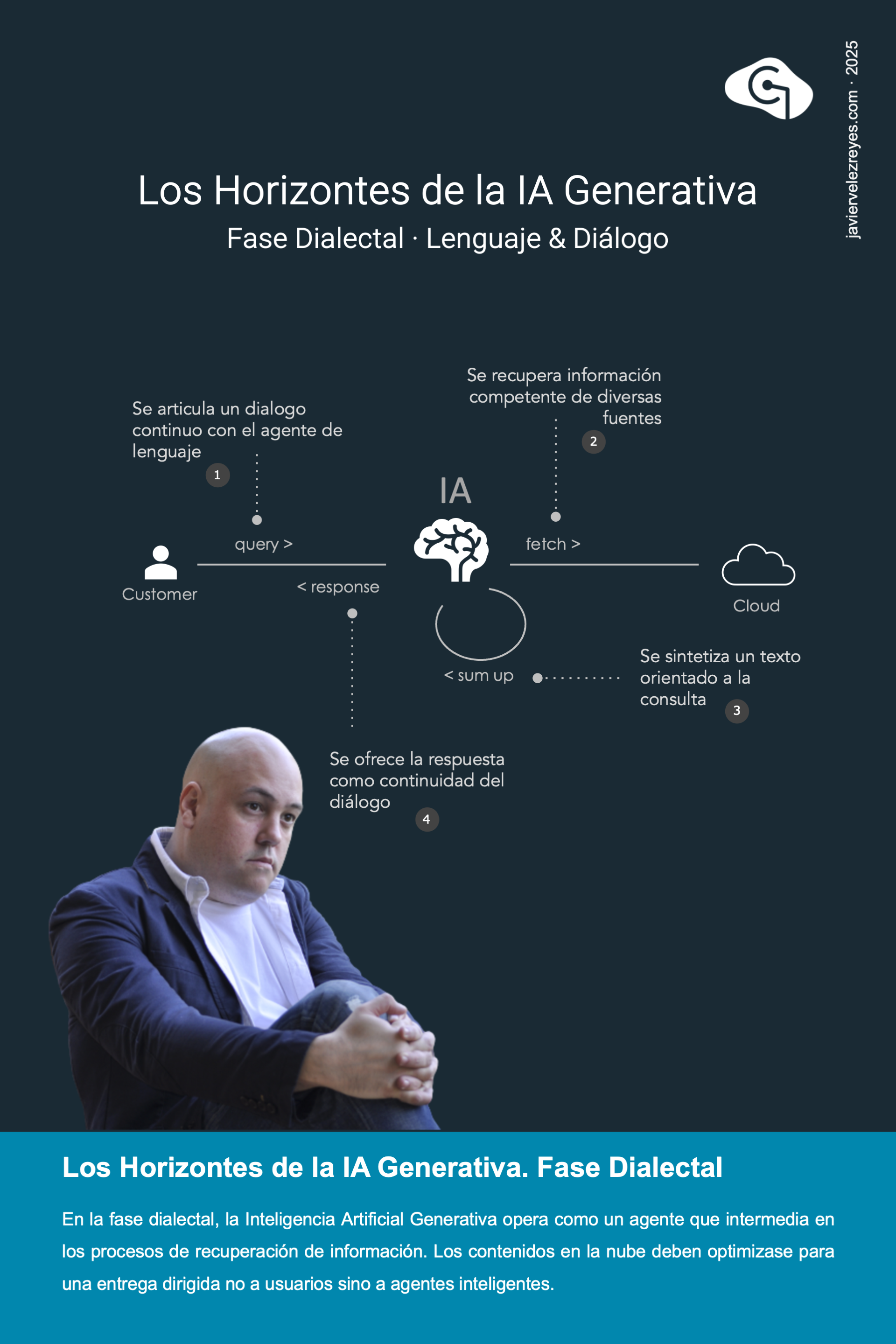

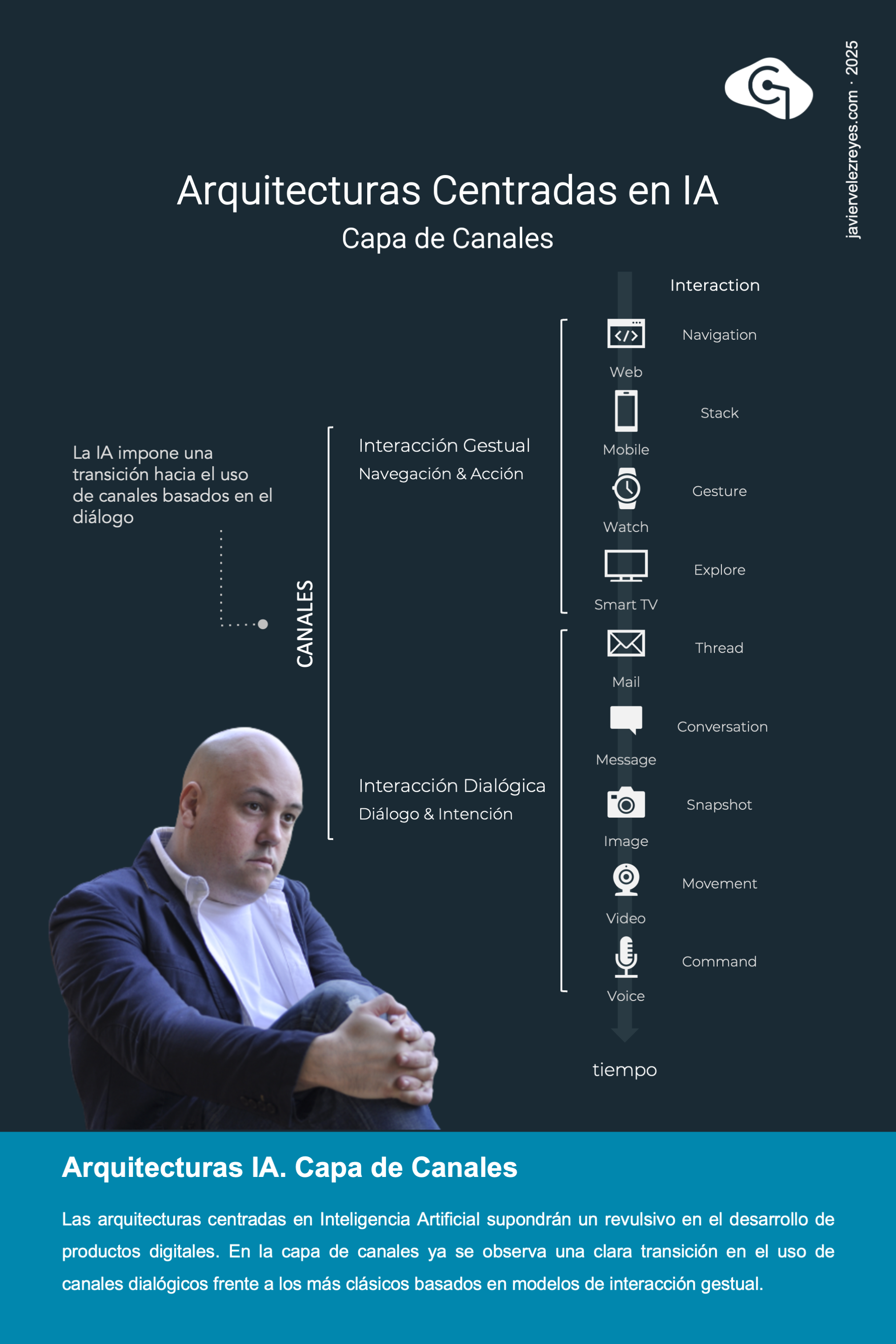

La fase dialectal de la Inteligencia Artificial cogió un fuerte momento allá por el año 2020. Hasta esa fecha los modelos de interacción hombre-máquina habían estado centrados en las metáforas de interacción exploratoria o atención micro-gestual. Sin embargo, la llegada de esta nueva corriente provocó que esos modelos dieran paso a una experiencia mucho mas centrada en la interacción dialógica continua basada en el lenguaje natural y en las expresiones argumentativas. Aún es pronto para asentar los inicios de un paradigma de experiencia de uso. Pero lo que si está claro es que en los próximos años la interacción dialógica cogerá eje de centralidad en detrimento de los modelos anteriores. Taz vez el equilibrio orgánico de esos 3 modelos será lo que más se parezca al diseño de producto del futuro.

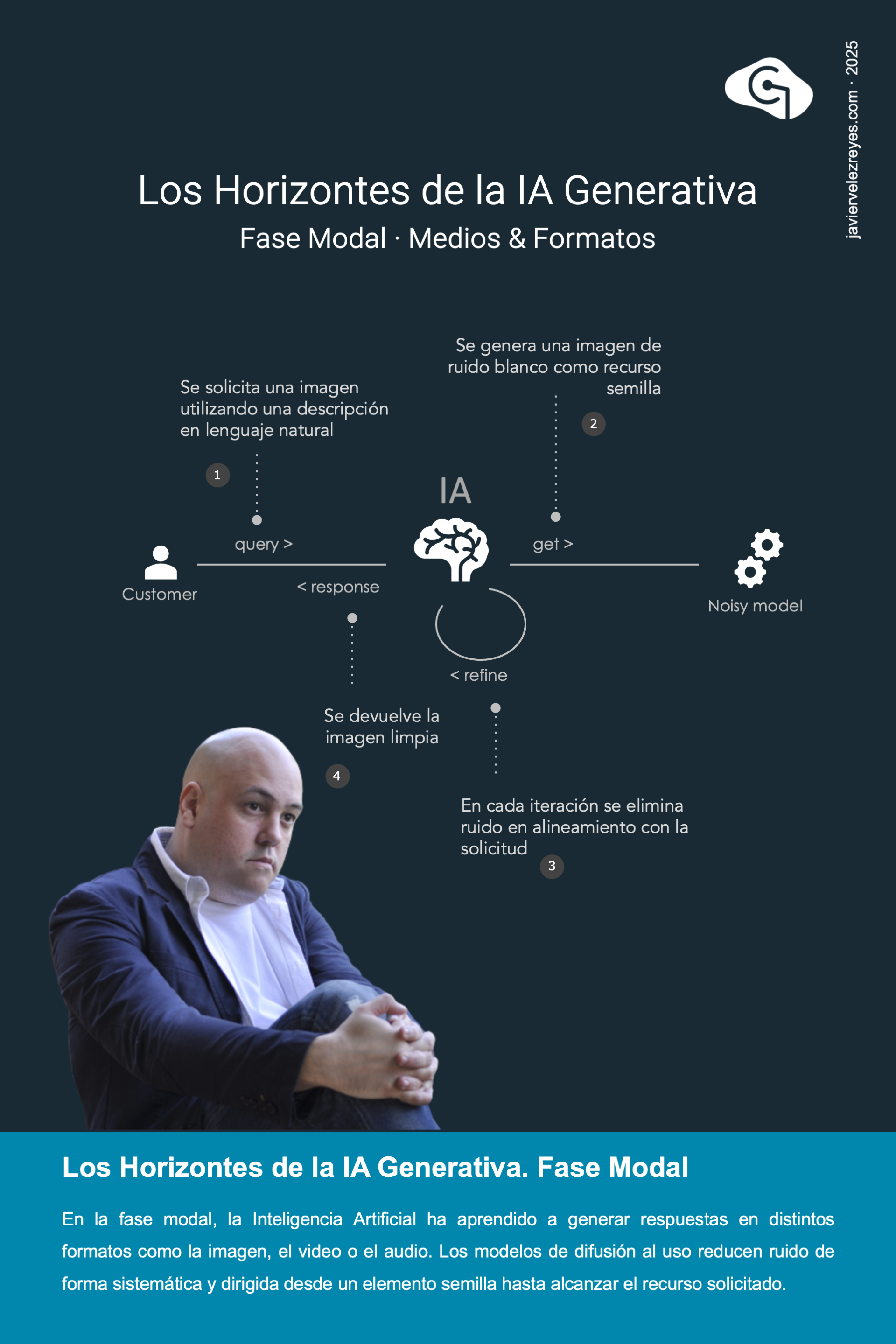

En el horizonte H1 de Inteligencia Dialectal, los modelos de lenguaje habían cambiado el paradigma de interacción de la nueva era de productos digitales. Sin embargo, esta interacción esta fuertemente centrada en el procesamiento de texto. Necesitábamos dar un nuevo paso de gigante para hacernos entender con nuestras máquinas en toda suerte de formatos modales, desde una locución de voz o un audio hasta una imagen o un video. Este fue un salto cualitativo importante en la carrera de futuro de la Inteligencia Artificial y se marca como horizonte modal H2 dentro del modelo de madurez. Por que lo cierto es que hasta la llegada de las inteligencias multimodales, todas las entradas de recursos de medios tendrían que traducirse previamente a texto para poder ser convenientemente interpretadas por un motor de lenguaje.

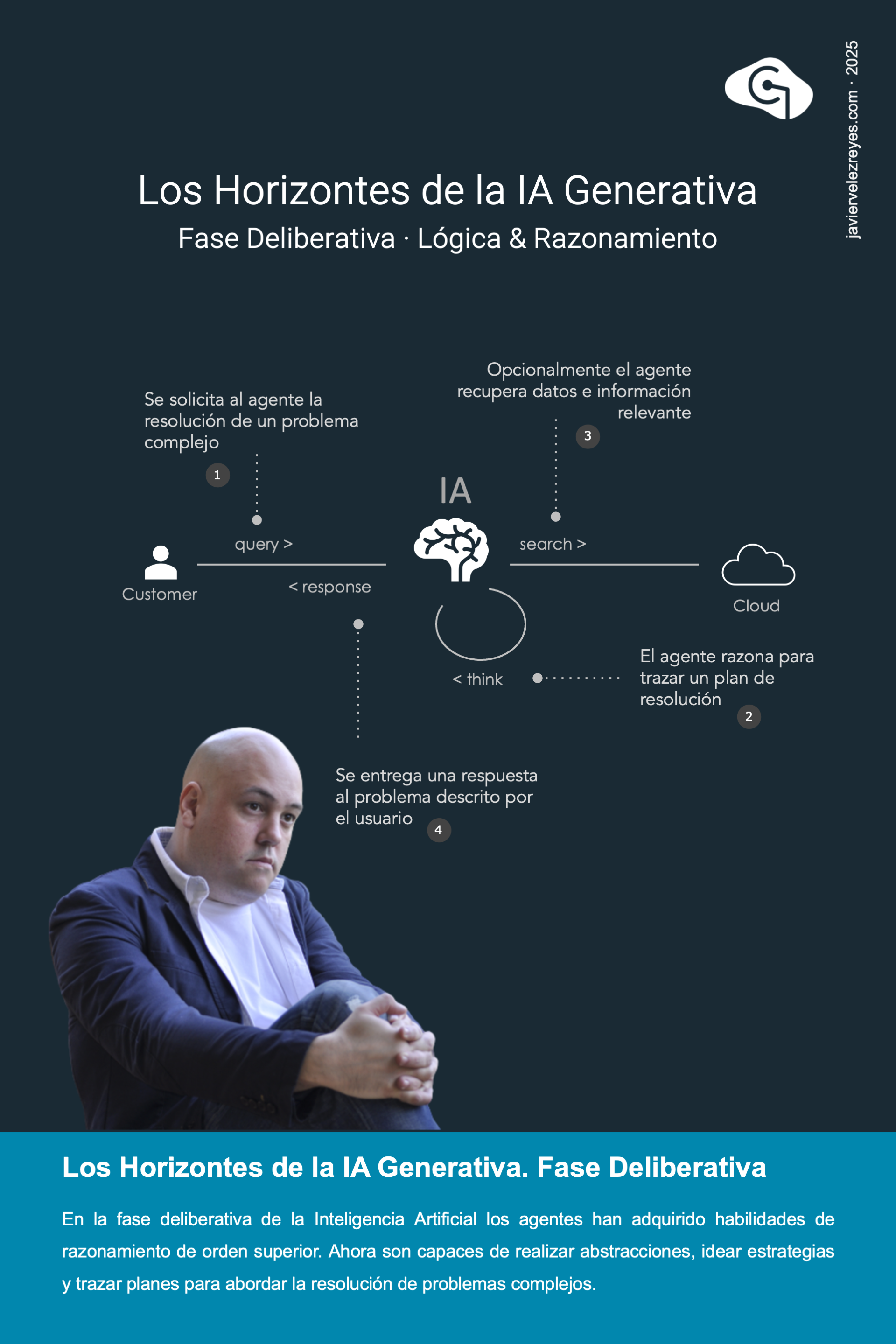

Los modelos de lenguaje habían crecido hasta dimensiones inconmensurables. Parecía que la Inteligencia Artificial había tocado techo nuevamente y las voces expertas de fabricante anunciaban que el aumento en capacidad de comportamiento inteligente ya no era cuestión de mas carga neuronal. En lugar de eso teníamos que enseñar a nuestros sistemas a pensar. Por medio de la introducción de cadenas, árboles y grafos de razonamiento, la Inteligencia Artificial adquiriría habilidades en la descomposición de problemas, la planificación o la exploración estratégica, lo que se traduciría en mejores resultados incluso en modelos más pequeños y baratos. Había llegado el horizonte H3 de la Inteligencia Artificial Deliberativa según como se posiciona en el modelo de madurez. Aún estamos inmersos en esa carrera de mercado y cada vez sorprenden más los resultados obtenidos.

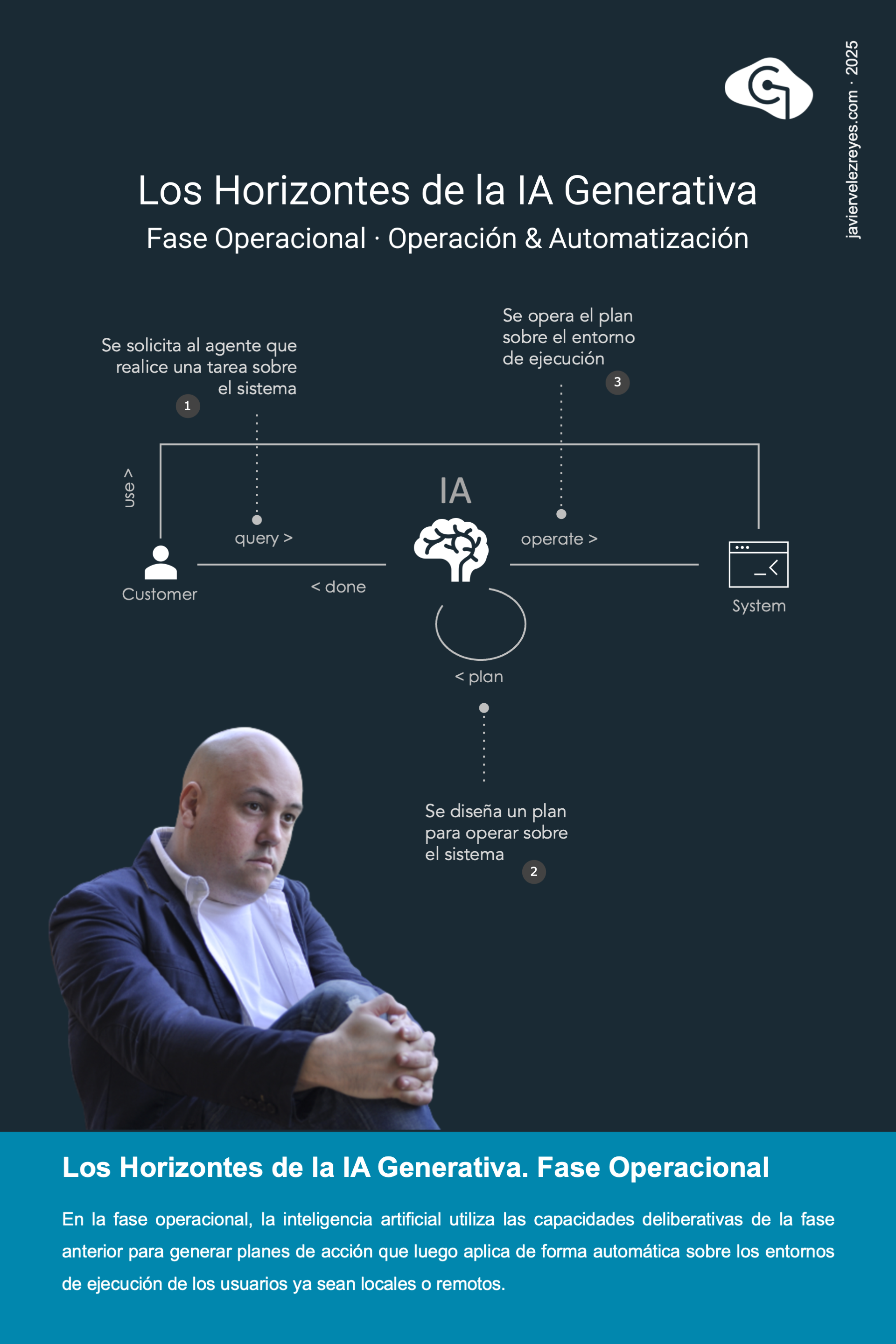

La Inteligencia Artificial va camino de convertirse en una verdadera herramienta operativa que nos asista en la realización de tareas complejas. Reservar las butacas para un teatro, planificar las vacaciones gestionando vuelo, estancia y ruta de ocio, organizar el trabajo, responder a nuestros correos, levantarnos con un resumen de la prensa cada mañana. Todo ello son tareas que la IA operacional puede resolver por nosotros. Este será el siguiente paso que aparece como horizonte H4 dentro del modelo de madurez. Ya se empiezan a vislumbrar los primeros pilotos autónomos que son capaces de articular tareas complejas con perfecta eficacia. Inmersos en ese momento que nos dobla la esquina, nos parecerán extraños los días en los que la Inteligencia Artificial era poco más que un asistente de recuperación de información en Internet.

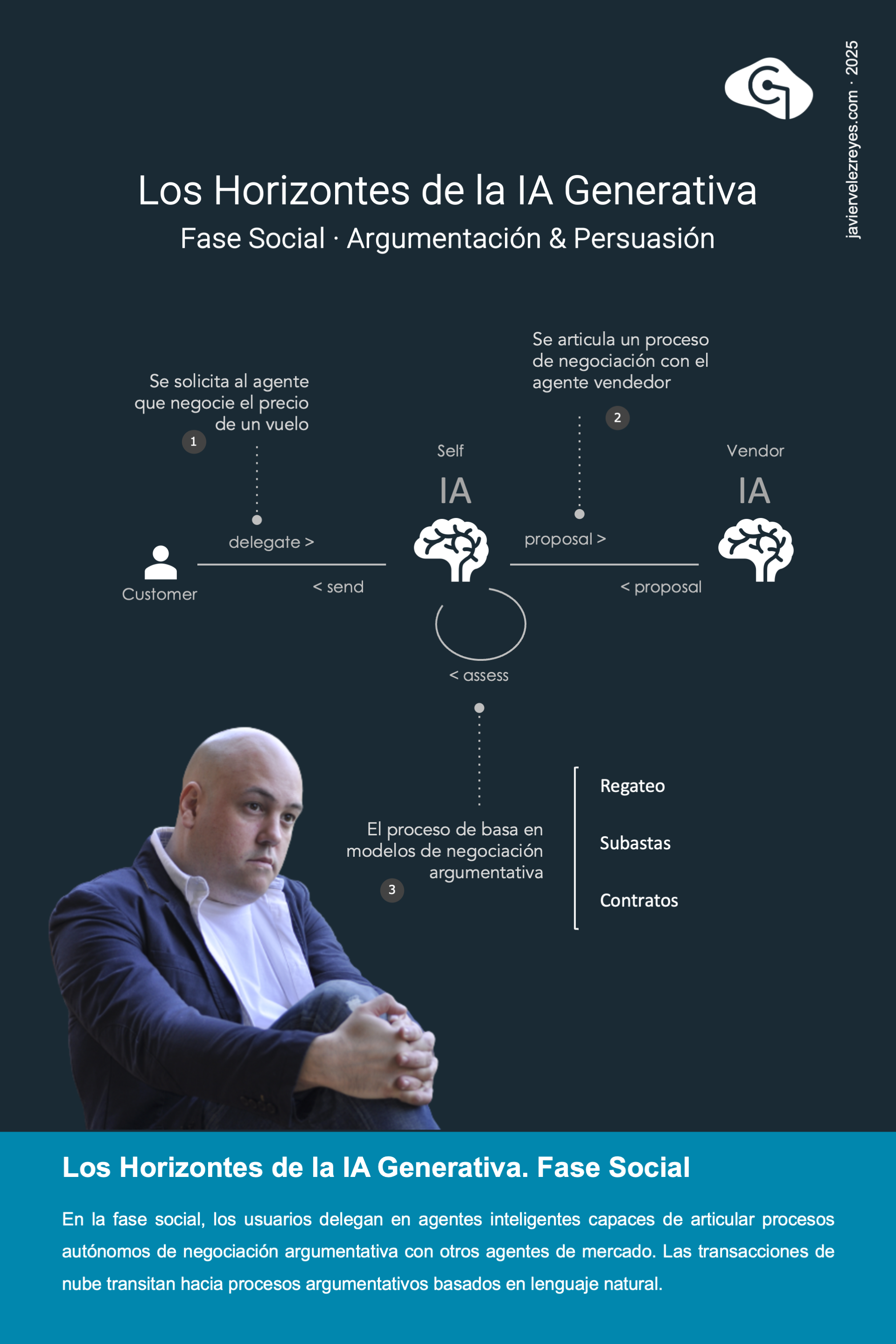

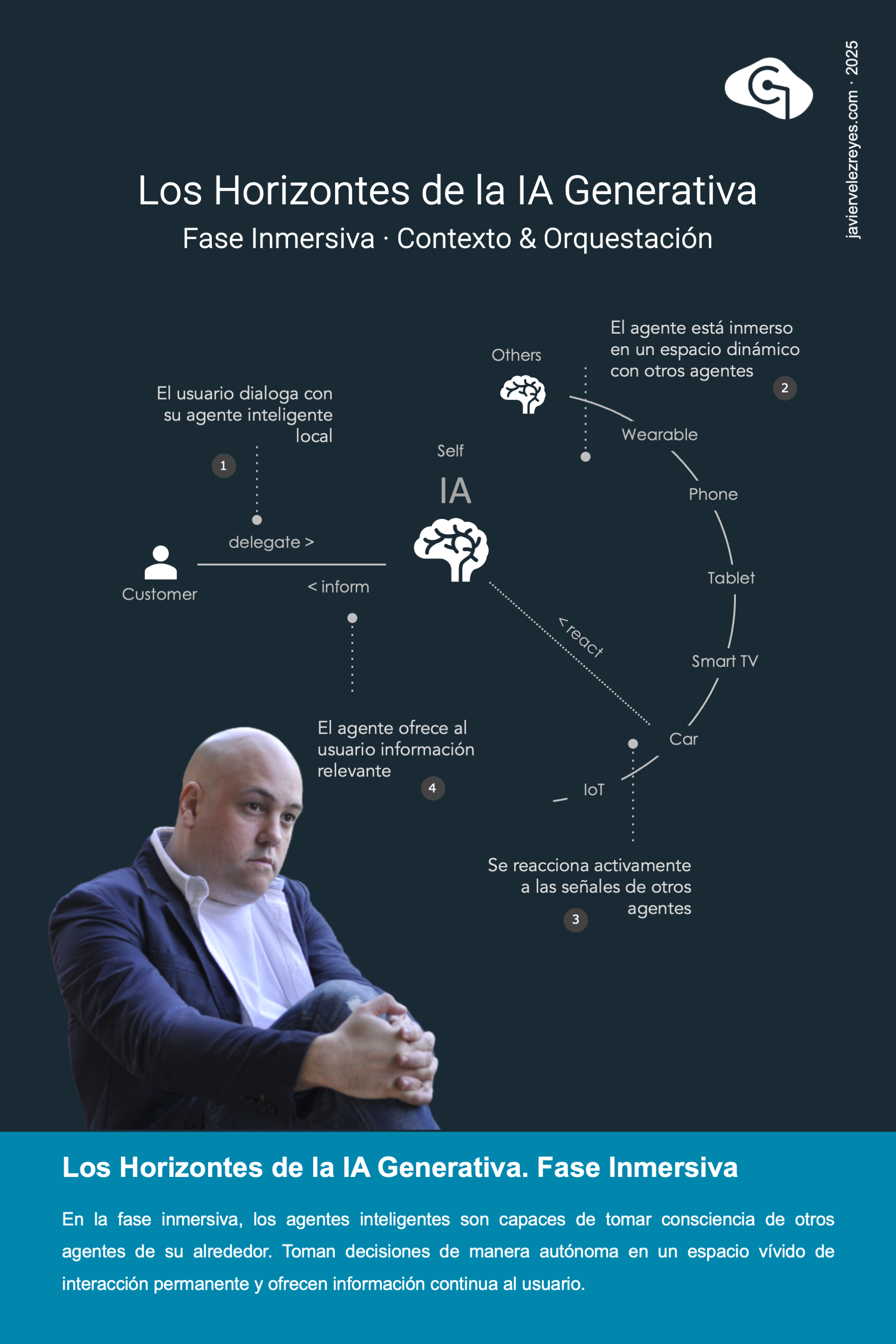

La Inteligencia Artificial se habrá desplegado al plano social cuando alcancemos el horizonte H5 del modelo de madurez. No es un juego de oráculo sino la transición natural de haber alcanzado la inteligencia operacional en la fase anterior. Las soluciones de IA, que hasta la fecha habían mantenido un forzado enfoque monolítico, se convierten ahora en verdaderas arquitecturas modulares con inteligencias locales moduladas en forma de agentes especializados que resuelven problemas complejos ejecutando protocolos de interacción, coordinación y cooperación. Se abre la puerta a un nuevo tipo de arquitecturas de inteligencia distribuida donde la unidad de especialización es el agente inteligente y la ejecución de protocolos el medio para la consecución de unos objetivos compartidos.

Alcanzado el horizonte H6 de la fase inmersiva, la Inteligencia Artificial Agentica se habrá convertido en una realidad cotidiana que permea cada pequeño espacio de nuestras vidas. De manera autónoma, continua y transparente los agentes en nuestros relojes, tabletas, televisores, teléfonos, aparatos de cocina, coches, semáforos y un largo etcétera interactuarán negociando acciones y se coordinarán para poder dar respuesta a las necesidades del usuario. Viviremos, por ejemplo, experiencias protagonizadas por vehículos autónomos que se coordinan con otros coches en la carretera para ofrecernos un servicio de desplazamiento donde los humanos sólo tendremos que relajarnos y disfrutar del trayecto. Otros escenarios podrán imaginarse. Parece una realidad lejana propia de una ficción distópica y futurista. Pero lo cierto es que al ritmo de avance de nuestros progresos en Inteligencia Artificial este tipo de escenarios puede no estar tan lejos.

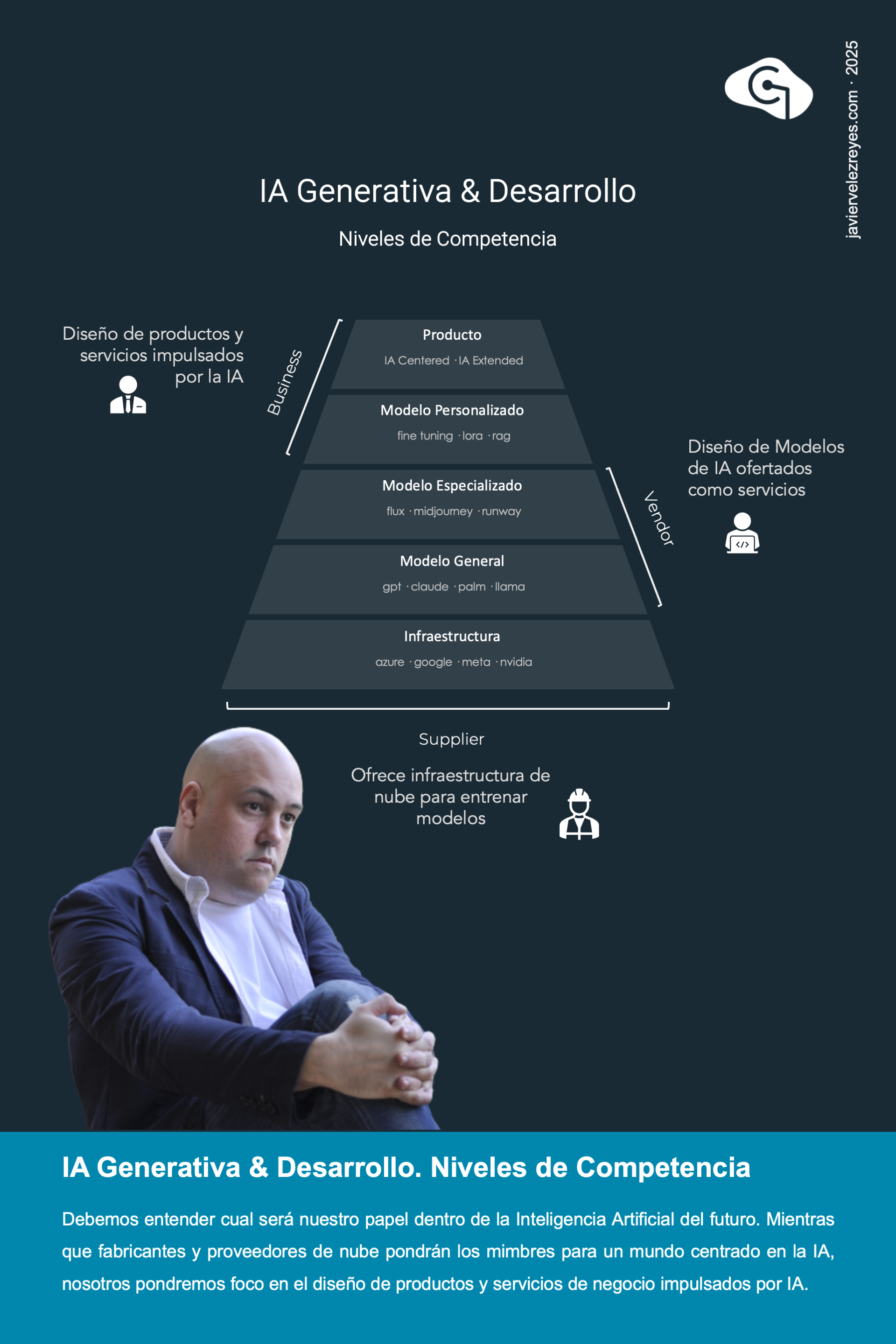

Mira el hoy con ojos de mañana. Ni somos ni seremos fabricantes de modelos de lenguaje fundacionales. Tampoco proveedores de infraestructura de soporte. Nuestro papel es y será entender, atender y resolver las necesidades de nuestro mercado y nuestros clientes. Y todo ello deberemos hacerlo usando inteligencia y si se quiere artificial. Pero su construcción, la creación de modelos, su entrenamiento y refinamiento es algo que reside en manos de terceros. Puede parecer una trivialidad pero lo cierto es que veo mucho falso profeta invitando a adquirir competencias sobre espacios que no nos pertenecen. Decidir como serán los productos de futuro, los valores y creencias en los que se basan, su pragmática de uso y aplicación y los procesos de vehiculizarción hasta cubrir necesidades es una aventura que siempre estará reservada a nosotros, los expertos y los técnicos del nivel de negocio.

Podrá parecer una tontería pero en pro de una defensa de la seguridad muy mal entendida son muchos los clientes y técnicos que abogan por una Inteligencia Artificial desplegada de manera personalizada y en local. Cierto es que la inteligencia local tiene su espacio en este panorama pero esta reservada para pequeños modelos de lenguaje desplegados en wearables y dispositivos personales e incluso herramientas de escritorio. Pero dentro del ámbito empresarial donde nos centramos en esta discusión, el hospedaje de los grandes modelos de lenguaje debe estar a cargo de grandes proveedores de nube. A la postre, son ellos los únicos que tienen infraestructura suficiente para correrlos y entrenarlos. Ni tu ni yo estamos en este nivel.

El uso de modelos generalistas, descargados directamente de un marketplace como base para la creación de modelos de negocio personalizados por medio de técnicas de entrenamiento propias de la ciencia de datos, como LoRA o fine tunning, es una práctica equivocada relativamente habitual. Los arquitectos de negocio debemos entender que nuestra responsabilidad no cae dentro de este perímetro. Muy al contrario, nuestra labor será consumir grandes modelos de lenguaje expuestos como servicios en la nube. No debemos incurrir en el error de competir con los grandes vendors de mercado. Ellos tienen tiempo dedicado, hordas de ingenieros de Inteligencia Artificial muy especializados, grandes recursos y contratos privilegiados con los proveedores de infraestructura que nosotros nunca tendremos.

En el nivel de producto, las organizaciones encuentran el espacio de acción para dar satisfacción a sus necesidades. Es precisamente dentro de este perímetro donde nuestra labor como arquitectos empresariales coge un mayor protagonismo. Nuestra misión es entender el offering de capacidades ofrecido por los grandes players de mercado y consumirlo en forma de servicios en la nube. A diez mil pies de altura este camino pasa por conectar la Inteligencia Artificial general o especializada a los perímetros informacionales y operacionales de la compañía usando técnicas RAG y CMP respectivamente. Después el producto se crea, esencialmente, a través de esfuerzos de especificación intencional expresados en lenguaje natural para crear el modelo de comportamiento de producto deseado.

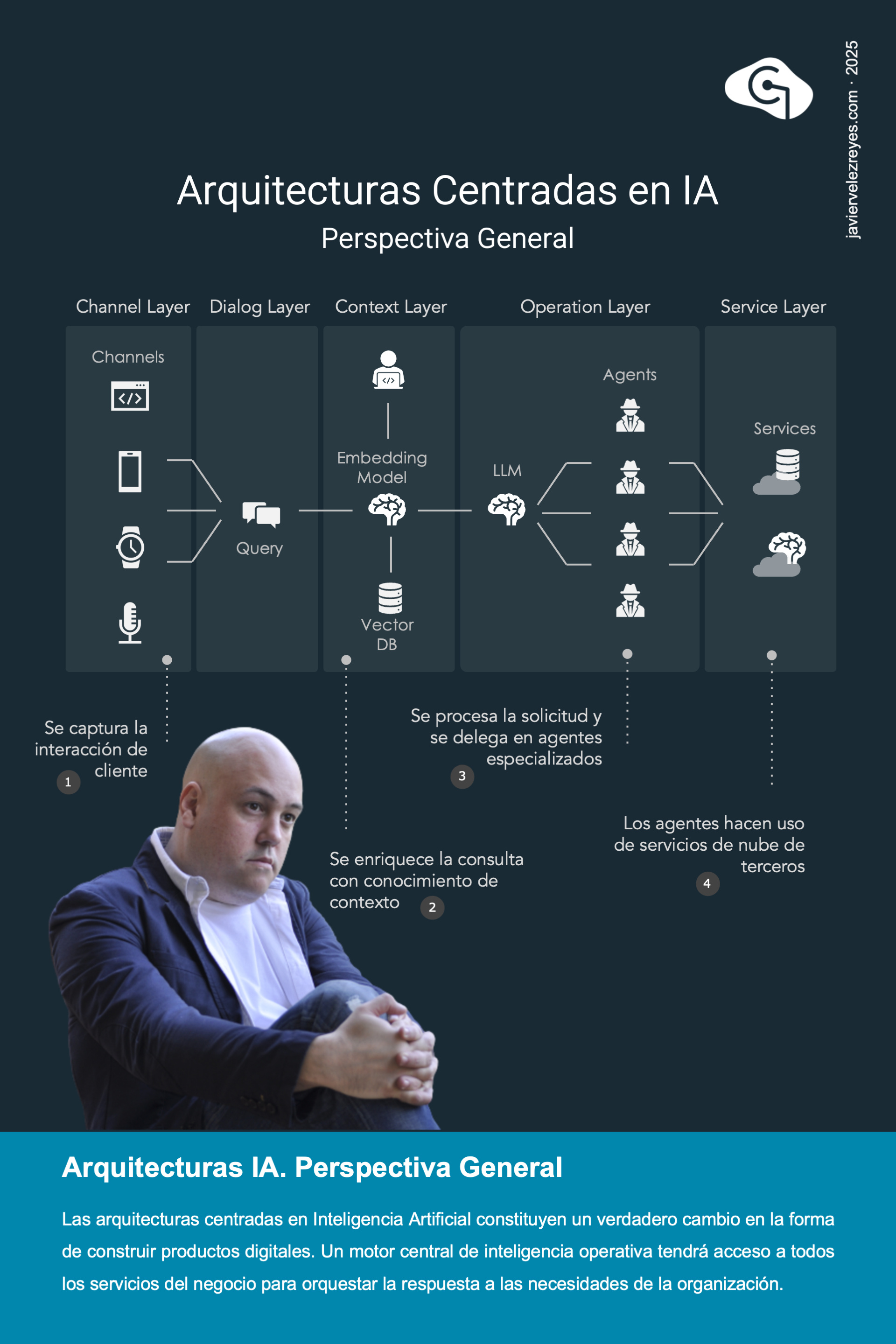

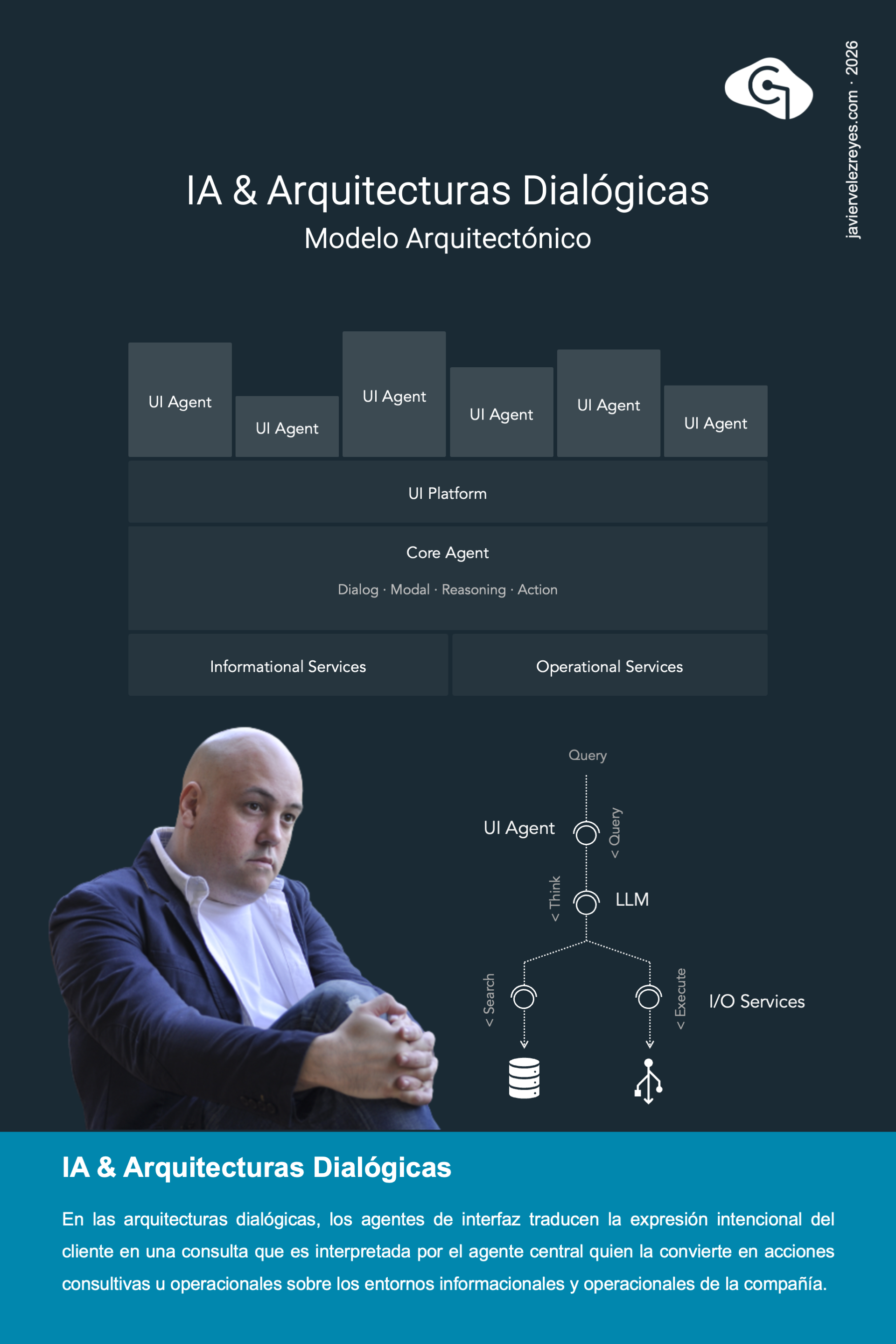

La llegada de la Inteligencia Artificial Generativa supondrá un cambio disruptivo en la conceptualización arquitectónica que venimos haciendo de los productos digitales de negocio. Bajo este nuevo paradigma, un motor central de inteligencia operativa tendrá competencia de acceso a cada una de las capacidades y servicios de la organización y su acceso a los mismos por parte de los clientes se modulará en base a un diálogo fluido e interactivo basado en lenguaje natural. Sobre este nuevo espacio es necesario poner esfuerzo en descubrir modelos, principios, patrones técnicas y mecanismos. De momento, me gustaría compartir con vosotros este nuevo marco de referencia arquitectónico que he ideado y entrar a discutir cada una de las capas del mismo en las próximas semanas.

Sobre la arquitectura de canales de cualquier organización, la llegada de la Inteligencia Artificial Generativa y Agentica tendrá un sonado impacto. Los modelos de interacción basados en exploración sistemática y micro-atención gestual cederán protagonismo a aquellos orientados a la interacción dialógica continua así como también ocurrirá con los canales orientados a unos y otros modelos. La transformación digital hacia la Inteligencia Artificial supondrá, sobre estos perímetros, encontrar nuevos mecanismos y palancas de interacción centrados en el diálogo, y el diseño de productos digitales tendrá que adaptarse bajo el espacio de uso de tales palancas. Los conceptos de experiencia fluida en entornos de una omnicanalidad inmersiva multimodal cogerán más fuerza que nunca hasta tal punto de que probablemente se cambie la anatomía de los dispositivos de acceso según hoy los conocemos.

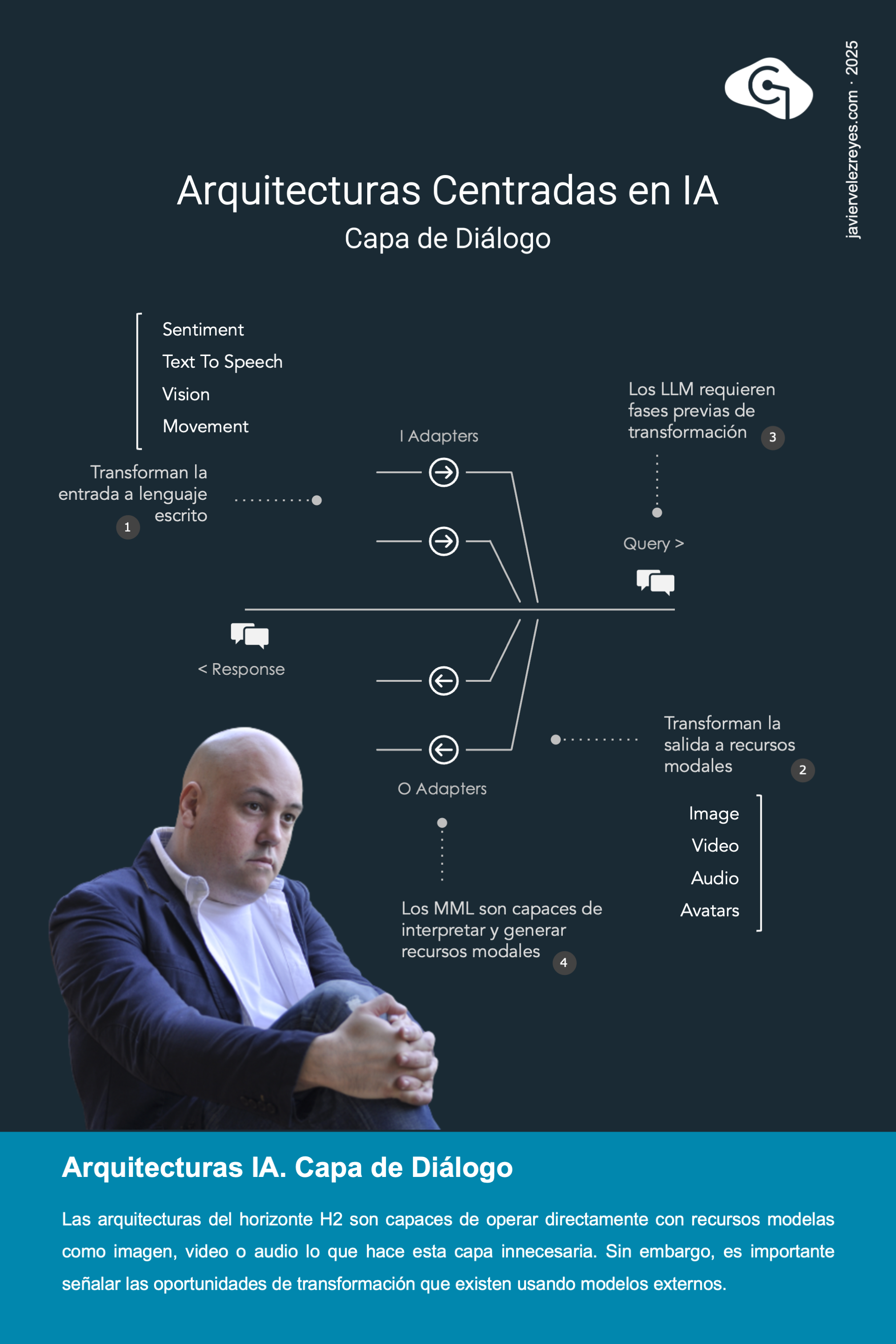

Las interacciones que nos llegan desde la arquitectura de canales alcanzan la capa de diálogo. Si fuera necesario, estas entradas atraviesan motores especializados de Inteligencia Artificial Adaptativa que convierten señales modales de audio, imagen o video para transformarlas en mensajes de texto digeribles por el motor central de procesamiento. Un esfuerzo simétrico ocurre en el procesamiento de las señales de salida provenientes de dicho motor que requieren una adaptación de la respuesta de texto hacia salidas modales. Este es el relato para arquitecturas basadas en LLM del horizonte H1 de la Inteligencia Artificial. Pero con el uso de modelos modales del horizonte H2 estas fases preliminares de transformación ya no resultan necesarias. Además de esto, el mantenimiento de la sesión de diálogo también es parte de la responsabilidad de esta capa.

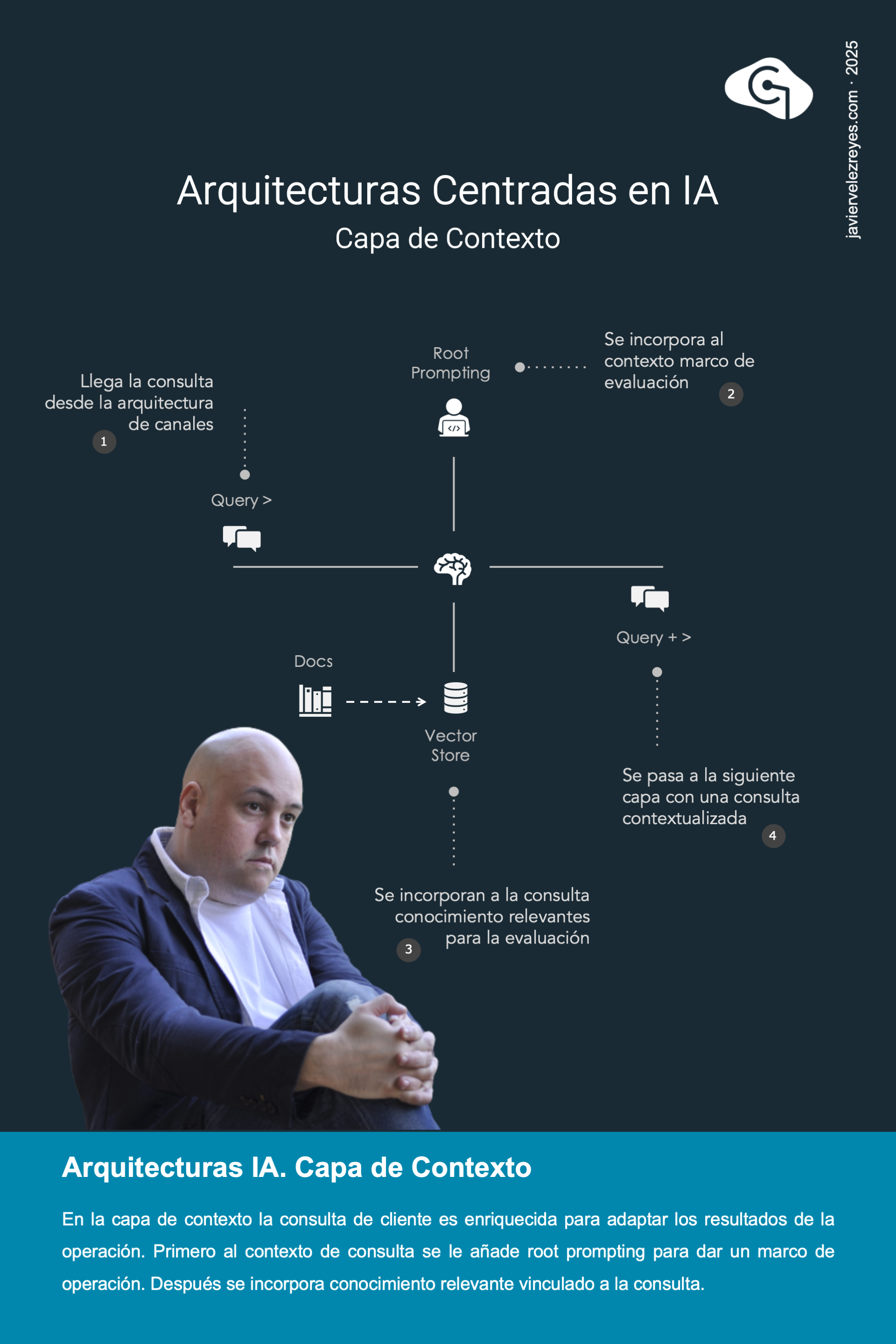

Tras la fase de diálogo nos llega una consulta convenientemente modulada desde las interacciones de cliente. Ahora es el momento de abrigar esa consulta de entrada con un contexto enriquecido que proviene de diferentes puntos de intervención. En primer lugar, la consulta se transforma para encajarla en un marco de pregunta según lo establecido en el diseño intencional de la interacción. En segundo, la consulta se enriquece con el contexto de conocimiento local competente para la naturaleza de la consulta formulada de acuerdo a la técnica de Retrieval Augmented Generation o RAG. Esta capa de contexto es fundamental para centrar el modelo de razonamiento de la arquitectura en el marco de conocimiento especializado del negocio.

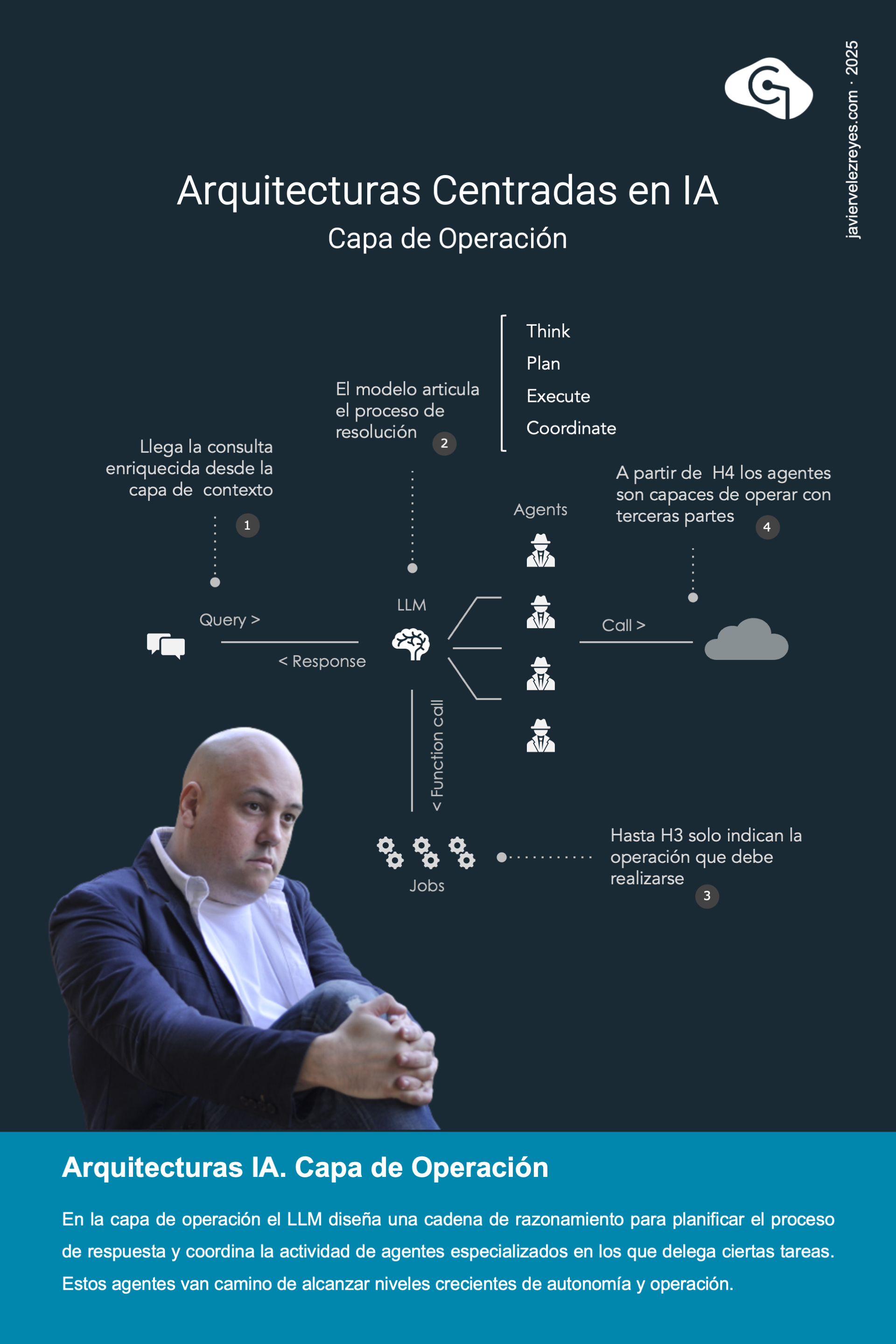

La capa de operación es la parte nuclear del modelo de referencia que venimos presentados. De la capa anterior nos llega una consulta elaborada que proviene de la interacción del cliente y el proceso de interacción anterior. Ahora esa consulta debe ser procesada por el modelo de lenguaje para cuya resolución debe realizar un plan de acción cuya ejecución implicará a una colección de agentes inteligentes con conocimiento operativo especializado. En los horizontes dialógico y modal (H1 y H2) las capacidades de resolución están centradas en la generación directa de resultados. Al usar modelos deliberativos del horizonte H3 la inteligencia será capaz de diseñar cadenas de razonamiento elaboradas para trazar un plan. Hasta ese punto los agentes serán solo informadores de acciones a realizar (function calling). Pero a partir del horizonte operativo (H4) éstos tendrán la capacidad de atender de manera autónoma sobre cada una de sus tareas encomendadas.

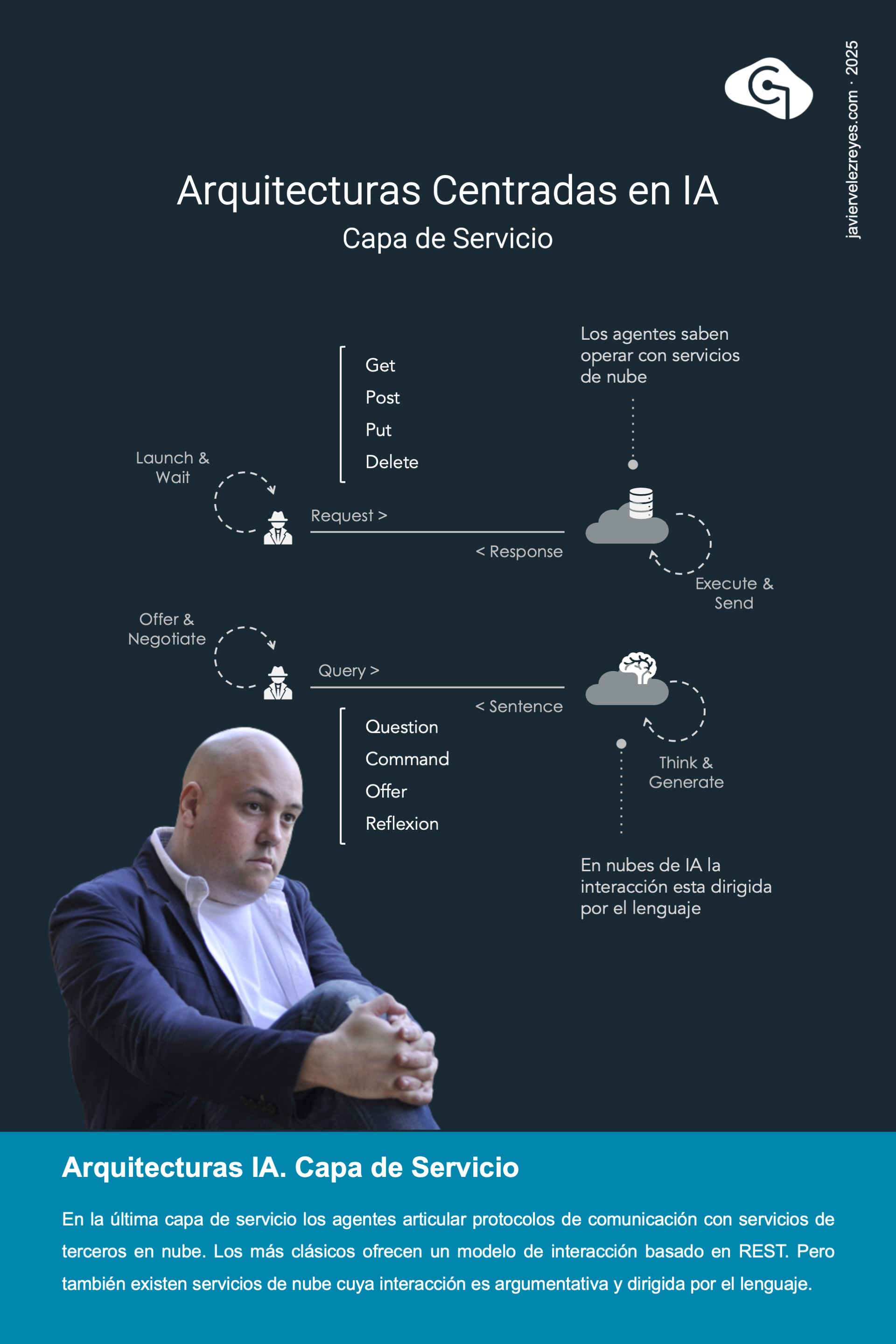

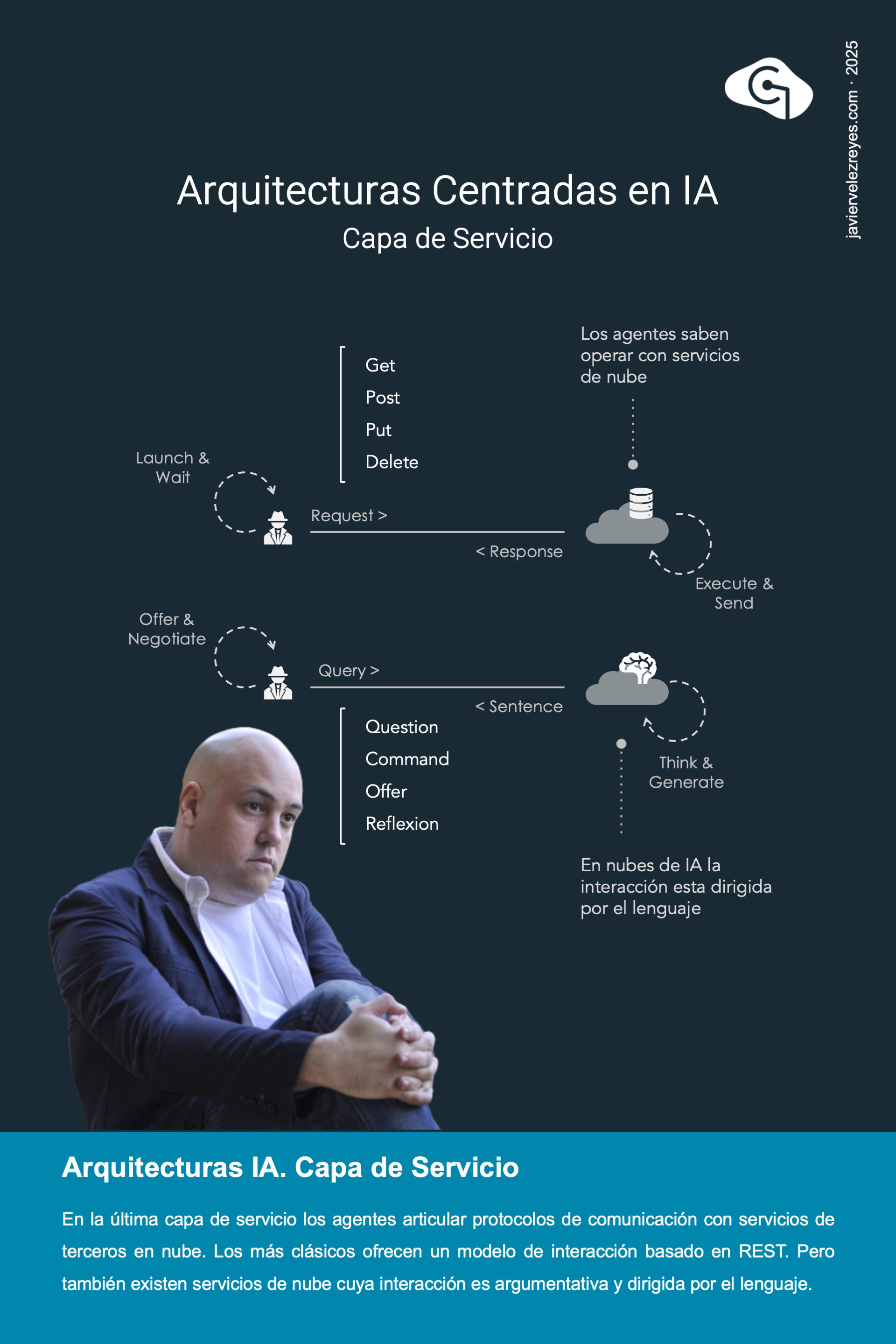

Los comandos generados en la capa de operación llegan de manera remota a nuevos servicios ofrecidos públicamente en la nube de Internet. Si hasta ahora los protocolos de interacción en red se limitaban a un modelo de comandos, ahora un nuevo espacio de servicios convivirá con los anteriores. Se tratará de agentes de nube capaces de articular procesos de negociación basados en un intercambio fluido y convergente de mensajes argumentativos. Del lado de la capa de operación anterior eso significará que es posible asimismo distinguir agentes de operación que centren su operativa en el uso de comunicaciones REST convencionales centradas en comandos y otros que se orientarán a levantar canales de comunicación dialógica intencional. Con el tiempo es de esperar que este segundo tipo de interacciones vaya ganando terreno a los modelos de la generación anterior.

A lo largo de todo el año 2025 hemos hecho un recorrido por los principales puntos de toque de la Inteligencia Artificial. Comenzamos posicionando la IA en el marco evolutivo de los modelos de experiencia de usuario, separamos polvo de paja al posicionar esta corriente de inteligencia artificial dentro del espacio conexionista, presentamos sus fundamentos teóricos hablando del modelo de neurona artificial y de sus modelos de operación y entrenamiento, abrazamos el debate sobre qué es verdaderamente inteligencia, estudiamos el conjunto de hitos históricos que nos trajo hasta aquí, discutimos como la IA de nueva generación ha supuesto una verdadera conquista del lenguaje que ha revolucionado los modelos de interacción, discutimos los factores de impacto de esta era de transformación digital, presentamos el modelo de madurez de la Inteligencia Artificial discutiendo cada uno de sus horizontes, abordamos los niveles de operación de esta tecnología, y finalmente, presentamos el modelo de referencia de las arquitecturas de Inteligencia Artificial actuales.

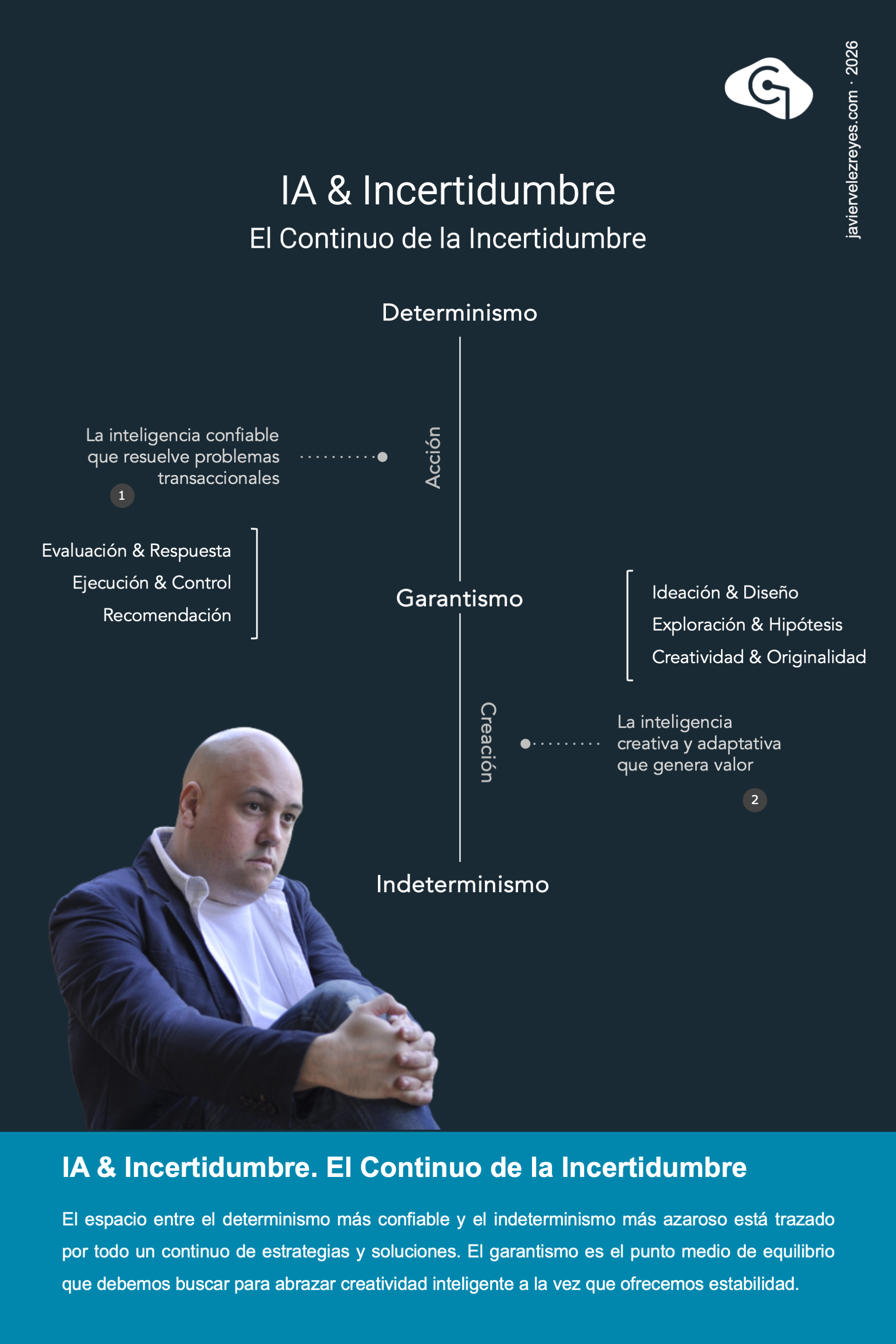

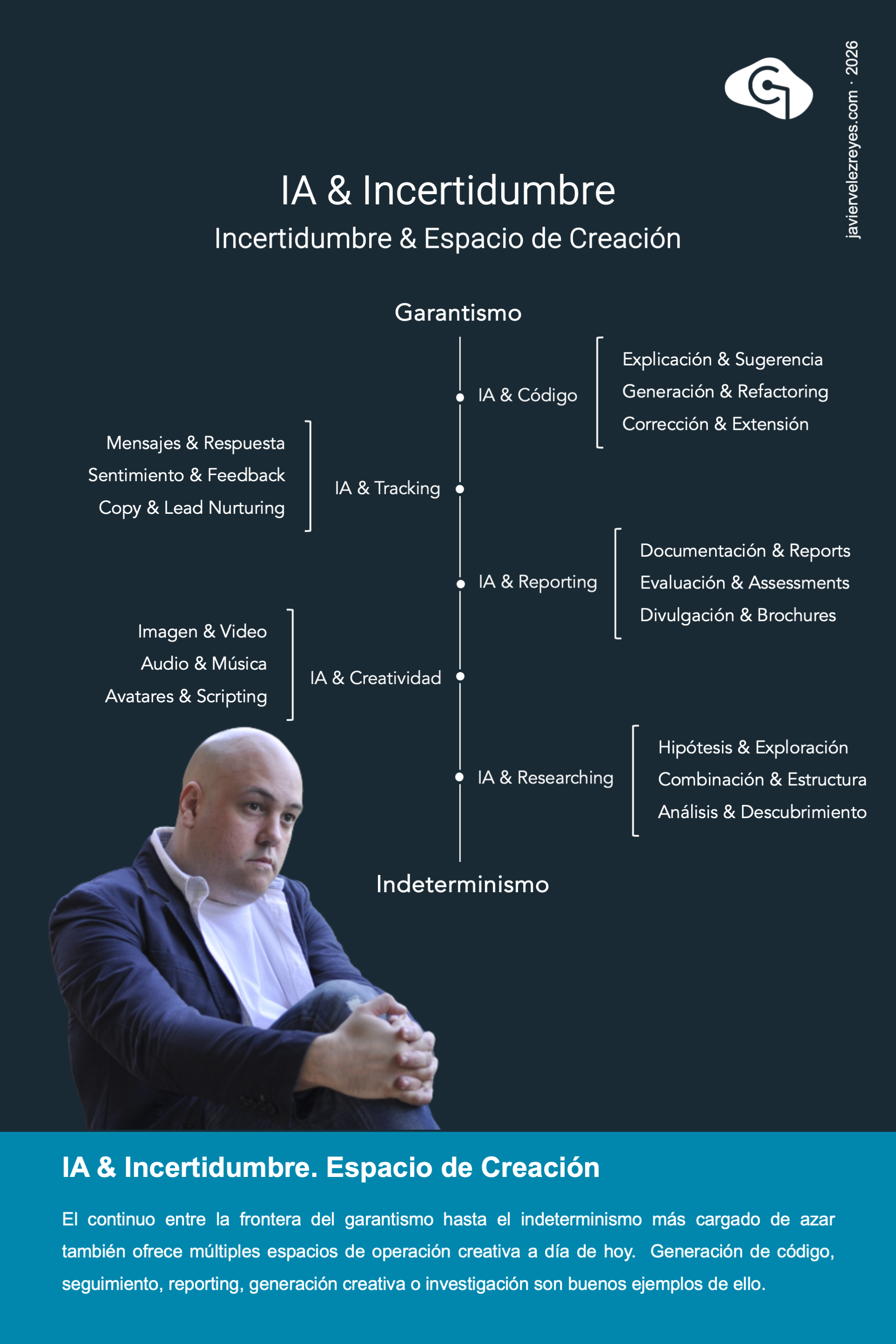

Con la llegada de los modelos de lenguaje, por fin la Inteligencia Artificial logró crear sistemas capaces de ofrecer respuestas inteligentes cargadas de creatividad y discrecionalidad operativa. Sin embargo, muchas voces criticas aún dedican su tiempo en revertir estos esfuerzos bajo el terrible malentendido de que solo el determinismo es el único garante de la confiabilidad digital. Si o que queremos son soluciones que respondan con aburrida garantía monótona ante la misma entrada en cada momento del tiempo para eso ya existe el diseño algorítmico. Muy al contrario debemos entender el espacio que ocupa la IA de nueva generación en el lado más creativo y adaptativo de las necesidades empresariales. En este poster defiendo que nuestra misión como arquitectos e ingenieros reside, precisamente, en encontrar el punto medio de equilibrio dentro de ese continuo para ofrecer un comportamiento inteligente que a la misma vez opere dentro de un marco de respuestas confiable. A ese punto le he dado en llamar el Garantismo de la Inteligencia Artificial.

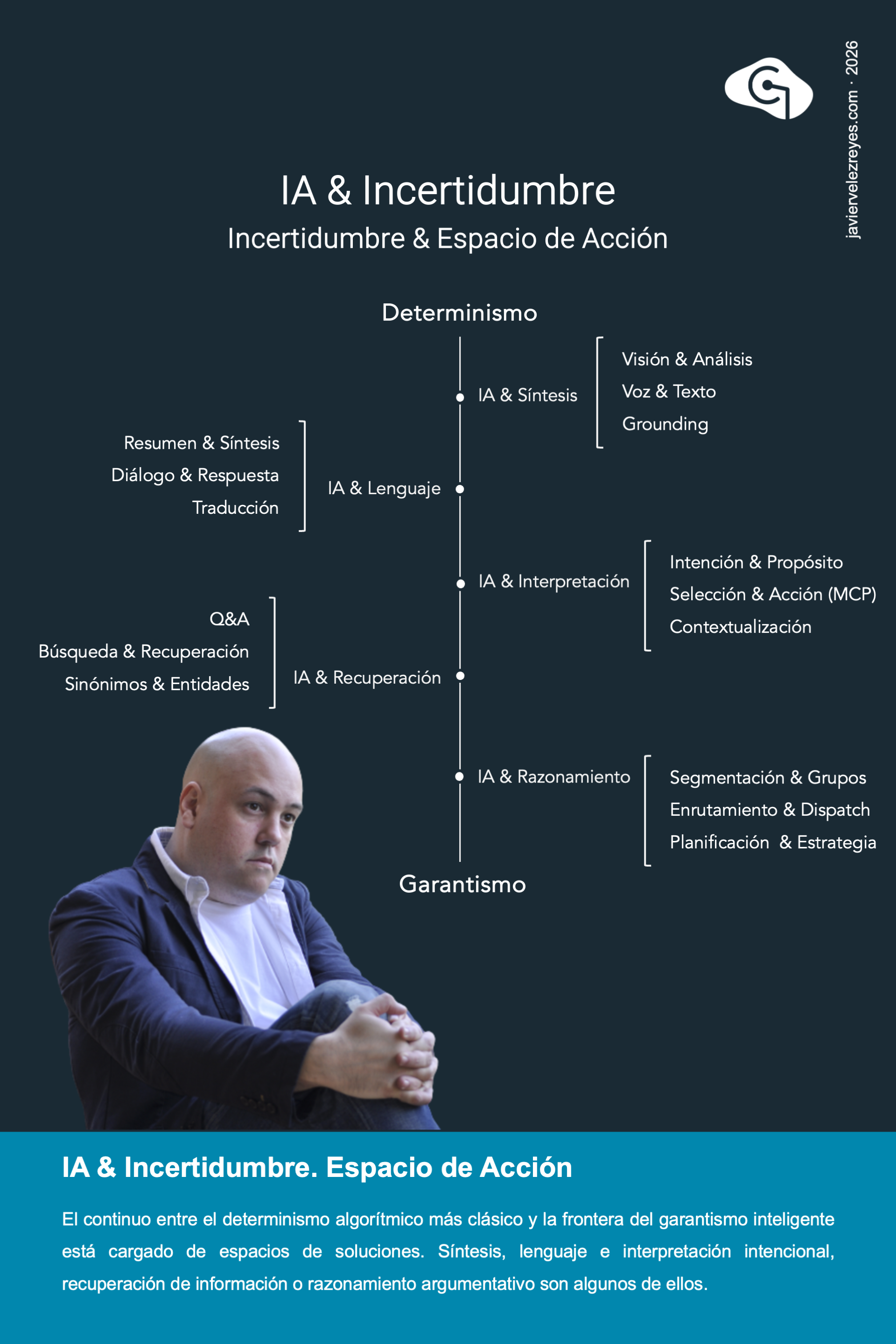

Existen actualmente no pocas voces que, desde un malentendido del panorama digital actual, se empeñan en revertir los esfuerzos ya alcanzados en la creación de sistemas inteligentes, creativos y discrecionales. Creen que solo desde los enfoques más puramente algorítmicos y convencionales se pueden ofrecer soluciones operativas a las necesidades empresariales y por ello intentan convertir a las potentes arquitecturas de Inteligencia Artificial Generativa en sistemas clásicos deterministas. En esta infografía recojo algunos de los espacios de solución más comúnmente aplicados a día de hoy que se alejar de ese determinismo aburrido y abrazan soluciones confiables sin atravesar la frontera del garantismo tal como fue definida en el poster anterior. Síntesis de contenidos, procesamiento de lenguaje, captura e interpretación intencional, recuperación de información y razonamiento argumentativo son solo algunos de los ejemplos más destacados.

Incluso atravesada la frontera difusa del garantismo aún existe todo un continuo de soluciones que ofrecen modelos de respuesta funcionales y operativos dentro del ámbito empresarial. Y es que con mayor frecuencia de lo que se cree, las organizaciones requieren de capacidades de inteligencia creativa, adaptativa y discrecional instalada dentro de los procesos de negocio. Me atrevería a decir que incluso más que las soluciones de digitalización determinista clásica. Soluciones de generación de código, de seguimiento y monitorización de la actividad de negocio, toma discrecional de decisiones, reporting y análisis de casos, creación de creatividades o investigación especializada de dominio apoyadas en las capacidades de razonamiento argumentativo son algunos de los ejemplos más prometedores por el momento.

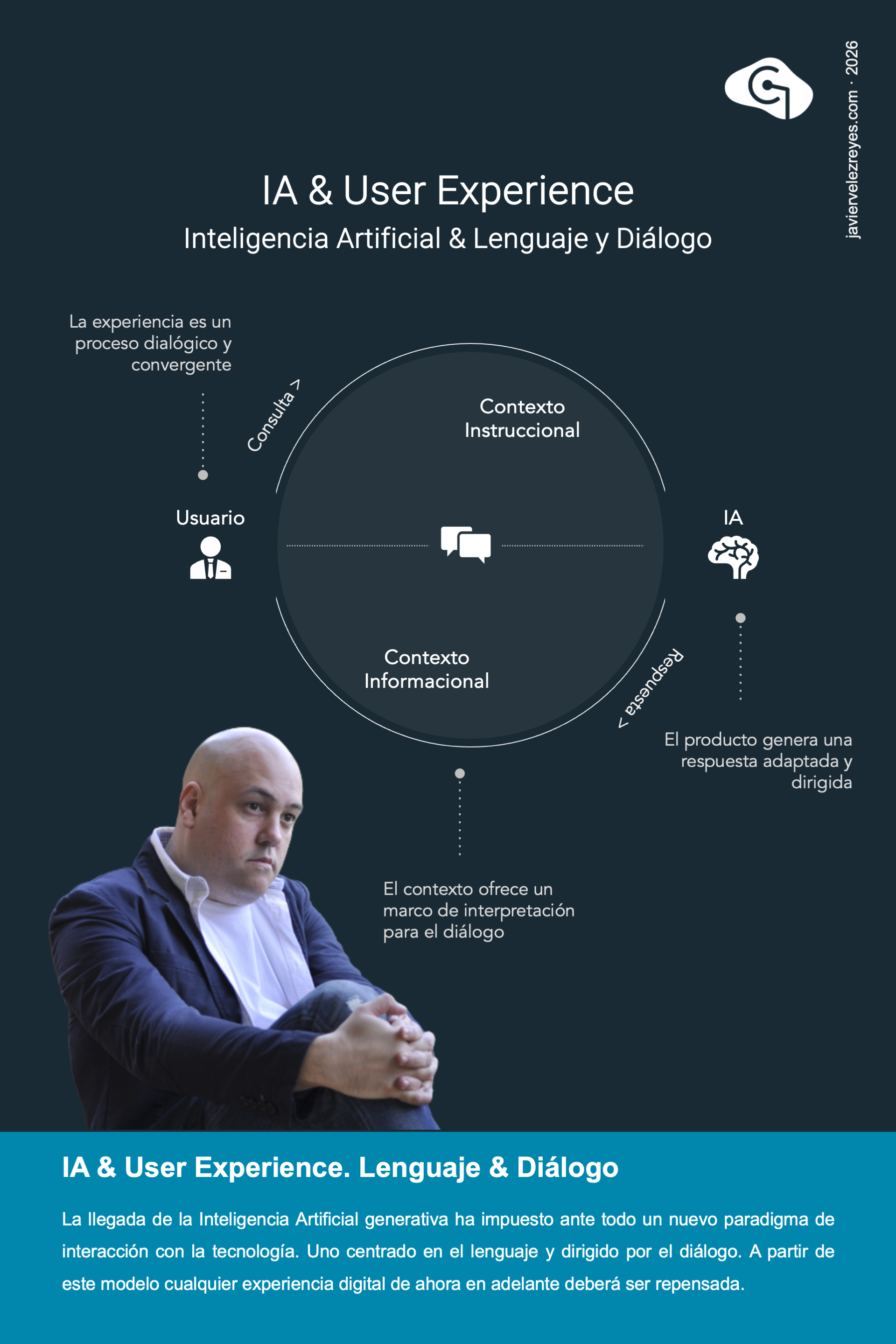

Hasta la fecha habíamos abrazado con agrado los modelos de interacción con la tecnología basados en procesos exploratorios, gestuales y transaccionales. Sin embargo, la llegada de la Inteligencia Artificial de última generación se presenta como un autentico revulsivo en este sentido. La IA está presentando muchos factores de impacto en nuestra actividad digital. Pero ante todo propone – e impone – un nuevo paradigma de interacción con la tecnología. Uno que, contrariamente a lo culturalmente establecido, está centrado en el uso del lenguaje natural y dirigido por el diálogo. La experiencia de uso dejará de percibirse como un conjunto de características discretas para entenderse como un continuo argumentativo. El comportamiento de los sistemas, transitará de respuestas formateadas a verdaderos resultados adaptados y contextualizados. Y la evolución de las productos pasará a ser una realidad transparente y dada por hecho a través de realidades de aprendizaje continuo.

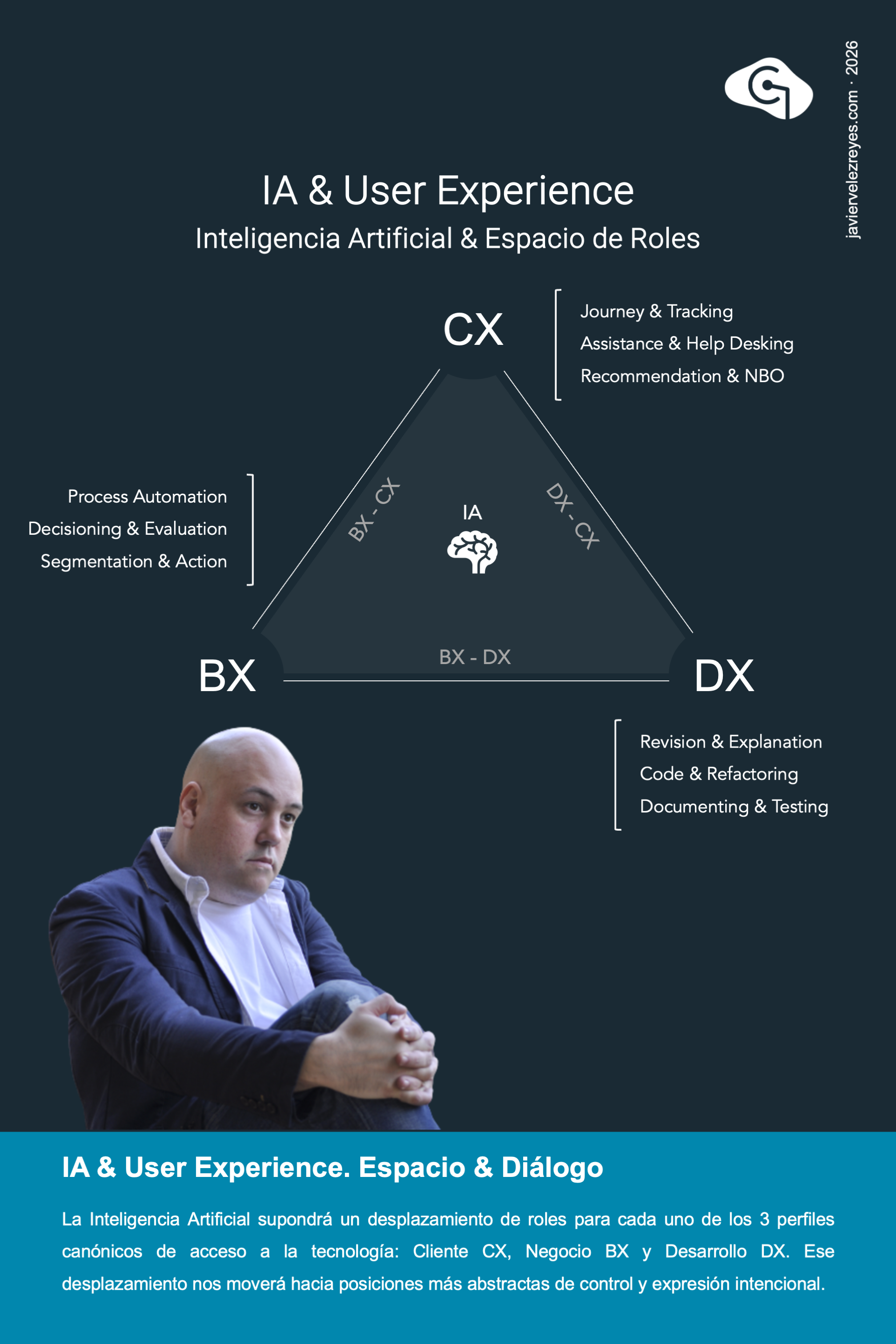

Desde la perspectiva experiencial, la llegada de la Inteligencia Artificial Generativa supone un desplazamiento en los 3 tipos de roles que vienen caracterizando la interacción con la tecnología: Cliente CX, Negocio BX, y Desarrollo DX. Este cambio se modula como una elevación en las responsabilidades obligándonos a abandonar todo perímetro de lo operativo para abrazar un nivel más abstracto de expresión volitiva intencional y de seguimiento evaluativo. Pero lo importante aquí es que ese impulso de escalado deberá hacerse de manera acompasada sobre los 3 perfiles de uso para no romper en frágil entramado de relaciones de conexión que éstos guardan entre sí. No podemos activar la transición evolutiva mirando a los clientes de nuestro negocio si no ponemos a la misma altura a los perfiles de negocio y tecnología.

Resulta curioso comprobar como la llegada de la Inteligencia Artificial de última generación no solo está promoviendo la creación de nuevos modelos de interacción con la tecnología sino que también está provocando el resurgimiento de algunos otros que ya se creían abandonados por la flecha del tiempo. Entre los nuevos modelos destacan aquellos basados en el diálogo y en la iteración modal que si bien parecen sencillos de resolver técnicamente supondrán un verdadero reto para el diseño de producto porque la esencia misma del software tiene que ser revisitada. Y de entre los enfoques más clásicos aparecen de repente rescatados modelos de interacción basados en el uso de comandos y en las metáforas sistémicas de flujo de trabajo y proceso empresarial. Solo el tiempo nos dirá qué mar en calma dejará todo este revulsivo.

El concepto de agente se ha tomado como unidad central de abstracción dentro del nuevo paradigma arquitectónico al que nos ha empujado la Inteligencia Artificial de última generación. Un agente es, ante todo, una entidad autónoma deliberativa capaz de tomar oportunistamente sus propias decisiones en alineamiento con sus directrices intencionales de diseño y sus objetivos e intereses. Es, en ese sentido, una entidad proactiva capaz de tomar la iniciativa para promover cambios en su entorno que le acerquen a la consecución de dichos objetivos. Pero a la vez, también es una unidad de escucha activa y continua que atiende reactivamente a los cambios ambientales que percibe de su entorno. Pero ante todo es una realidad desplegada en el plano social. Dentro de la arquitectura multiagéntica en la que participa muestra un comportamiento racional cooperativo para impulsar los intereses globales de la misma. Hacia fuera, por el contrario, su comportamiento muestra rasgos de competitividad basada en actividades de negociación. ¿Cuáles de estos 5 rasgos característicos ves más maduros en las arquitecturas de hoy?

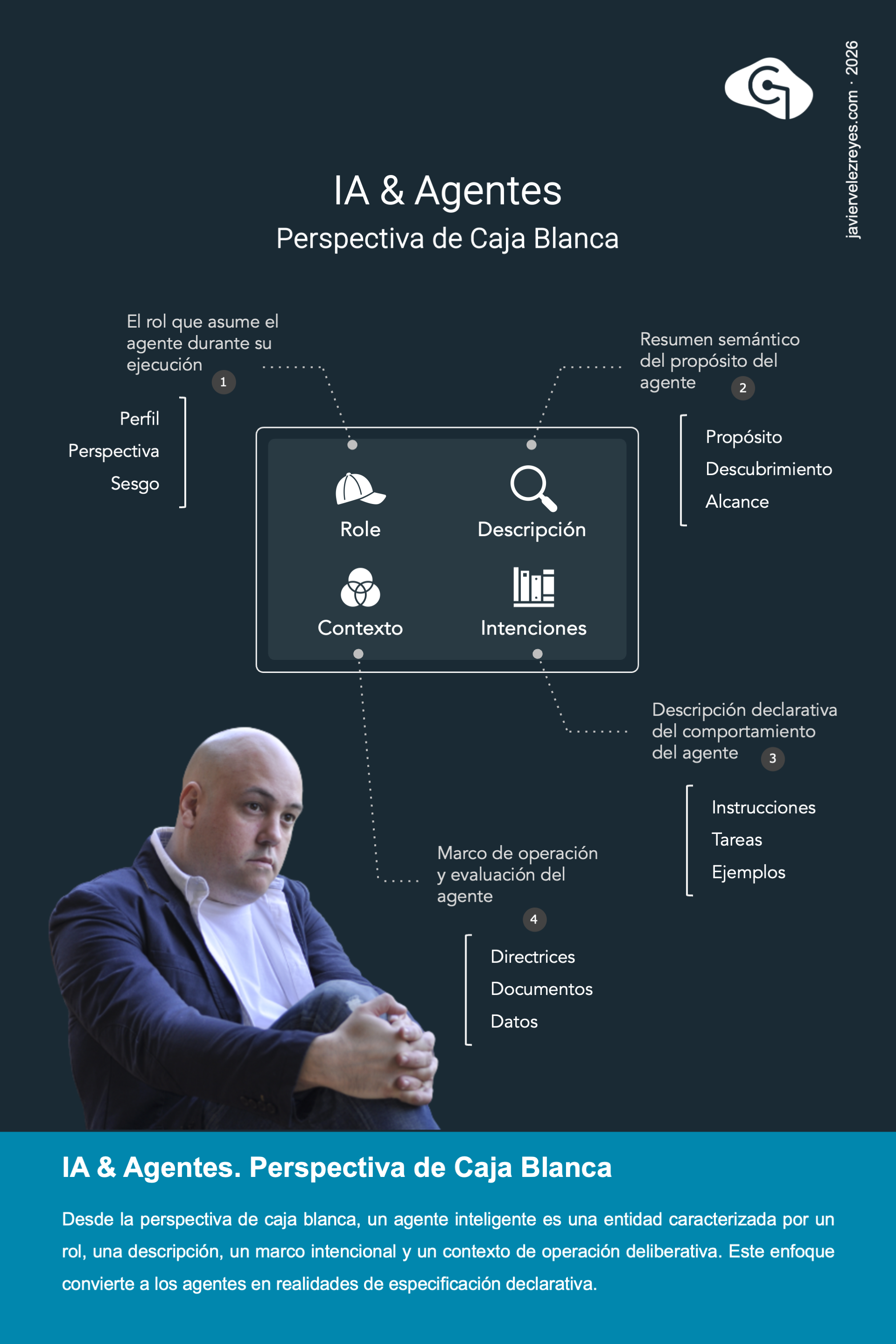

La verdadera revolución que la Inteligencia Artificial de última generación ha traído a nuestros días es la posibilidad de llevar a cabo el diseño de soluciones de agentes de forma absolutamente declarativa. Las especificaciones clásicas imperativas de corte algorítmico están cediendo espacio de acción a modelos intencionales dirigidos por objetivos que trazan perfiles de comportamiento a los que se adscribe la conducta de cada agente cuando la arquitectura entra en ejecución. Esto significa que, desde la perspectiva del diseñador intencional, un agente debe formularse exclusivamente utilizando lenguaje natural y atendiendo exclusivamente a 4 factores característicos. En primer lugar el rol que juega dicho agente en el marco de la arquitectura y su responsabilidad dentro del espacio del problema. En segundo lugar, una descripción que permita cualificar al agente según sus capacidades cognitivas y operativas. En tercer lugar, un marco de especificación intencional que regule el comportamiento general del agente. Y finalmente, el contexto informacional que arroja una adecuada interpretación semántica de dicha especificación. Si sigues creando agentes a través de código, algo estás haciendo mal.

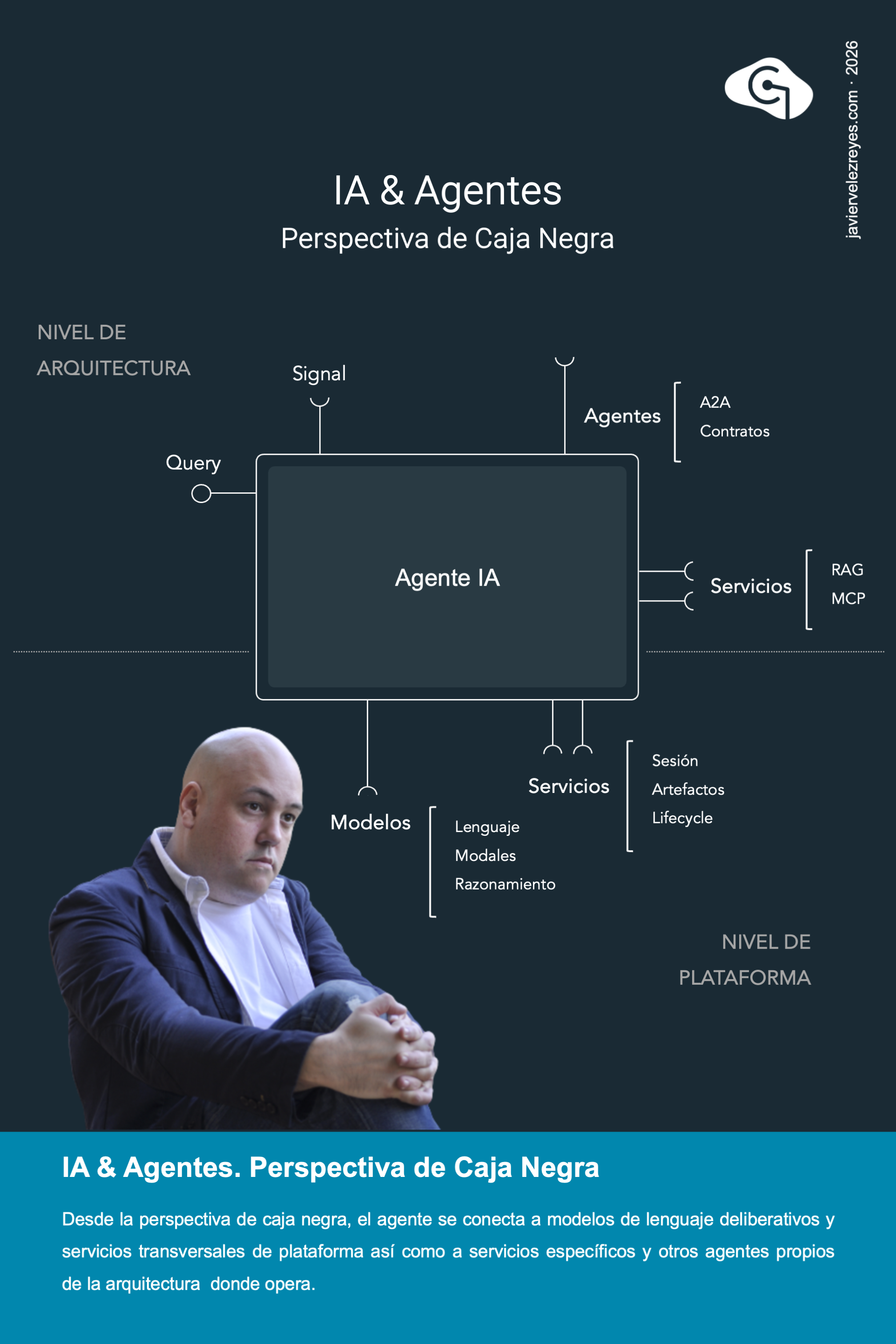

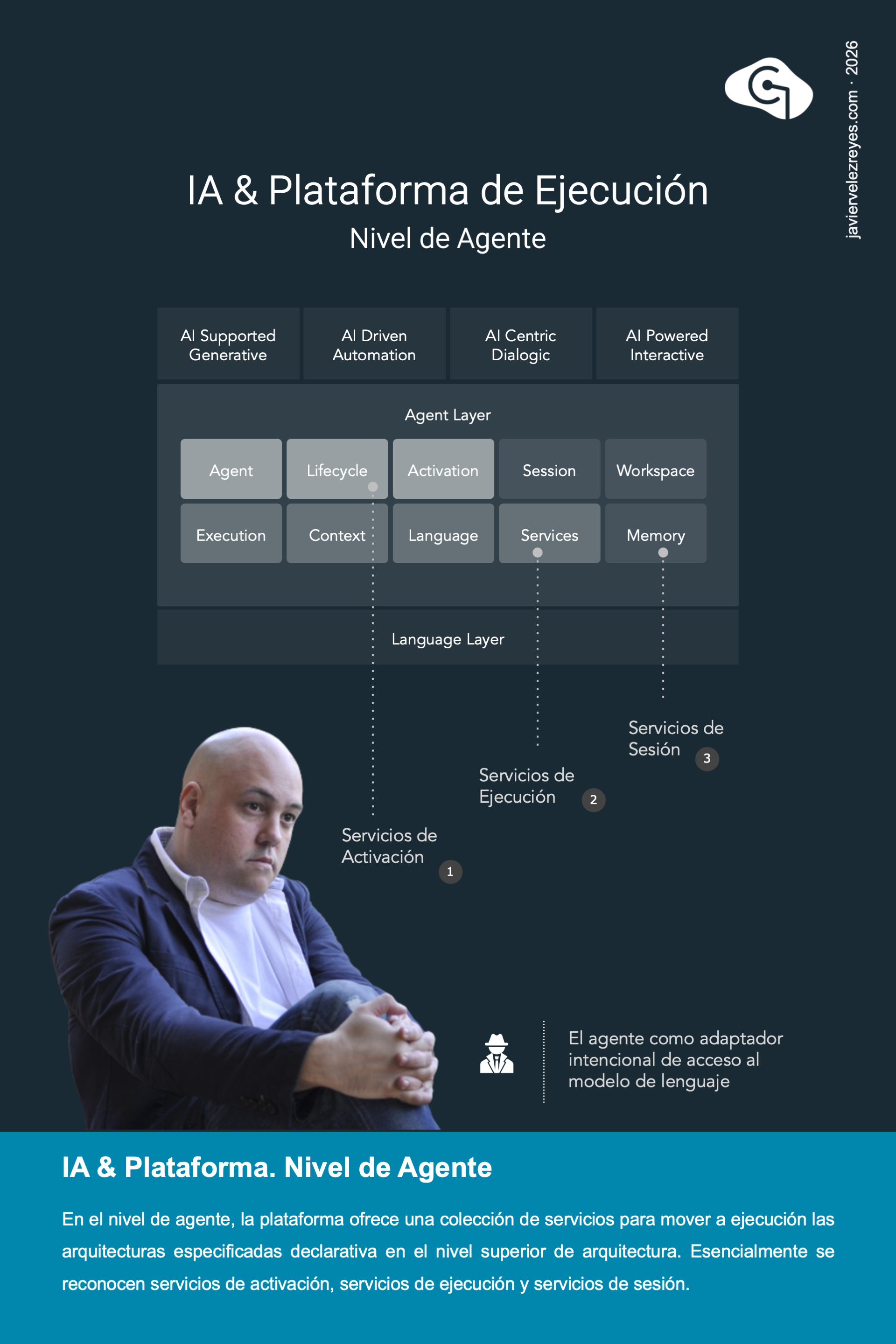

Concebido desde una perspectiva de caja negra, el agente es una entidad encapsulada de comportamiento inteligente. Sin embargo, para mover a ejecución estas unidades es necesario conectarlas a diferentes capacidades sistémicas que pueden clasificarse en dos niveles según su procedencia. En el nivel de plataforma cada agente se conecta a los modelos de lenguaje requeridos para dotarse de una operación racional, deliberativa y modal así como a servicios de corte transversal para la gestión de la sesión conversacional de trabajo, el acceso a artefactos disponibles o el control del ciclo de ejecución. En el nivel de arquitectura, cada agente se conecta al resto de agentes de la arquitectura y consume servicios de los perímetros operacionales e informacionales del contexto de ejecución.

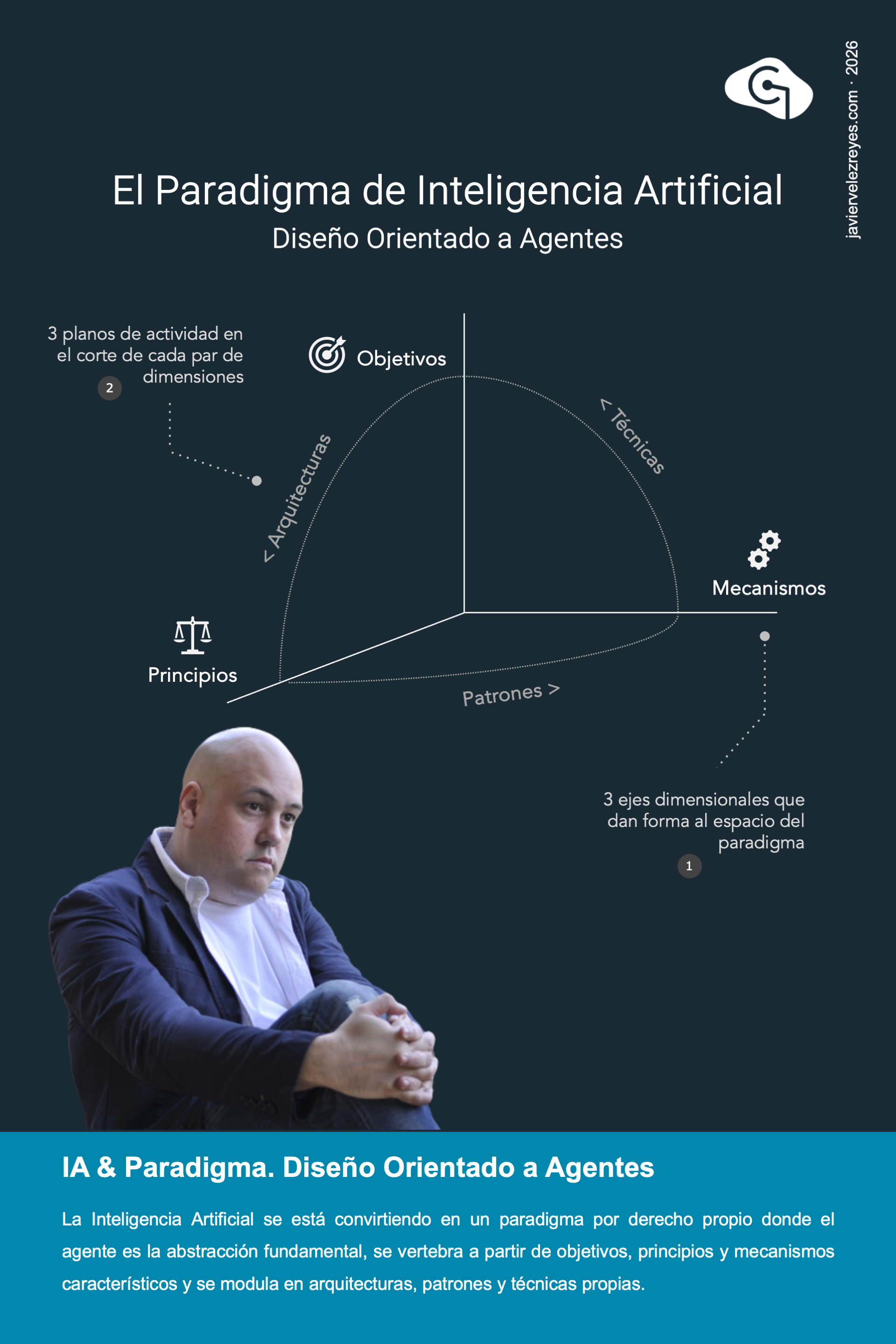

La Inteligencia Artificial está progresivamente dejando de ser una mera transformación digital similar a la propia de décadas anteriores. Esto ya no va de productos de mercado, ni de herramientas, ni tan siquiera de inyección tecnológica o de transición arquitectónica. Se trata, muy al contrario, de un nuevo paradigma que transformará nuestra cultura, nuestra sociedad, nuestra profesión e incluso nuestra economía y nuestra forma de relacionarnos laboral y profesionalmente trazando nuevos espacios de responsabilidad. Cuando hablo de un nuevo paradigma me gusta utilizar este marco organizativo basado en 3 ejes dimensionales que trazan un espacio de solución característico. La IA persigue una nueva familia de objetivos, se rige por una serie propioa de principios fundacionales de diseño y se soporta en base a un conjunto asociado de mecanismos tecnológicos. Pero además esto abre espacio para 3 planos de actividad. El pliegue entre el eje de objetivos y principios modula arquitecturas características. El corte entre principios y mecanismo predica sobre los patrones de diseño esenciales como soluciones probadas a problemas recurrentes. Y el recorrido desde los mecanismos a los objetivos nos habla de las técnicas de desarrollo. A lo largo de las próximas semanas me gustaría recorrer con vosotros estos perímetros.

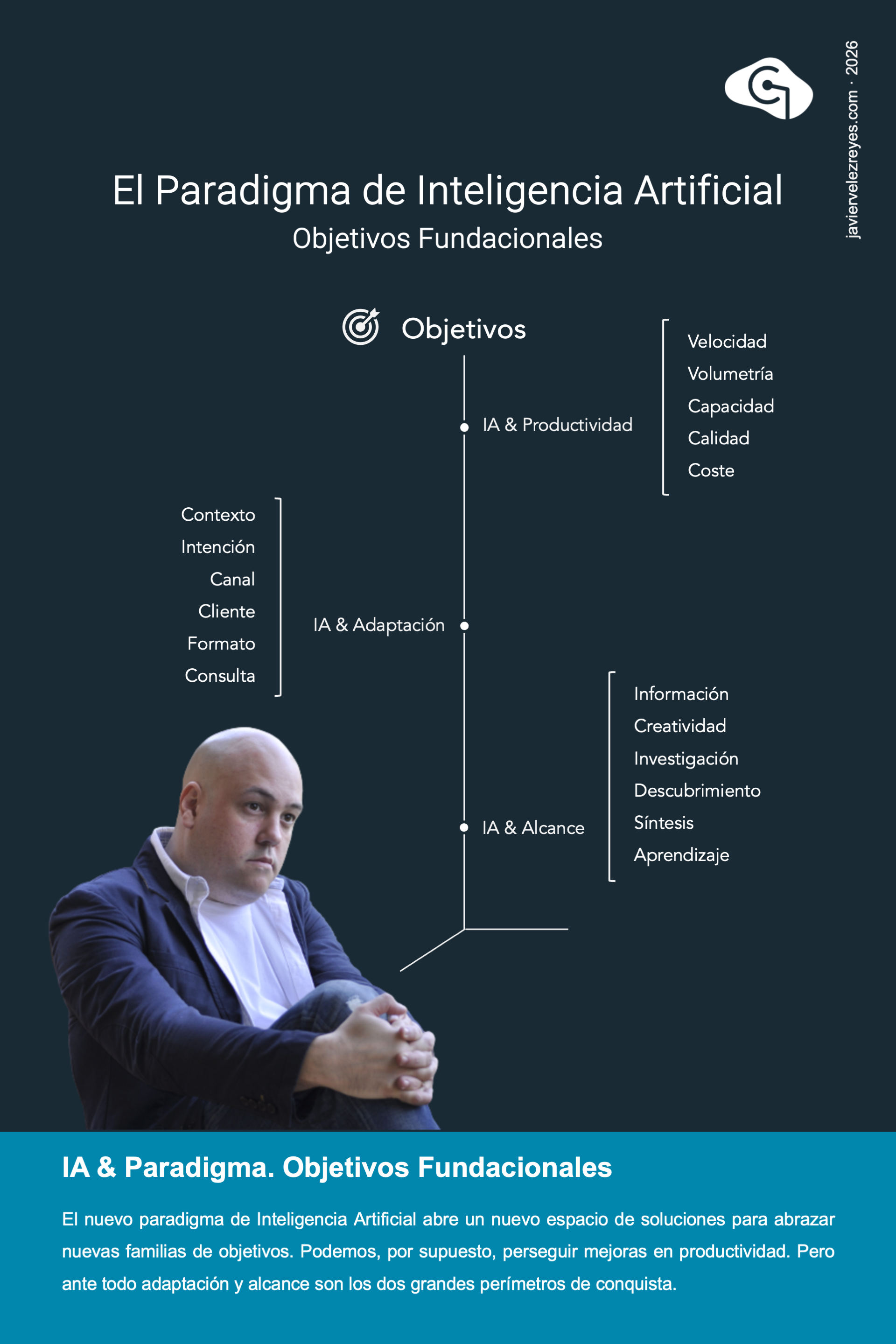

La Inteligencia Artificial de última generación se está presentando como una revolución tecnológica que permite mejorar la digitalización de nuestros procesos empresariales. Especialmente se la vincula con mejoras en la productividad bajo el malentendido de que la IA debe percibirse, esencialmente, como un agente catalizador. Sin embargo, este cambio digital supone un paradigma por derecho propio que encuentra sus palancas de acción en otros 2 grandes perímetros incluso más relevantes. El primer lugar, la IA, convenientemente aplicada en tiempo de ejecución permitirá crear productos digitales cada vez más adaptativos y contextuales y eso es un gran eje de cambio en relación a cómo se deberán concebir las soluciones de cara al futuro. Pero además, la Inteligencia Artificial es también un gran igualador democrático que permitirá reducir fricciones de entrada en muchos dominios de alta especialización aumentando el alcance a los mismos.

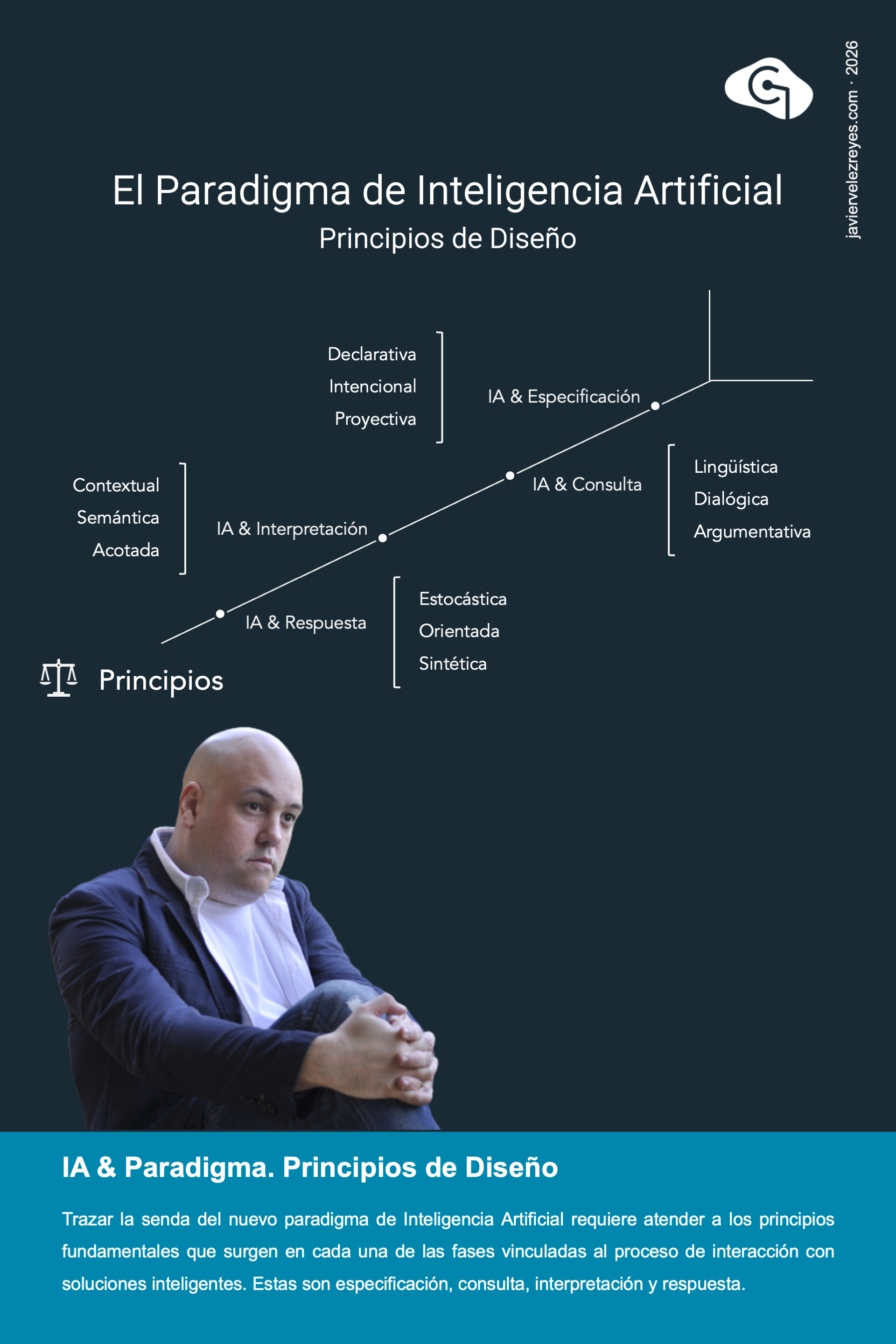

Antes de ponernos a realizar cualquier esfuerzo de modelado arquitectónico centrado en Inteligencia Artificial, deberíamos reflexionar acerca de cual es el conjunto de principios fundacionales que acotan nuestro espacio de actuación. Parece razonable enunciar tales principios a partir de cada una de las 4 fases que surgen dentro del proceso interactivo con este tipo de soluciones. Durante el diseño, toda especificación debería ser entendida siempre como una actividad declarativa, intencional y proyectiva. En la fase de consulta, debería entenderse que está esta centrada en el lenguaje, dirigida por el diálogo y basada en la convergencia argumentativa. Durante la interpretación, debería advertirse siempre que esta actividad estará siempre sometida a un contexto semántico acotado. Y durante la fase última debería procesarse la respuesta como un activo estocástico, adaptativa e intencionalmente orientado y de carácter nuclearmente sintético.

Como todo paradigma, la Inteligencia Artificial de última generación se articula a partir de una colección de capacidades características que se trazan como mecanismos de soporte. Estos mecanismos se encuentran inherentemente expuestos dentro de los Modelos de Lenguaje subyacentes. Estamos hablando por supuesto, en primer lugar, de la habilidad de ofrecer respuestas contextualmente adaptativas y de generación sintética. Pero también de capacidades de procesamiento multimodal de solicitudes, captura e interpretación semántica intencional, razonamiento deliberativo dirigido de carácter argumentativo y ejecución y control autónomo de acciones operativas. Articuladas todas estas capacidades desde una adecuada modulación arquitectónica basada en la metáfora sistémica de agente inteligente llegamos a la realidad de la Inteligencia Artificial a la que hoy estamos asistiendo.

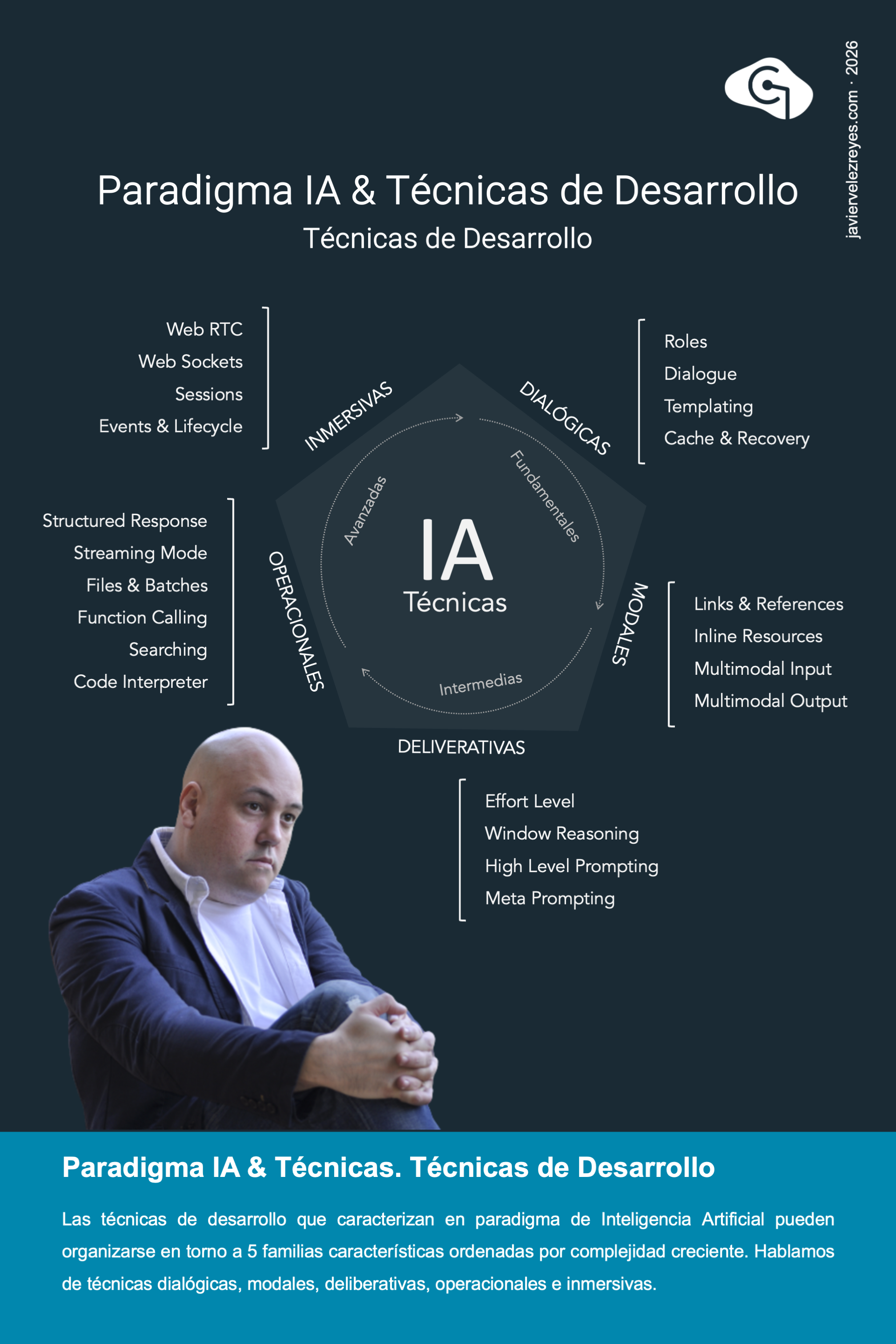

Idear un marco organizativo que recoja todas las técnicas de desarrollo de un paradigma siempre es algo complejo por su carácter discrecional y desordenado. Sin embargo, en este caso nos hemos servido de las fases de desarrollo tecnológico que presentamos para la Inteligencia Artificial cuando discutimos su modelo de madurez. Ello nos permite clasificar las mismas en 5 familias características que se ordenan en 3 niveles de complejidad. Hablamos, en primer lugar, de técnicas dialógicas utilizadas para modular el discurso interactivo con la Inteligencia. De técnicas modales cuando el procesamiento de las solicitudes y sus respuestas requieres un tratamiento multimodal que implica varios formatos. De técnicas deliberativas cuando se requiere una actividad de respuesta elaborada basada en el trazado estratégico o el razonamiento argumentativo. De técnicas operacionales, si lo que se aborda es el diseño de arquitecturas agénticas de intervención transaccional o informacional. O de técnicas inmersivas cuando se pretende enfrentar el diseño de entornos multiagénticos distribuidos con entidades de tercera parte.

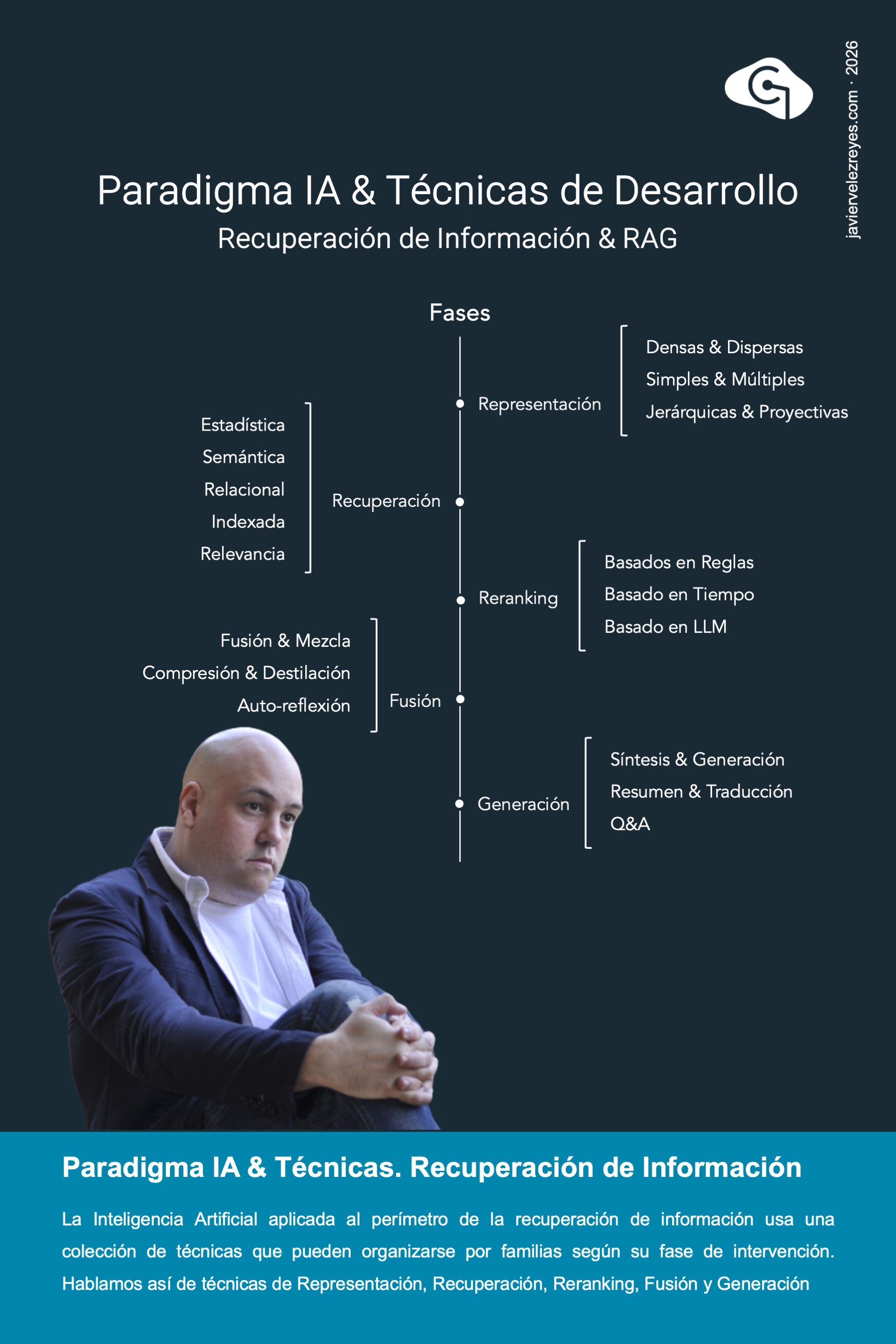

De entre todas las técnicas de desarrollo que aparecen vinculadas al desarrollo de la Inteligencia Artificial, quizá las más popularmente aceptadas son aquellas vinculadas al perímetro de la recuperación de información. Si bien, la mayoría de las publicaciones y propuestas encontradas hasta la fecha ofrecen para este problema modelos de solución bastante ingenuos, lo cierto es que el conjunto de técnicas que pueden aplicarse de manera compositiva para crear aproximaciones sólidas es muy amplio. Organizadas por familias según la fase de aplicación a la que pertenece podemos hablar de técnicas de representación desde dispersas y simples hasta jerárquicas o proyectivas. De técnicas de recuperación, desde estadísticas y semánticas hasta relacionales o indexadas. De técnicas de reranking, ya sean basadas en reglas y tiempo o capacidades deliberativas. De técnicas de fusión, basadas en mezcla, compresión o reflexión. Y de técnicas de generación, ya estén orientadas a la síntesis genitivas, al resumen y la traducción o a la consulta y la respuesta.

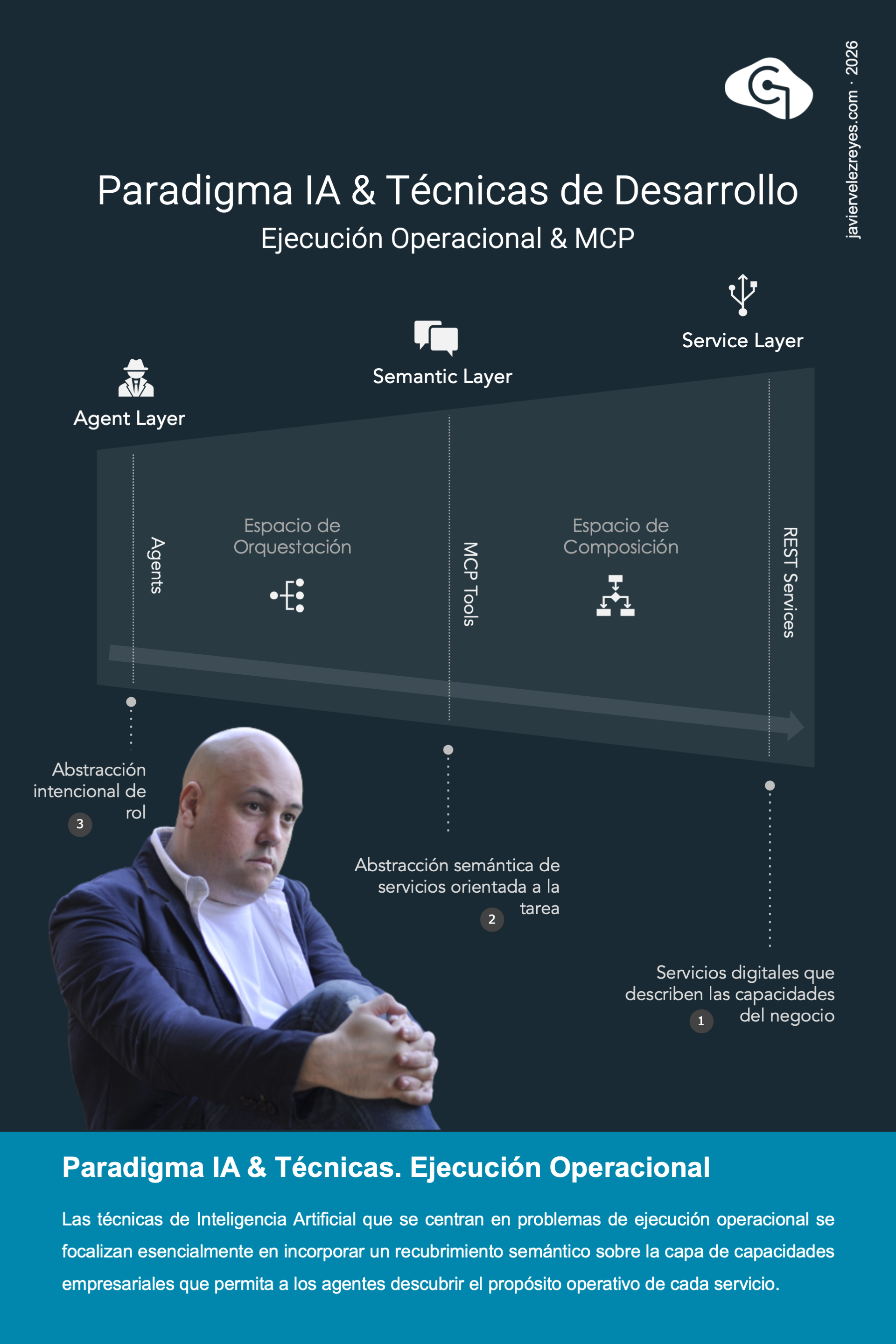

Cuando la Inteligencia Artificial abraza el perímetro operacional, surge el problema de encontrar un mecanismo en vinculación semántico que permita a cada agente de la arquitectura acceder al conjunto de servicios empresariales disponibles. Ese es precisamente el objetivo del protocolo MCP que presentamos como otras de las técnicas más habituales y popularmente extendidas dentro de este paradigma. La aplicación de esta técnica de desarrollo se presenta así como un esfuerzo de especificación semántica sobre la capa de servicios organizacionales que apunta a un tripe objetivo. De un lado, hacer una formulación intencional expresada en lenguaje natural que describa el propósito operativo de cada servicio dentro del entorno. De otro, presentar dicha formulación como una elevación semántica por medio de actividades compositiva sobre la colección servicios de negocio disponibles. Y finalmente, orientar la formulación a la resolución determinados problemas específicos de negocio.

Los patrones de diseño que se identifican dentro del paradigma de Inteligencia Artificial consisten en diferentes familias de protocolos de interacción entre agentes que se expresan a distintos niveles de abstracción y competencia. Para organizar estas familias conviene rescatar la anatomía de un Agente Inteligente como una realidad estratificada de niveles de responsabilidad. Ello permite distinguir entre 3 capas de operación donde se distribuyen las familias de protocolos. Sobre la capa de interacción, hablamos de protocolos que persiguen describir esquemas de comunicación atómica fundamental entre agentes. Sobre la capa de planificación, hablamos de protocolos de negociación cuando discutimos esquemas de interacción que persiguen alcanzar un consenso compartido para proceder y de protocolos de coordinación cuando pretendemos formalizar modelos de interacción orientados a la organización operativa de los agentes. Y finalmente, sobre la capa de ejecución, hablamos de protocolos de cooperación y colaboración para expresar diferentes esquemas de resolución de problemas respectivamente basados en reparto de responsabilidad o en desarrollo conjunto y compartido de tareas.

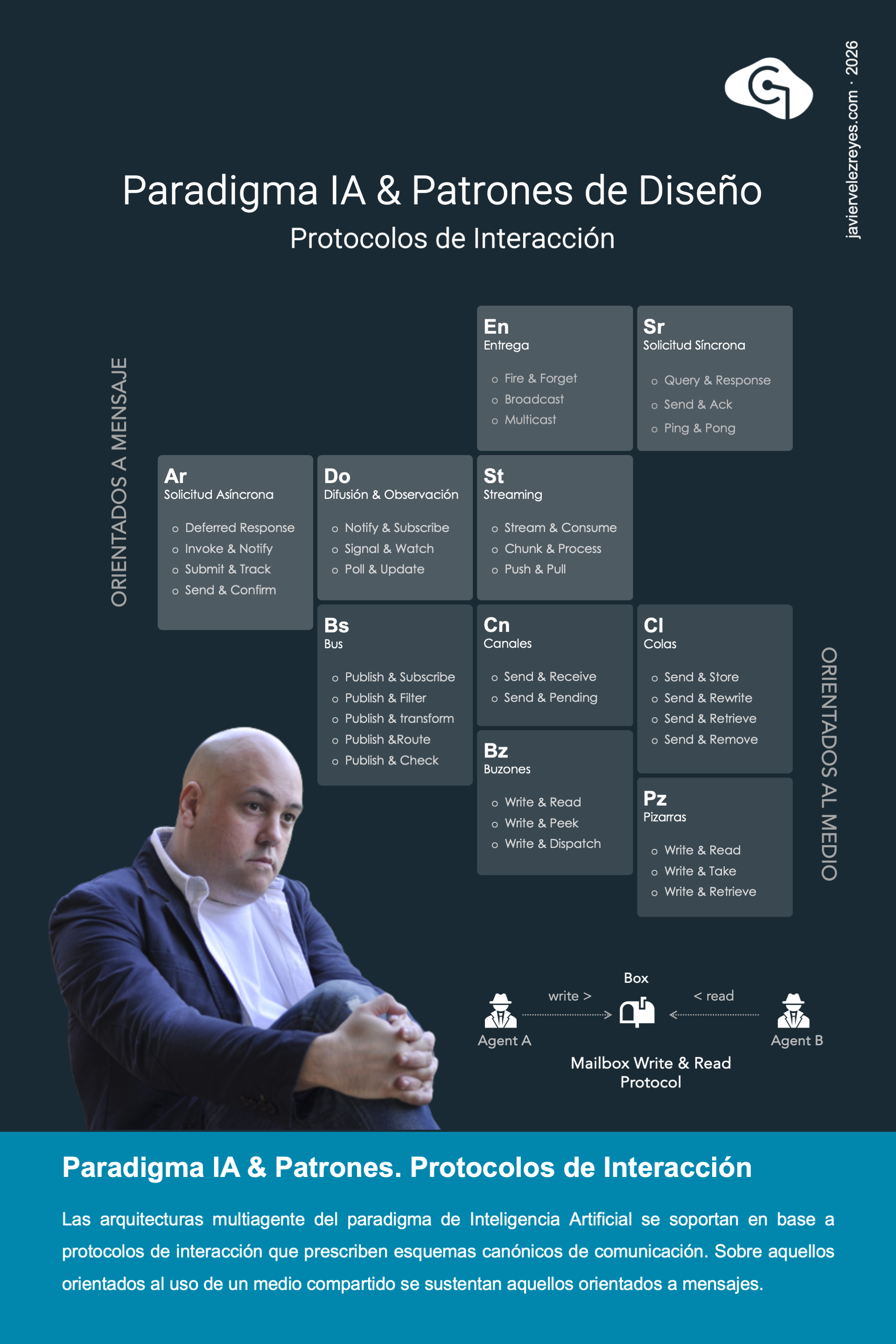

Las arquitecturas multiagente propias del paradigma de Inteligencia Artificial se articulan a partir de protocolos de interacción que tienen lugar en tiempo de ejecución. En el más bajo nivel estos protocolos definen esquemas de uso de memoria compartida como forma de establecer modelos de comunicación orientados al medio. Destacan en este perímetro los protocolos basados en la metáfora sistema de canales, buzones, colas, pizarras o buses. Pero lo más interesante es que, por encima de este sustrato, destacan otros protocolos que, con independencia del medio de comunicación utilizado, establecen modelos de comunicación más abstractos. Son los protocolos orientados a mensaje. Aquí hablamos de esquemas de interacción atómica que resultan de interés para edificar niveles superiores de cooperación interagéntica. Hablamos de protocolos de entrega y solicitud, interacción síncrona o asíncrona, continua o discreta y basada en la difusión y observación.

Al enfrentar el diseño de arquitecturas multiagente, y especialmente, en escenarios que implican la partición de entidades de tercera parte, suelen aparecer situaciones de conflicto que deben resolverse en ejecución de forma globalmente satisfactoria. Se trata, en esencia, de llevar a cabo procesos de interacción basados en propuestas y concesión que tienen por objeto alcanzar un consenso compartido. Este perímetro es el que da lugar a los protocolos de negociación que podemos clasificar en varias familias según su estructura y propósito. Hablamos de protocolos basados en regateo, en sondeos y votaciones, en el uso de subastas, en la resolución mediante sorteos y esquemas de azar, en el uso de contratos y procesos de licitación, en esquemas de intermediación y arbitraje, en delegación, en consenso parcial o en preferencias y relaciones de ordinalidad.

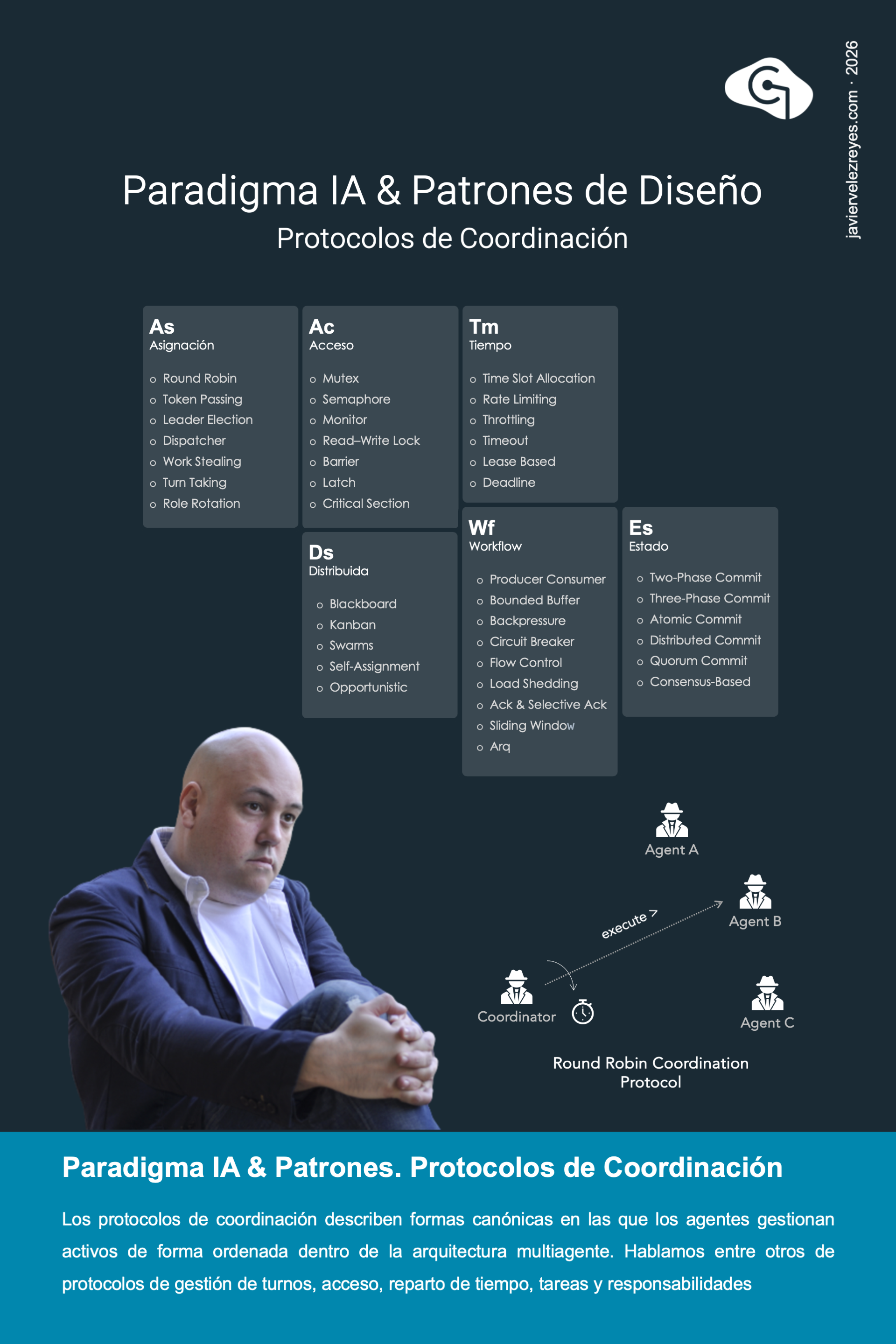

Para poner orden dentro de la amalgama de interacciones productivas que se da dentro de las arquitecturas multiagente en ejecución es necesario prescribir una colección de esquemas canónicos de operación que regulen la forma en la que los agentes gestionan los activos del sistema. Es así como surgen los protocolos de coordinación. Cuando el activo es la participación de los propios agentes en cierto problema hablamos de protocolos de asignación. Al tratar de gestionar el tiempo de acceso a recursos surgen los protocolos de tiempo y acceso. Si la coordinación se articula en base acondiciones de estado hablamos de protocolos de control de estado. Si por el contrario tiene un sustrato estructural podemos identificar los protocolos basados en flujo de trabajo. Y si la coordinación se encuentra resuelta a través de esquemas de interacción compartidos entre todos los agentes implicados hablamos de protocolos de coordinación distribuida.

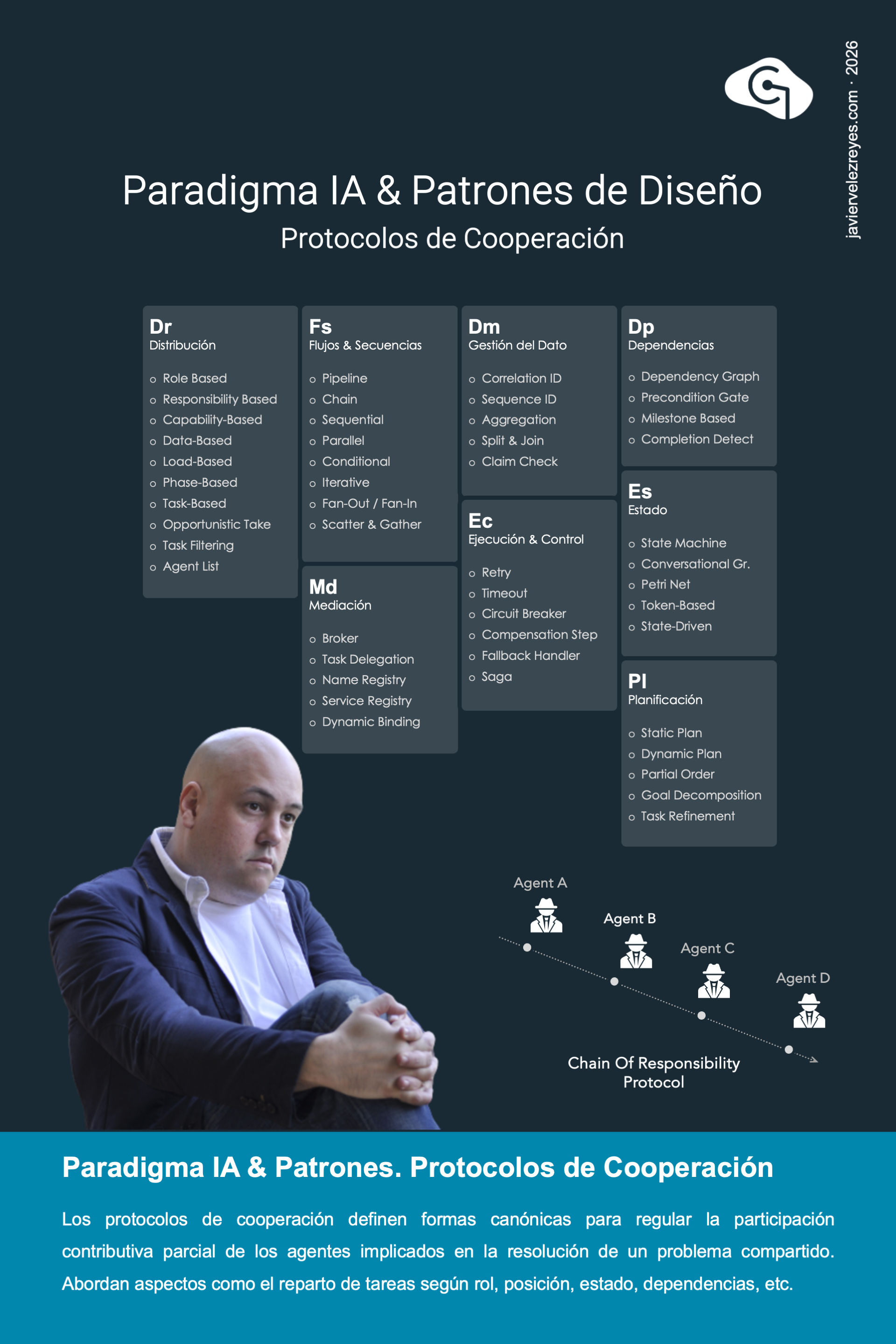

En los niveles más altos de ejecución de las arquitecturas multiagente destacan los protocolos de cooperación. Este tipo de patrones definen formas canónicas probadas para regular la participación contributiva parcial de los agentes implicados en un problema compartido. Según los criterios en los que se basa está regulación pueden reconocerse diferentes familias. Para determinar que tarea se asigna a cada agente implicado surgen los protocolos de distribución y de gestión de datos. Cuando el trabajo es fuertemente estructurado hablamos de protocolos basados en flujo de trabajo y secuencias. Si el criterio depende de las dependencias entre agentes o incluso su estado interno surgen los protocolos basados en dependencias, mediación o control de estado. Y si por el contrario, la asignación depende de factores externos hablamos de protocolos de planificación o control de la ejecución.

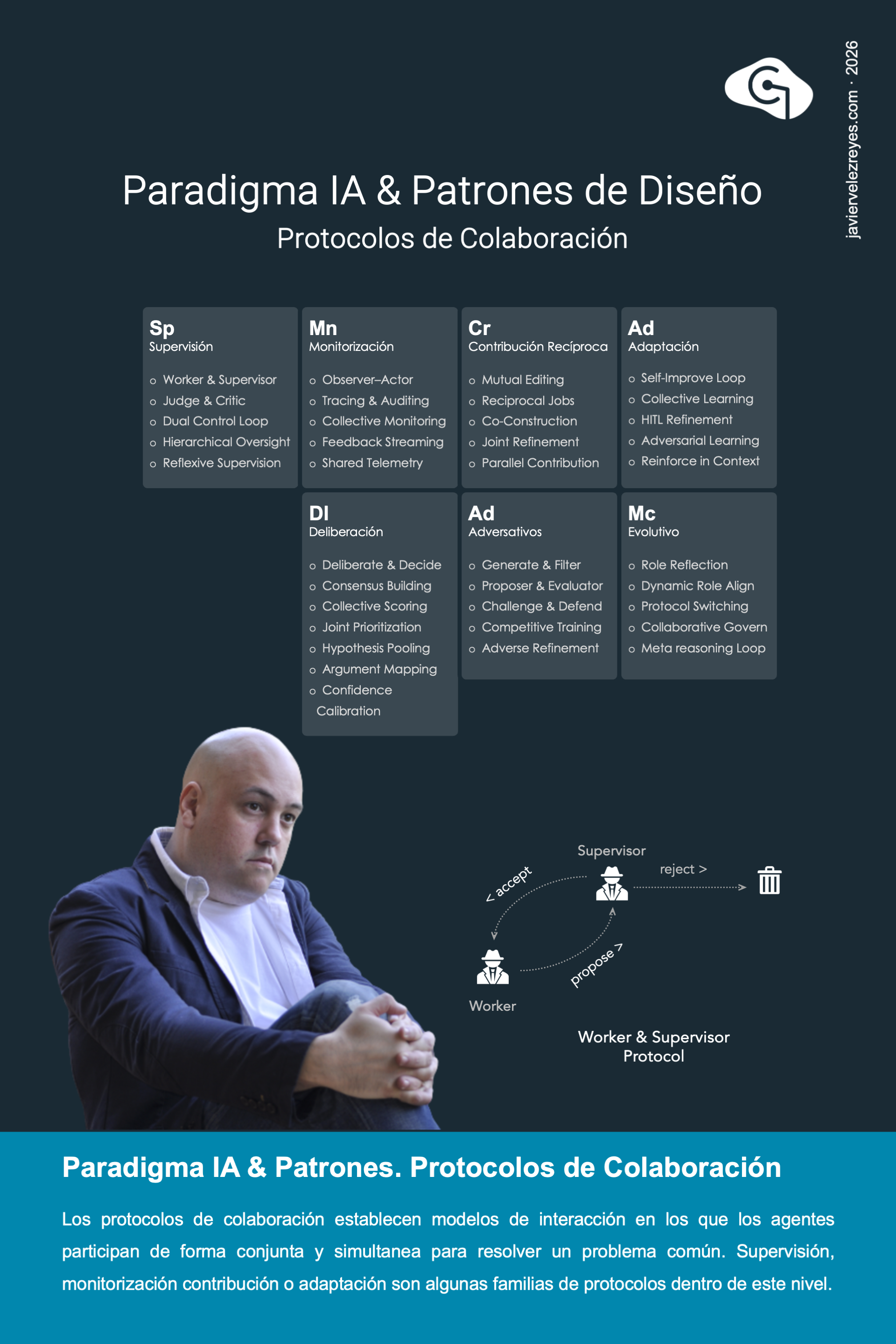

Los protocolos de colaboración son modelos de interacción que permiten a los agentes resolver de forma conjunta, simultanea y continua a lo largo del tiempo el problema compartido en el que están implicados. Este tipo de esquema debe distinguirse de los escenarios propios de cooperación, donde se definían esquemas de participación contributiva parcial entre los agentes implicados pero sin una participación simultanea sino oportunista y discrecional. En concreto, es posible definir diferentes familias de protocolos dentro de este nivel. Hablamos de protocolos de supervisión cuando unos agentes supervisan el trabajo realizado por los demás. De protocolos de monitorización cuando tal supervisión se produce de manera indirecta a través de estrategias de seguimiento. De contribución reciproca cuando se realizan actividades conjuntas en esquemas de colaboración horizontal. De adaptación cuando el producto en cocreación converge hacia objetivos adaptativos. De carácter deliberativo cuando unos agentes ejecutan el trazado estratégico que realizan otros agentes. De estructura adversativa cuando los agentes implicados tienen roles antagónicos en la participación. Y de carácter evolutivo si se establecen esquemas que modulan dinámicamente el propio proceso de participación.

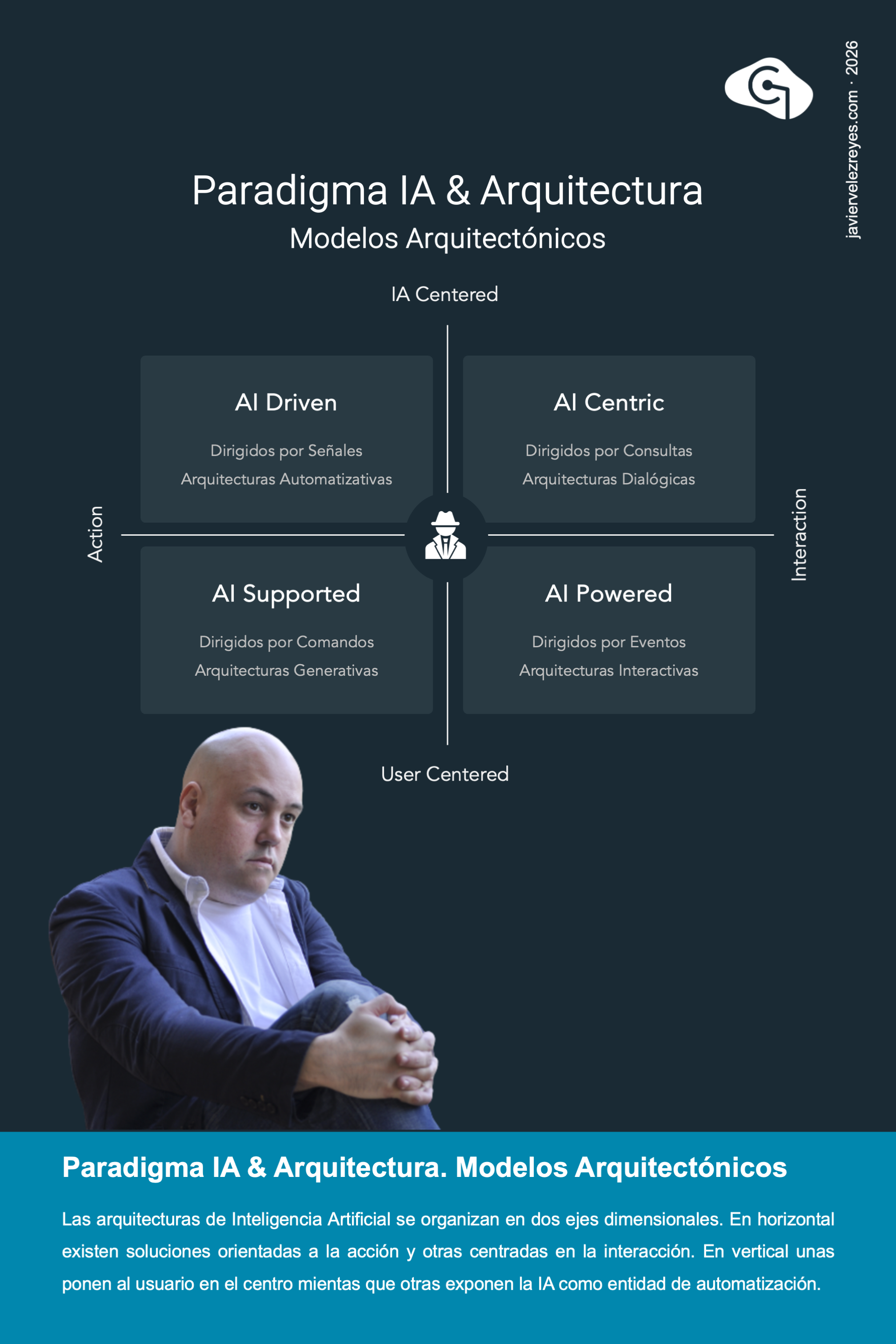

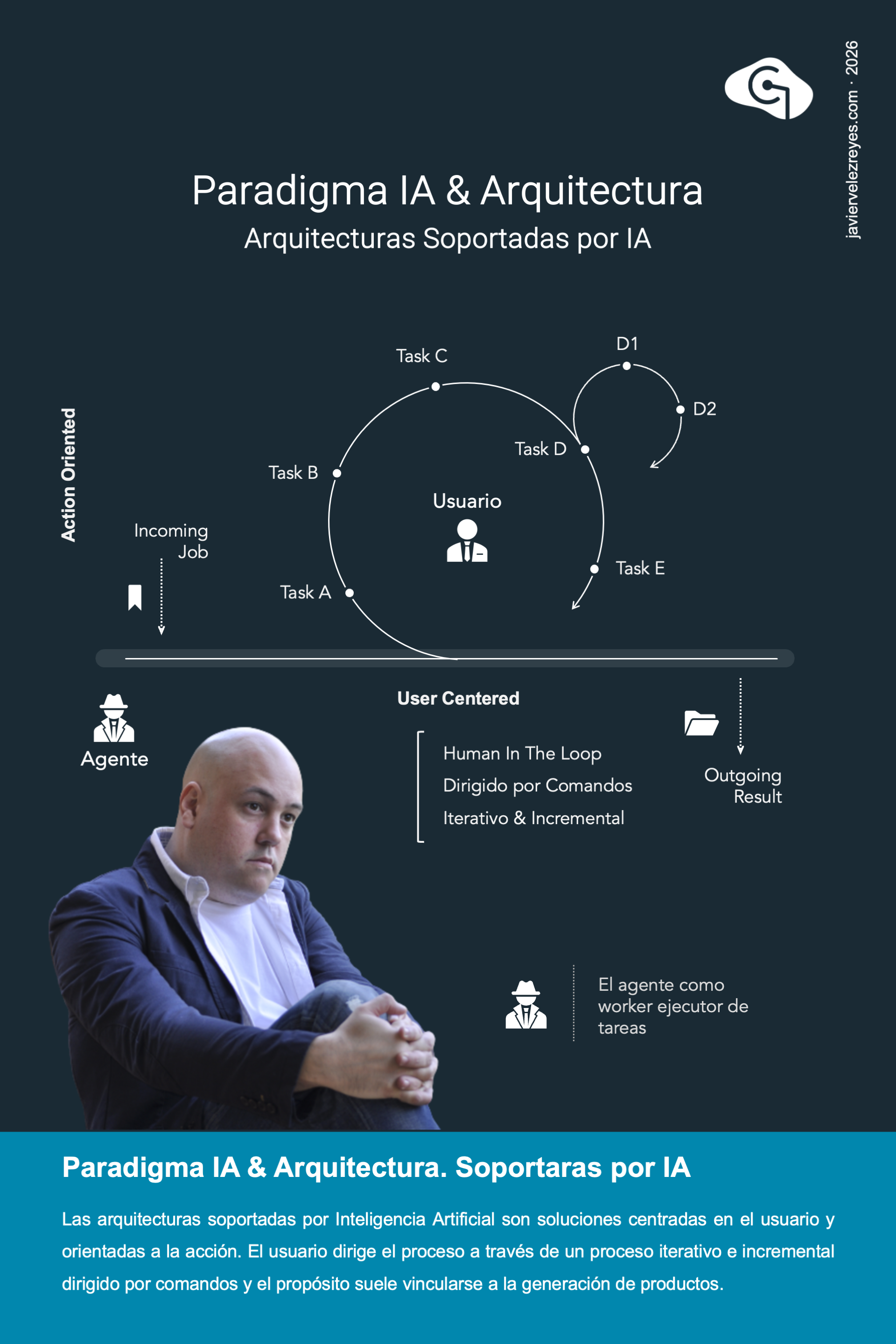

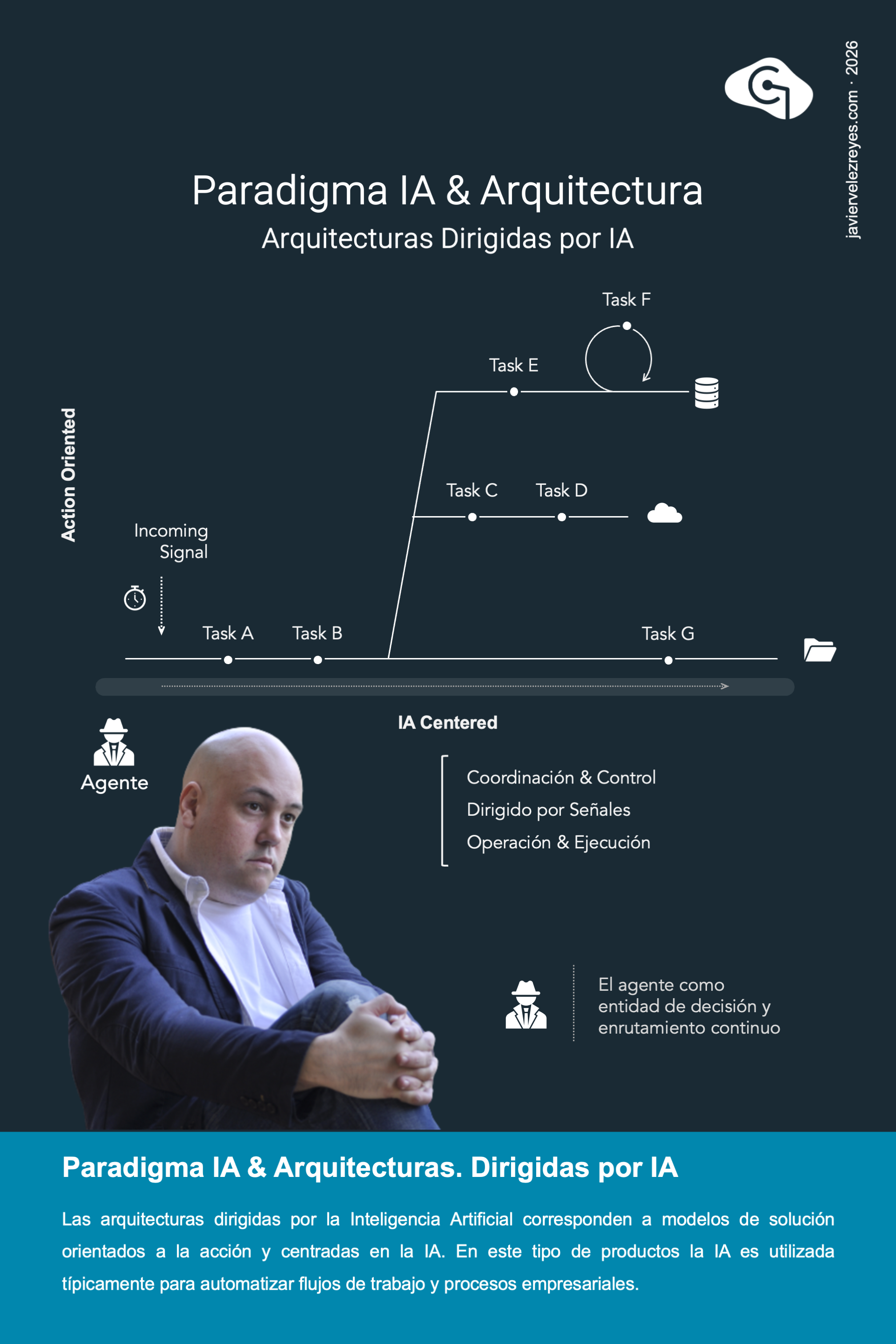

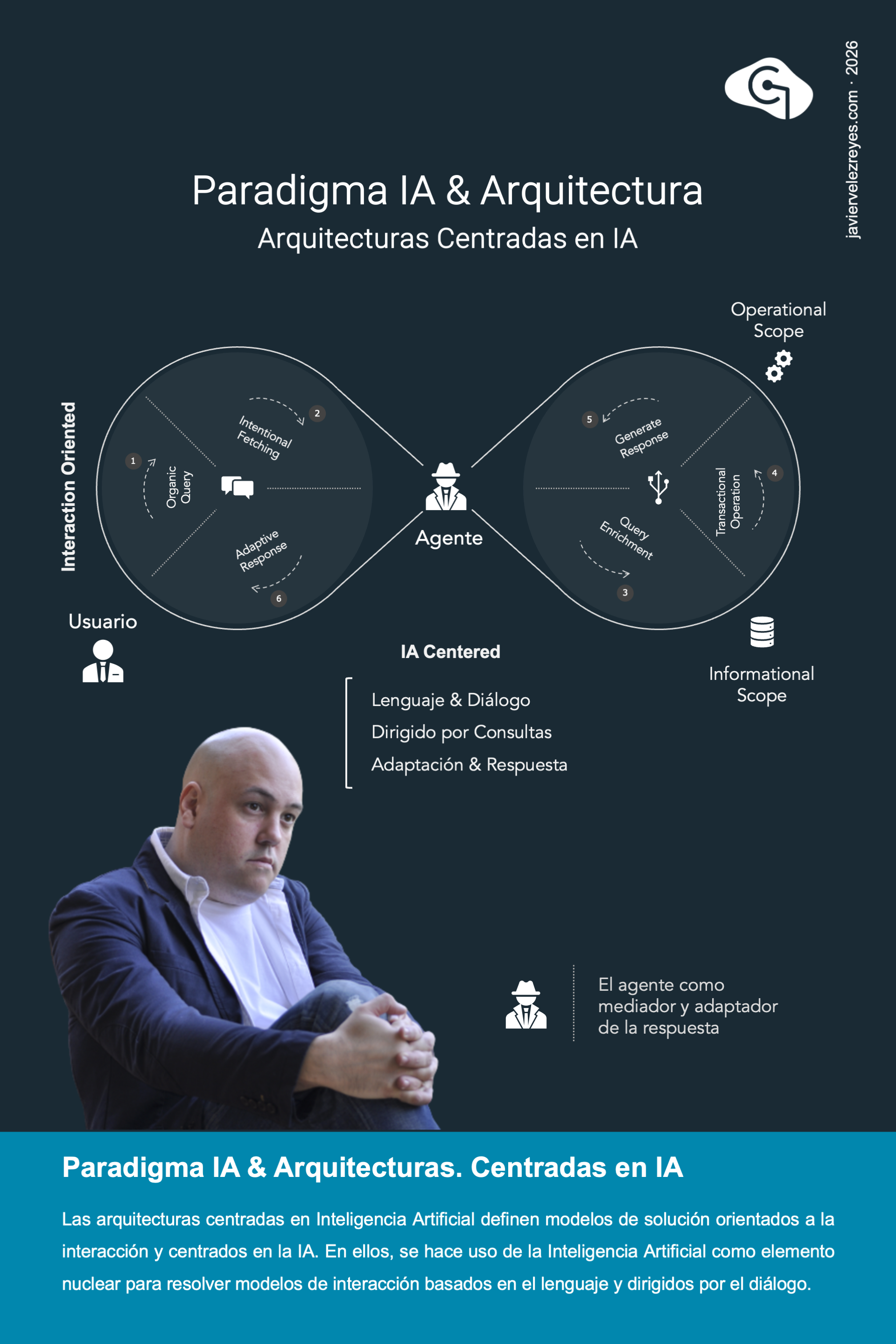

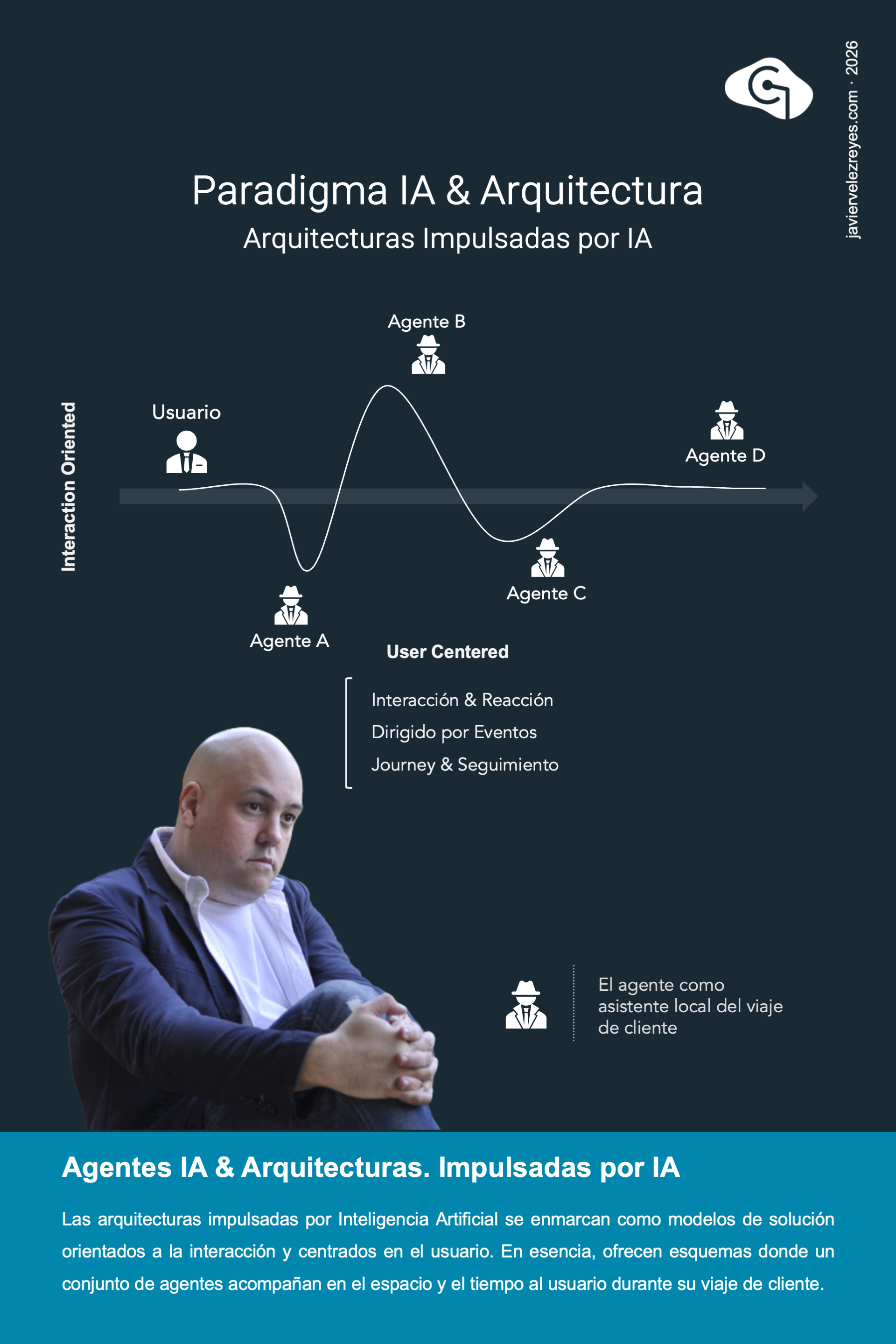

Existen en la actualidad diferentes modelos arquitectónicos dentro del paradigma de Inteligencia Artificial multiagentica. Éstos pueden organizarse de acuerdo a dos ejes dimensionales. En horizontal existen soluciones orientadas al desarrollo y ejecución de acciones de negocio mientras que otra se orientan a dar soporte a actividades interactivas. En vertical, es posible distinguir entre aproximaciones que colocan al usuario en el centro del proceso de intervención y toma de decisión empresarial mientras que otras se orientan a ofrecer esquemas de alta autonomía utilizando la Inteligencia Artificial como un elemento de operación independiente sin intervención discrecional. A partir de aquí pueden reconocerse diseños de arquitecturas suportadas por IA, Dirigidas por IA, Centradas en la IA e Impulsadas por la IA. A lo largo de las próximas semanas profundizaré en la descripción de cada uno de estos 4 modelos.

Las arquitecturas soportadas por Inteligencia Artificial se corresponden con soluciones orientadas a la acción y centradas en el usuario. Lo primero significa que se trata de productos orientados a la realización de actividades empresariales. Lo segundo implica que dicha realización se ve mediada por la intervención humana que participa, de manera iterativa e incremental, en un proceso típicamente a través de un modelo de experiencia basada en comandos. Hasta la fecha es común encontrar este tipo de arquitecturas vinculadas a la fase de construcción de productos de software. Pero lo cierto es que se trata de un modelo de solución que puede ser aplicado al desarrollo de cualquier tipo de proceso generativo vinculado a la creación de un producto donde se requiera una fuerte directriz humana.

Las arquitecturas dirigidas por Inteligencia Artificial se corresponden con modelos de solución fuertemente orientadas a la acción. Ello significa que su propósito fundamental es la ejecución de actividades de negocio típicamente vinculadas a los procesos empresariales de las organizaciones. Además, se trata de esquemas arquitectónicos completamente centrados en la IA donde se concede un gran protagonismo a la Inteligencia Artificial como entidad autónoma para la ejecución del proceso completo sin intervención humana alguna. Comúnmente este tipo de soluciones se aplica a escenarios en los que impera un espacio de acción suficientemente coercitivo y donde se requiere un esquema de respuesta reactiva en tiempo real. Los agentes son dentro de estas arquitecturas entidades de operación especializada cuya participación discrecional queda regulada por un flujo de trabajo establecido de manera fija y estática en tiempo de diseño.

Las arquitecturas centradas en la Inteligencia Artificial se corresponden con modelos de solución orientados a la interacción y centrados en la Inteligencia Artificial. Este tipo de soluciones exhiben modelos de comportamiento durante el tiempo de ejecución para dar soporte a procesos consultivos centrados en el lenguaje y dirigidos por el diálogo que tienen lugar durante las sesiones de trabajo con el usuario. Aquí la inteligencia se materializa típicamente como un agente central que regula todo el proceso dialógico, primero capturando la intención semántica de cada consulta, luego enriqueciéndola y resolviéndola informacional y operacionalmente y finalmente generando una respuesta adaptativa como continuidad al flujo argumentativo. Este es comúnmente el modelo de arquitectura que corresponde a todos los productos de Inteligencia Artificial Generativa que se exponen en el mercado. No obstante, nada impide crear este tipo de productos para confinados al ámbito de conocimiento de una organización.

Las arquitecturas impulsadas por la Inteligencia Artificial se enmarcan dentro del espacio de soluciones orientadas a la interacción y centradas en el usuario. En ellas, un conjunto de agentes inteligentes articulan respuestas reactivas para acompañar al usuario en su viaje de cliente dentro de los procesos empresariales. Esto es algo que ocurre tanto en la dimensión temporal como en la espacial, lo que traza diferentes modos de operación de los agentes. En la dimensión espacial varios agentes cooperan en cada instante para realizar contribuciones que enriquecen la experiencia de usuario. En la dimensión temporal, los agentes se ceden protagonismo para ofrecer continuidad durante el viaje de cliente extremo a extremo. Este tipo de soluciones suele requerir modelos de operación distribuidos típicamente desplegados sobre arquitecturas de microservicios. Sin embargo, tal vez por su complejidad inherente, son las aproximaciones menos desarrolladas hasta la fecha.

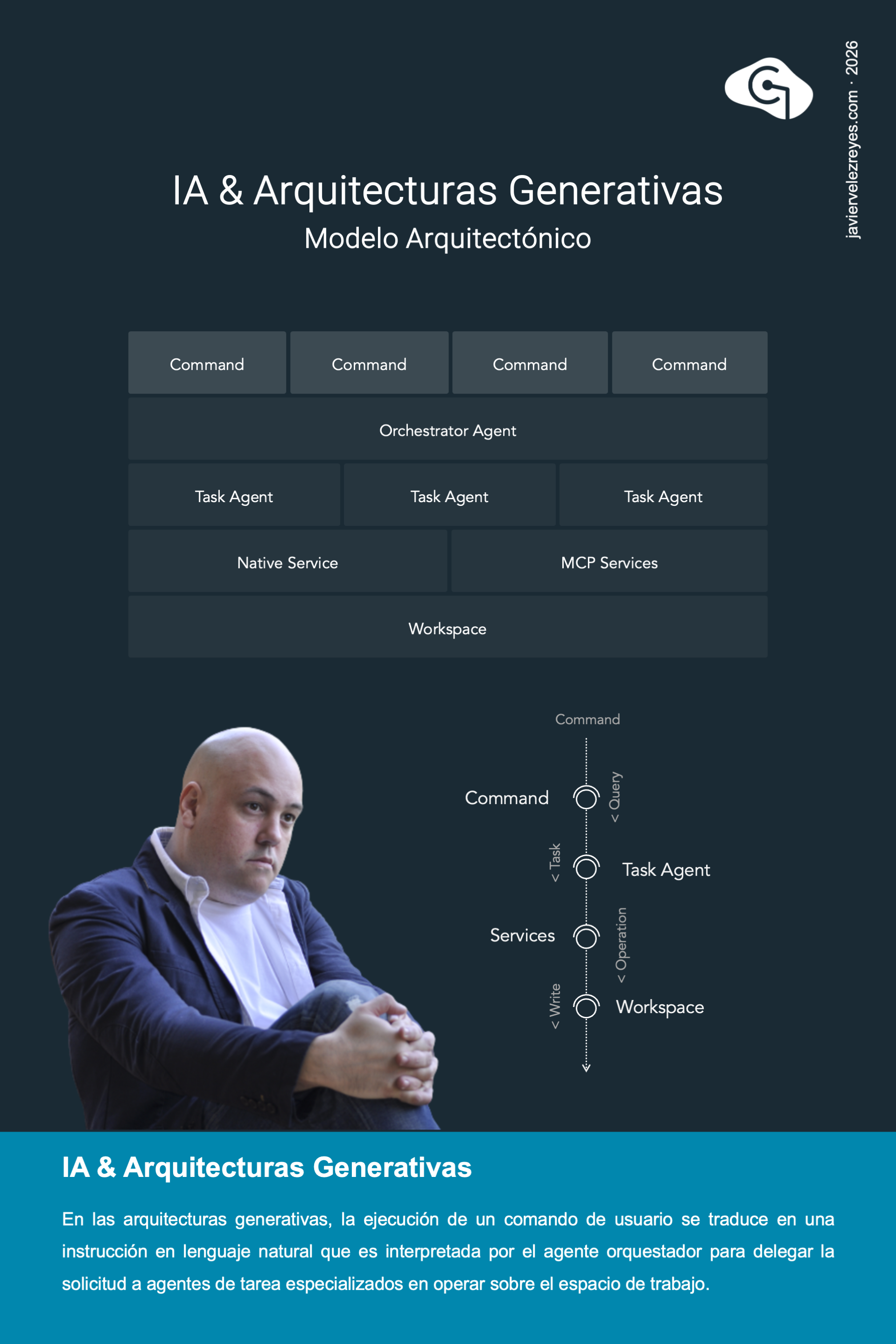

Una Arquitectura Generativa es un tipo de producto de Inteligencia Artificial de última generación responsable de asistir en el proceso iterativo e incremental de construcción de un tipo de producto, sea este un activo de software o un producto digital de otra naturaleza. Cada ciclo de interacción comienza por la ejecución de un comando paramétrico por parte del usuario. Ese comando, se traduce en una instrucción de construcción atómica expresada en lenguaje natural de acuerdo a la definición intencional del mismo. De esta forma, el agente orquestador de la capa inferior recibe cada instrucción y la interpreta intencionalmente en el marco del proceso. Una vez hecho esto, delega la responsabilidad en uno o varios agentes de tarea subyacentes especializados. Son precisamente estos agentes los que operan contra el espacio de trabajo del sistema a través de las capacidades nativas de la arquitectura y de los servicios MCP desplegados para evolucionar el producto construido.

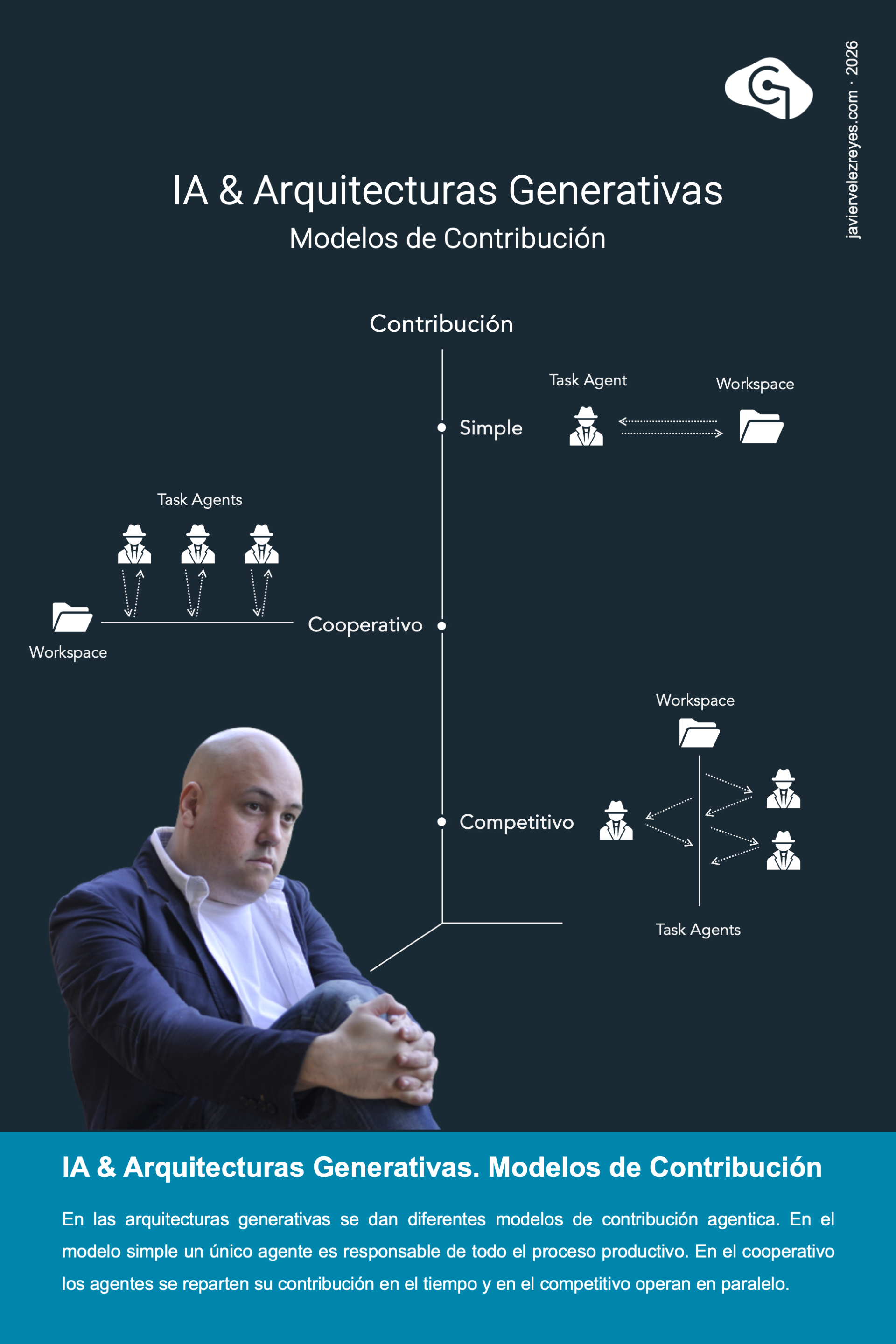

Las arquitecturas generativas son, sin lugar a dudas, el arquetipo de arquitectura de Inteligencia Artificial, que más atención están experimentando hasta la fecha. Aunque en términos generales se pueden aplicar a la construcción de cualquier tipo de activo digital, la mayoría de los productos de mercado están orientados a la generación de código. Pero dentro de esta familia de arquitecturas es posible reconocer tres categorías diferentes en función del modelo de participación agentica contributiva que utilicen. Las soluciones más sencillas hacen uso de un modelo de contribución simple en el que un único agente es el responsable de llevar a cabo todo el proceso constructivo a través de la realizaciones de operaciones contra el espacio de trabajo. En el modelo de cooperación existen diferentes tipos de agentes de tarea especializados y la construcción se concibe como un proceso secuencial desarrollado a lo largo del tiempo en el que cada agente realiza contribuciones puntuales especializadas. En el caso más complejo, por el contrario, los agentes son asimismo entidades especializadas pero compiten en el tiempo operando en paralelo sobre el espacio de trabajo para acelerar el proceso de construcción.

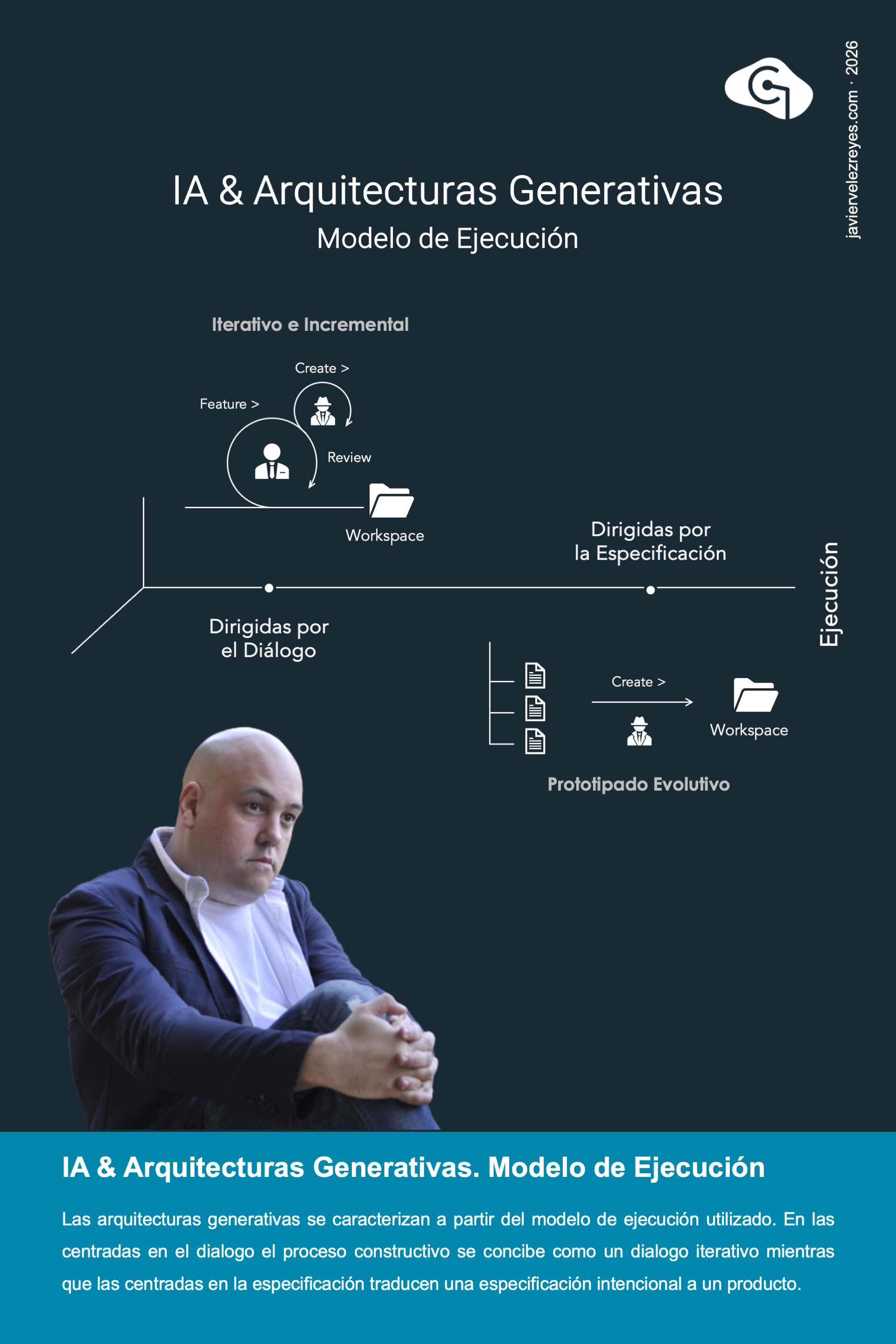

Las arquitecturas generativas que venimos discutiendo en las últimas semanas también pueden caracterizarse parcialmente a partir del modelo de ejecución que utilizan. En este sentido podemos distinguir claramente entre soluciones dirigidas por el diálogo y soluciones dirigidas por la especificación. En el primer caso, la arquitectura generativa se presenta como un agente de soporte que atiende las demandas constructivas del usuario enmarcadas en un flujo iterativo e incremental de instrucciones que coloca al usuario en el centro de todo el proceso. En el segundo caso, por el contrario, la arquitectura generativa es capaz de hacer una interpretación oportuna de toda una especificación completa, proyectiva e intencional del producto para generar bajo demanda el producto requerido.

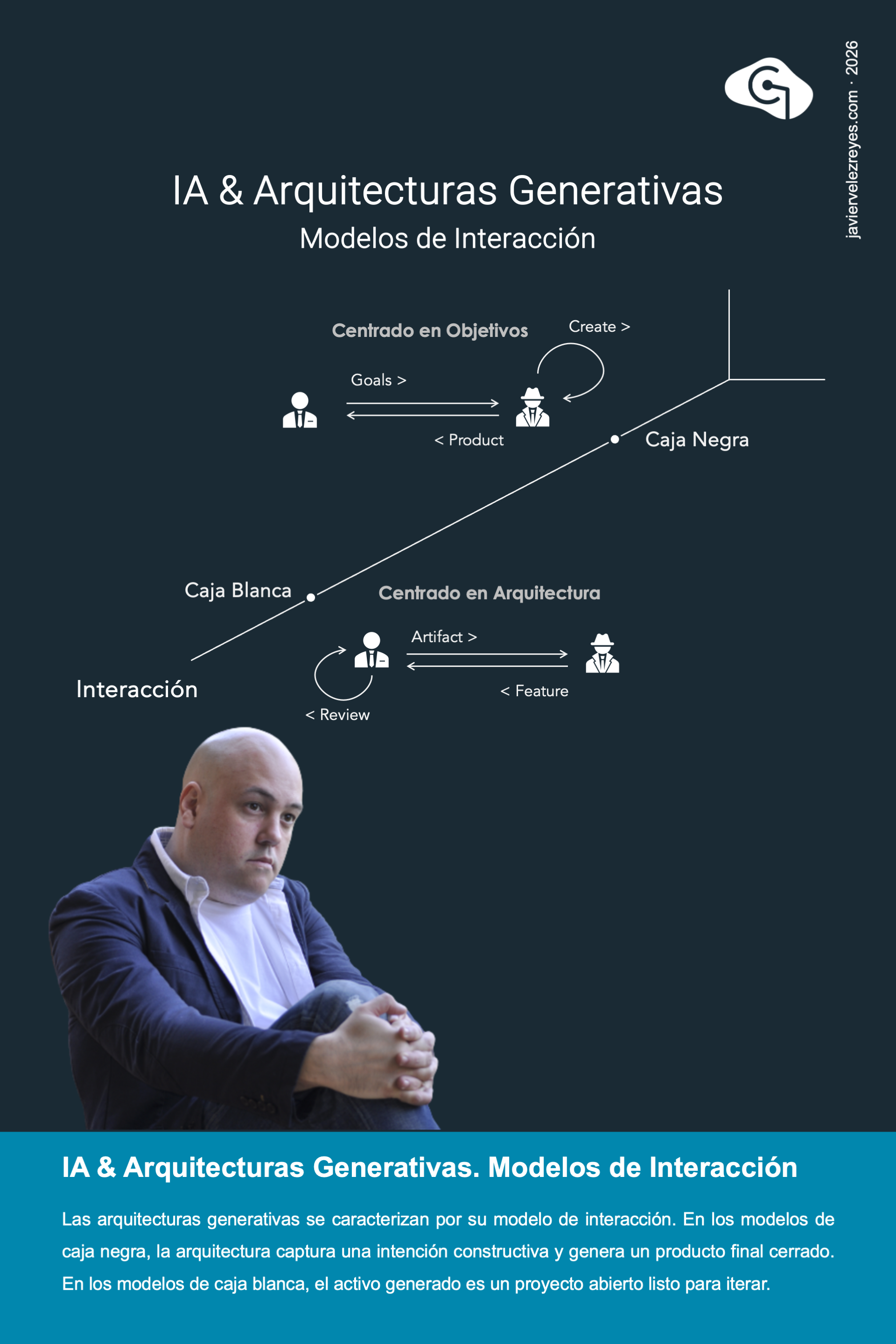

La última forma en la que pueden categorizarse las arquitecturas generativas tiene que ver con el modelo de interacción utilizado. En los modelos de caja negra, la arquitectura se presenta como una solución que recibe una expresión constructiva e intencional expresada en lenguaje natural y produce como resultado un producto final terminado. Este tipo de aproximaciones se vincula con las metodologías de prototipado desechable porque cualquier esfuerzo de construcción iterativa debe articularse a través de una reconstrucción completa del producto. En los modelos de caja negra, por el contrario, la arquitectura produce un proyecto abierto con artefactos editables específicos que están listos para su evolución iterativa en el tiempo. El primer modelo permite una respuesta funcional inmediata y se dice que está centrado en objetivos mientras que el segundo modelo permite controla la anatomía interna del producto y por ello se dice que está centrado en la arquitectura.

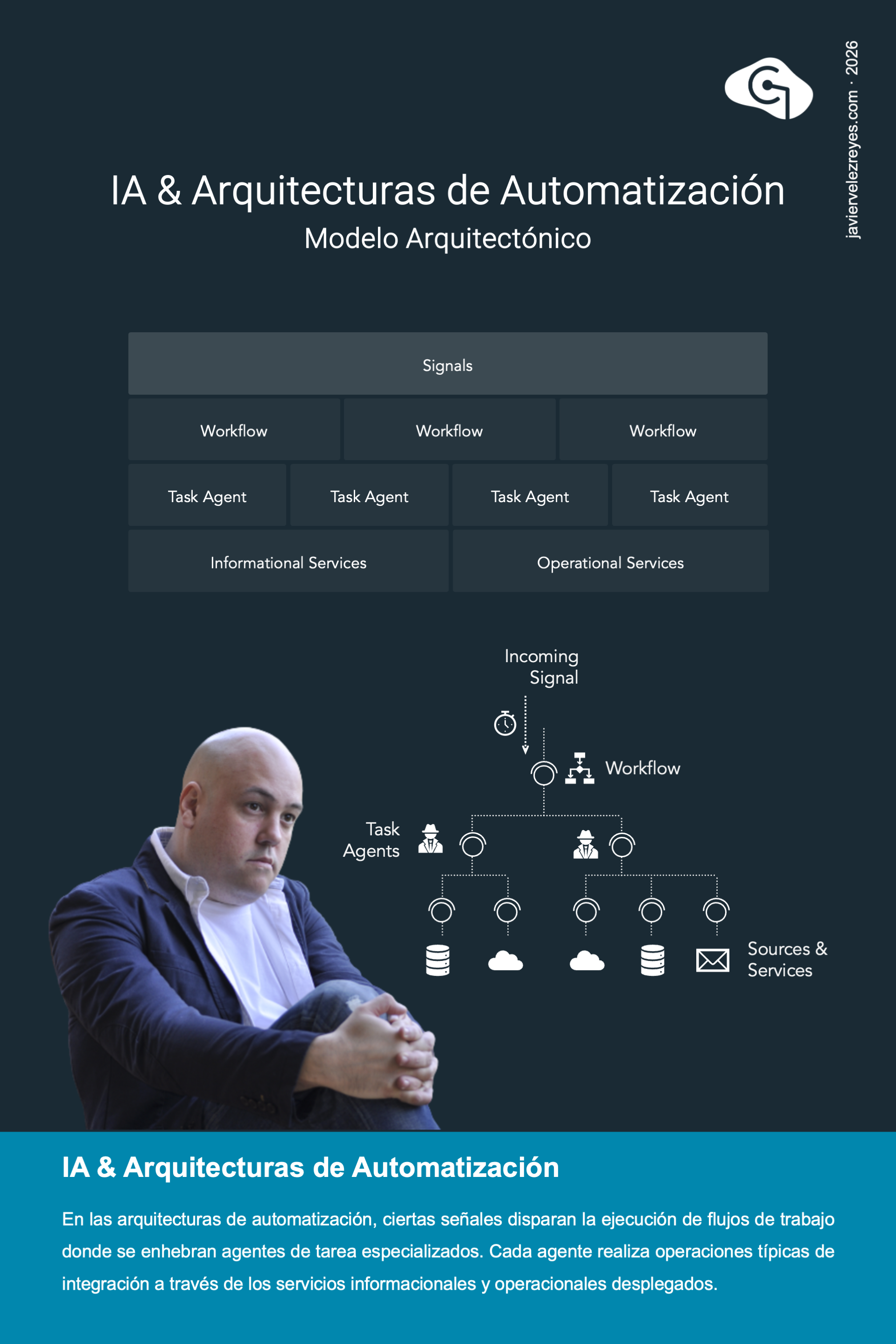

Las arquitecturas de automatización son, sin lugar a dudas, el segundo modelo de arquitectura que está tomando mayor foco de interés en la actualidad dentro del mercado. Como ya explicamos se corresponden con la familia de soluciones dirigidas por Inteligencia Artificial dentro de nuestra categorización de arquitecturas. El objetivo es ofrecer una respuesta reactiva en tiempo real a la llegada de señales dentro del entorno empresarial. En concreto, cuando llega una señal al sistema está es capaz de lanzar a ejecución un flujo de trabajo donde se encuentran enhebrados un conjunto de agentes de tarea especializados. Al invocarse cada agente dentro del flujo, produce típicamente una serie de acciones de interacción que se encuentran conectadas con los perímetros informacional y operacional de la compañía.

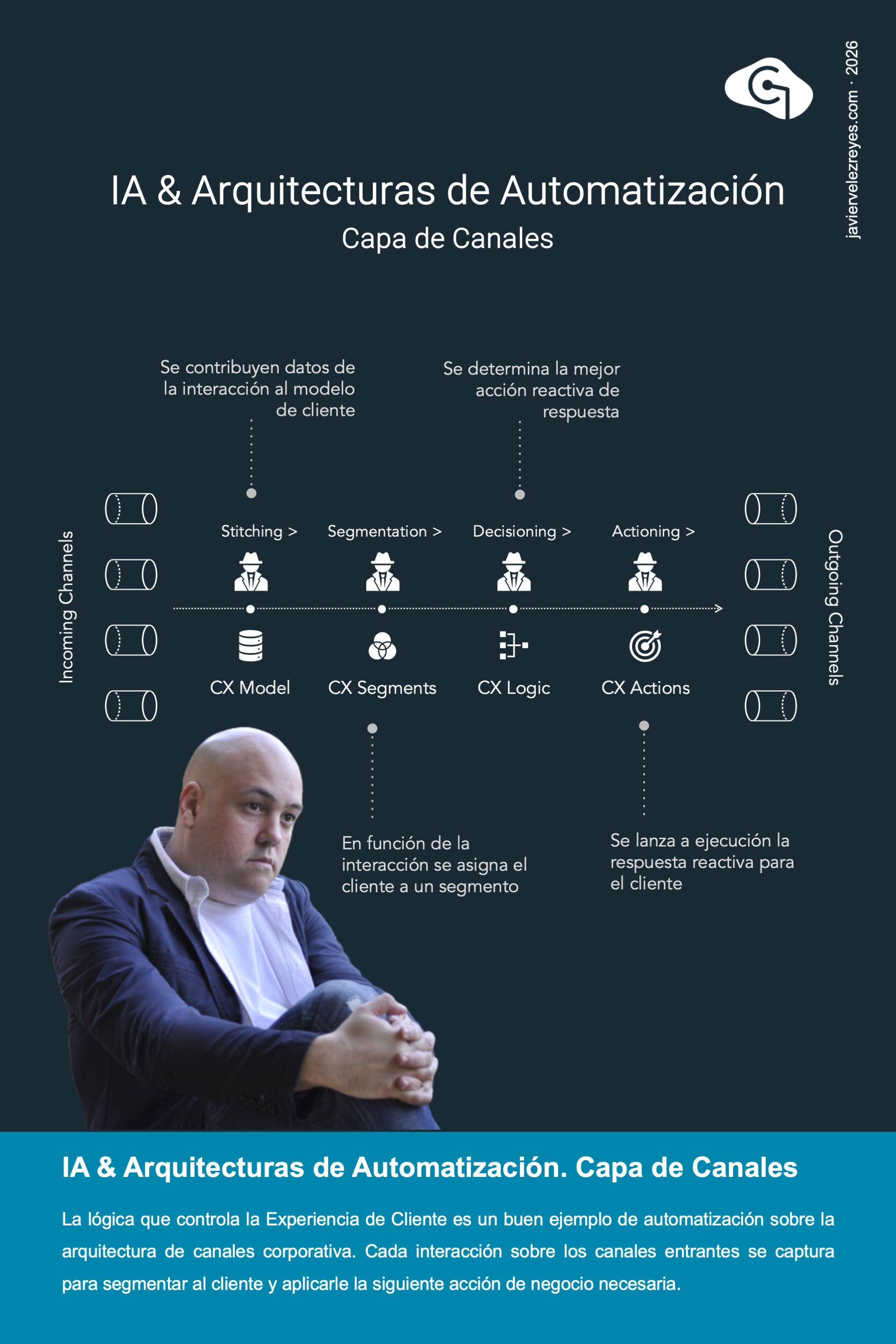

Las soluciones de automatización dirigidas por Inteligencia Artificial encuentran un buen espacio de acción dentro de la arquitectura de canales de la organización. Con el ánimo de huir del manido ejemplo que nos recuerda siempre como gestionar un funnel de conversión corporativo a través de actividades de lead fetching y lead nurturing, en este poster he querido presentar el flujo que recorre una señal entrante de cliente para determinar y ejecutar la siguiente acción de negocio pertinente. Un simple click en la Web corporativa llega al agente de stitching para enriquecer el modelo de cliente. Esto permite reevaluar la lógica de segmental lo que cualifica al cliente potencialmente en nuevos segmentos. A partir de esta nueva información el sistema decide cual es la siguiente acción de negocio que debe aplicarse al usuario y finalmente ejecuta dicha acción para hacerla efectiva.

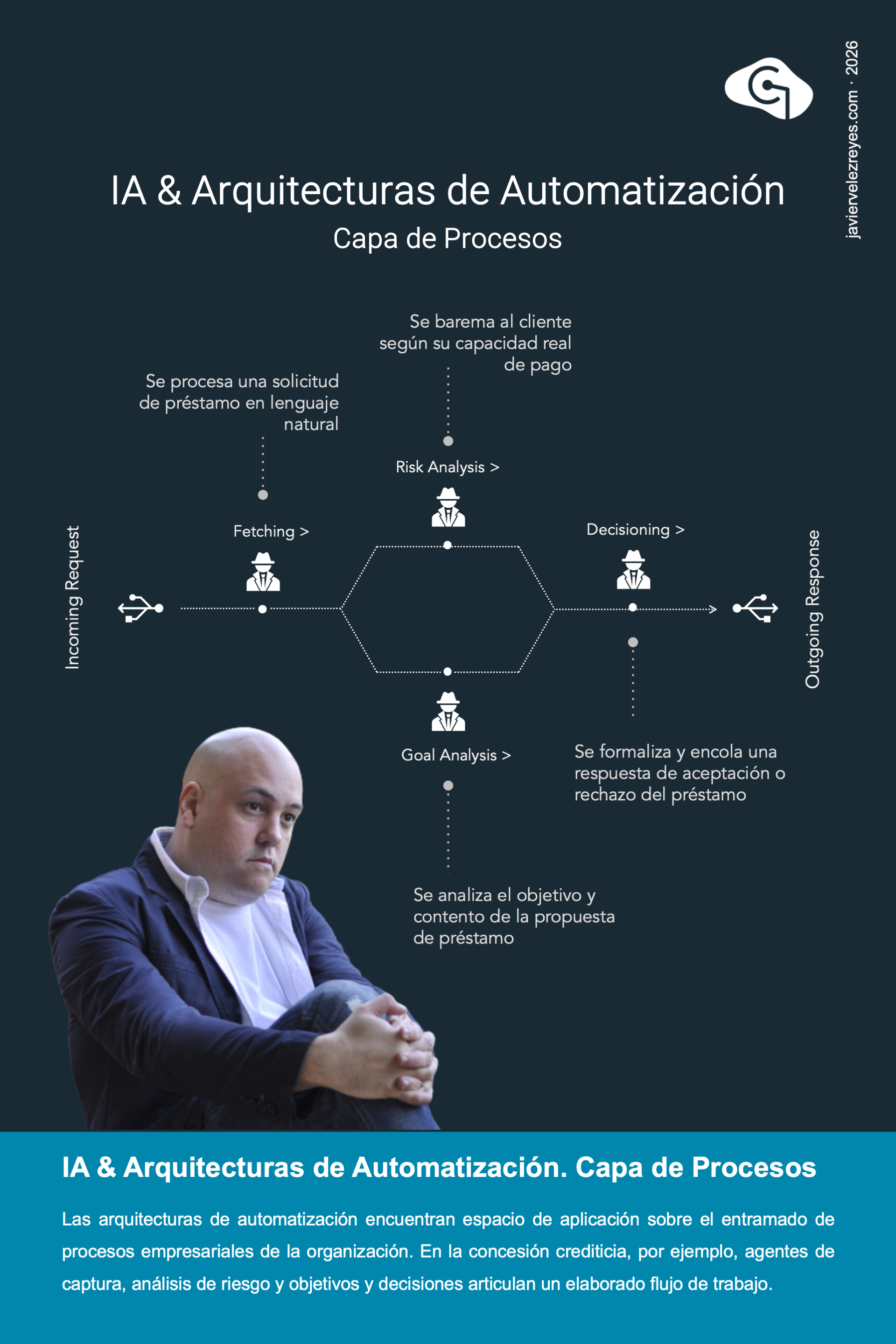

Sin lugar a dudas, el entramado de procesos empresariales es otro de los espacios donde la aplicación de soluciones de automatización dirigidas por Inteligencia Artificial cobra especial relevancia. Hasta la fecha debemos reconocer una clara ausencia de despliegues de este tipo de soluciones dentro de este perímetro. Pero eso tal vez se deba a la falta de madurez tecnológica alcanzada por el momento, a una cultura organizacional muy acostumbrada en centrar sus actividades de digitalización en esfuerzos únicamente algorítmicos y, sin duda, a la falta de confianza a día de hoy existente en la aplicación de sistemas de Inteligencia Artificial para articular y dar respuesta de forma automática a procesos de la organización que puedan llegar a tener un impacto directo en la actividad y los resultados del negocio. No obstante, en un horizonte temporal cercano, no será extraño observar organizaciones que articulen la mayor parte de sus procesos empresariales sobre arquitecturas de automatización dirigidas por Inteligencia Artificial.

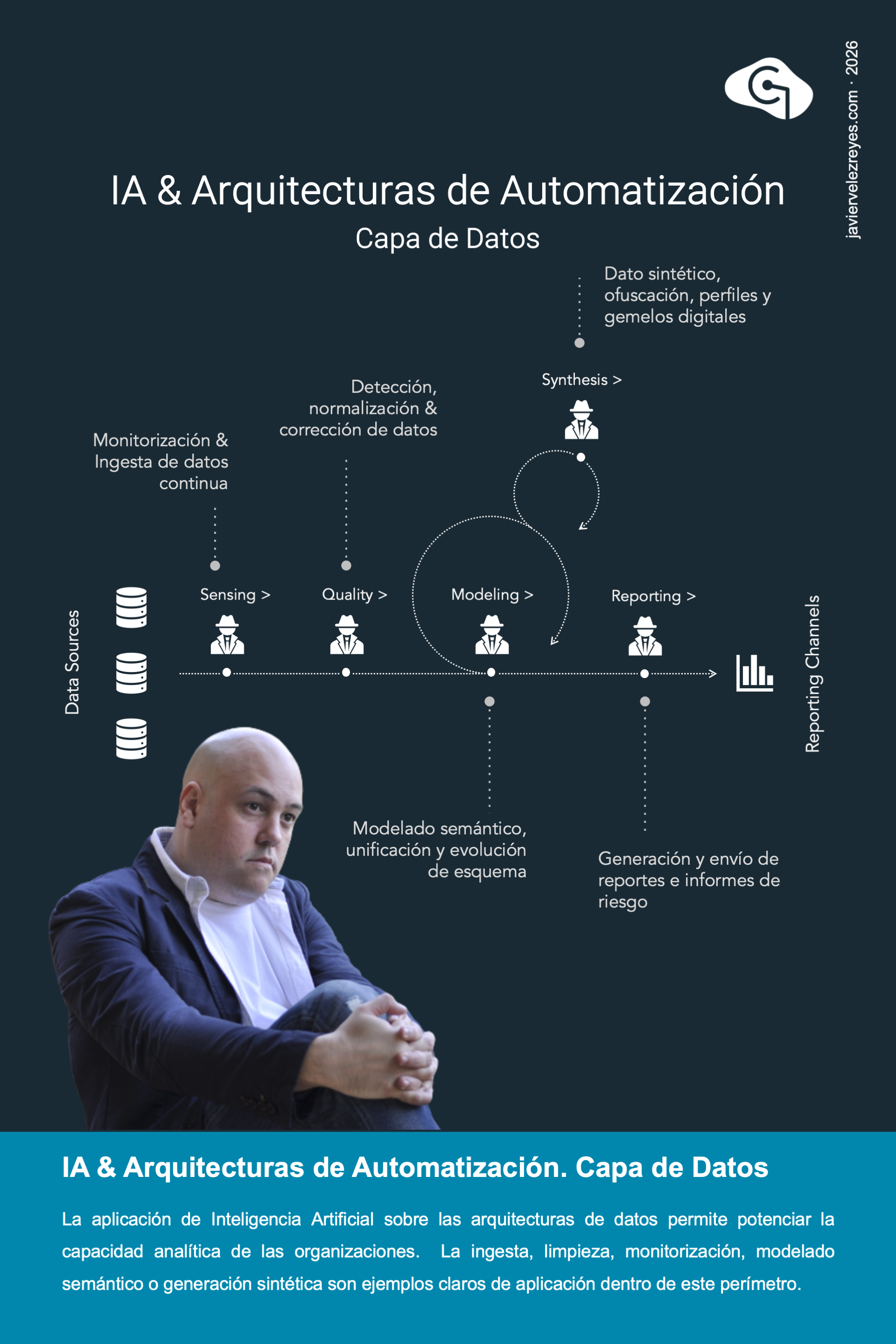

Las arquitecturas de automatización dirigidas por Inteligencia Artificial encuentran también locus de aplicación sobre la capa de datos empresarial de las organizaciones. En efecto, se pueden desplegar arquitecturas de esta naturaleza en las que una serie de agentes llevan a cabo actividades recurrentes dentro de este perímetro de forma completamente autónoma, discrecional y en tiempo real según se produce la ingesta de nuevos datos. Agentes inteligentes para la monitorización continua de fuertes entrantes y la ingesta de datos, agentes para la detección de anomalías y su subsiguiente normalización y corrección, agentes para el modelado semántico y la unificación evolutiva de esquemas o includo agentes para la generación de datos sintéticos y la creación de gemelos digitales son son algunos ejemplos típicos de uso que pueden destacarse.

Las arquitecturas centradas en Inteligencia Artificial son, sin lugar a dudas, el tipo de soluciones de IA más comúnmente conocido en la actualidad. No en vano, a esta familia arquitectónica pertenecen la mayor parte de productos de mercado desplegados por los grandes vendors. En ellos, una colección de agentes de interfaz de usuario son capaces de recoger la expresión intencional del cliente para reformularla en términos de una consulta de entrada descrita en lenguaje natural. Esta consulta es recogida por el agente central de la arquitectura, que se concibe como un motor de razonamiento lógico argumentativo, dialógico y modal para trazar un plan de acción que de respuesta a la consulta. Para ello hace uso discrecional de los servicios informacionales y operacionales que el agente tiene desplegado a su disposición.

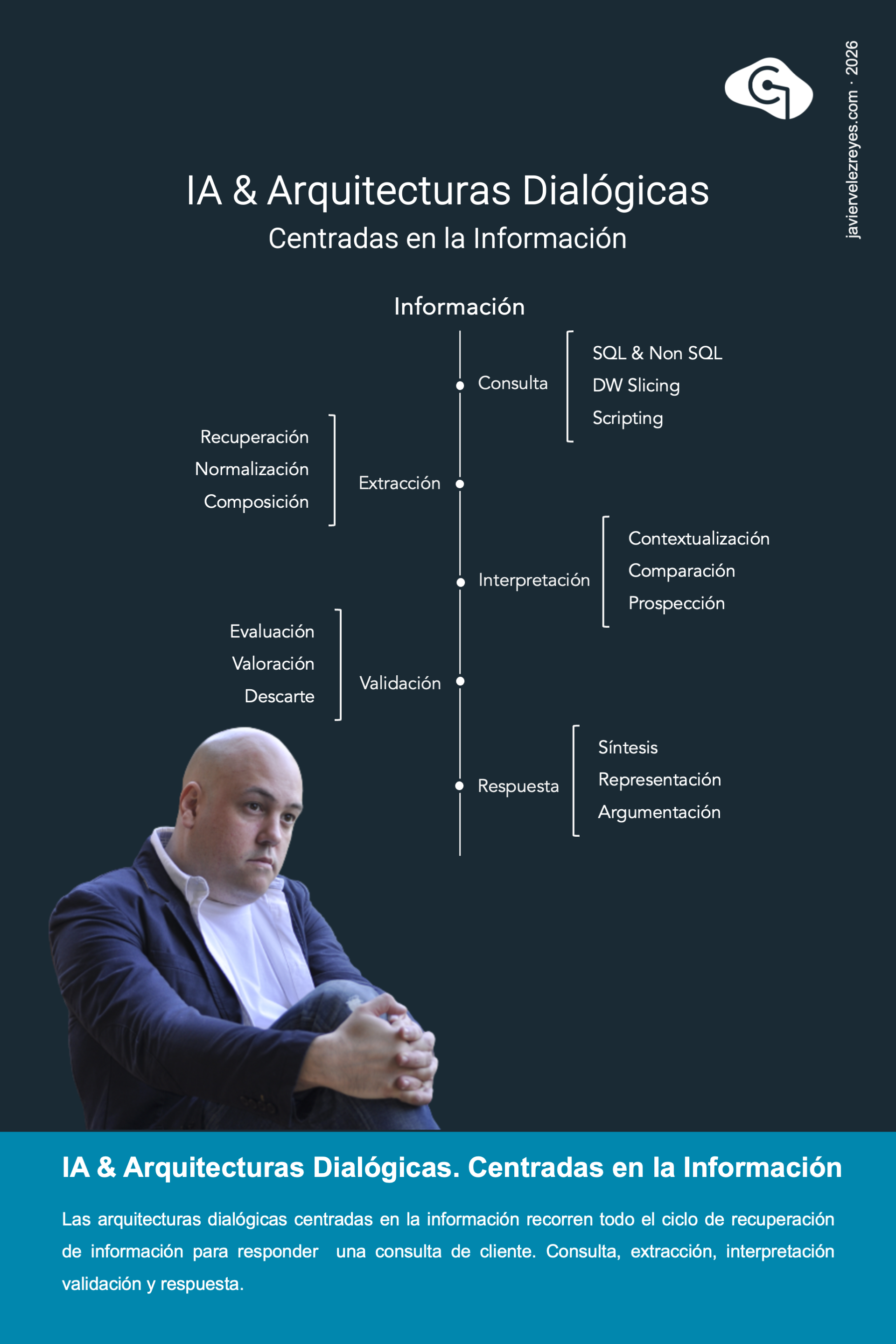

Dentro de las arquitecturas dialógicas destacan aquellas centradas en la recuperación de información. Se trata de soluciones de Inteligencia Artificial cuyo propósito es elaborar respuestas argumentativas orientadas a satisfacer las consultas del usuario. En cada ciclo de diálogo, este tipo de sistemas recorre el conjunto de fases propias vinculadas a los procesos de recuperación de información. Dentro de cada fase, es posible aplicar distintas estrategias en función del tipo de problema a tratar, los objetivos perseguidos y el contexto empresarial en el que se despliega la solución. En la fase de consulta se formula la expresión de la necesidad de información. En la fase de extracción se procede a la recuperación de los contenidos relevantes. En la fase siguiente, la información obtenida es interpretada y contextualizada en relación con la pregunta planteada. Durante la fase de validación se evalúa la pertinencia de los resultados obtenidos. Finalmente, en la fase de respuesta, se genera una respuesta argumentativa expresada en lenguaje natural.

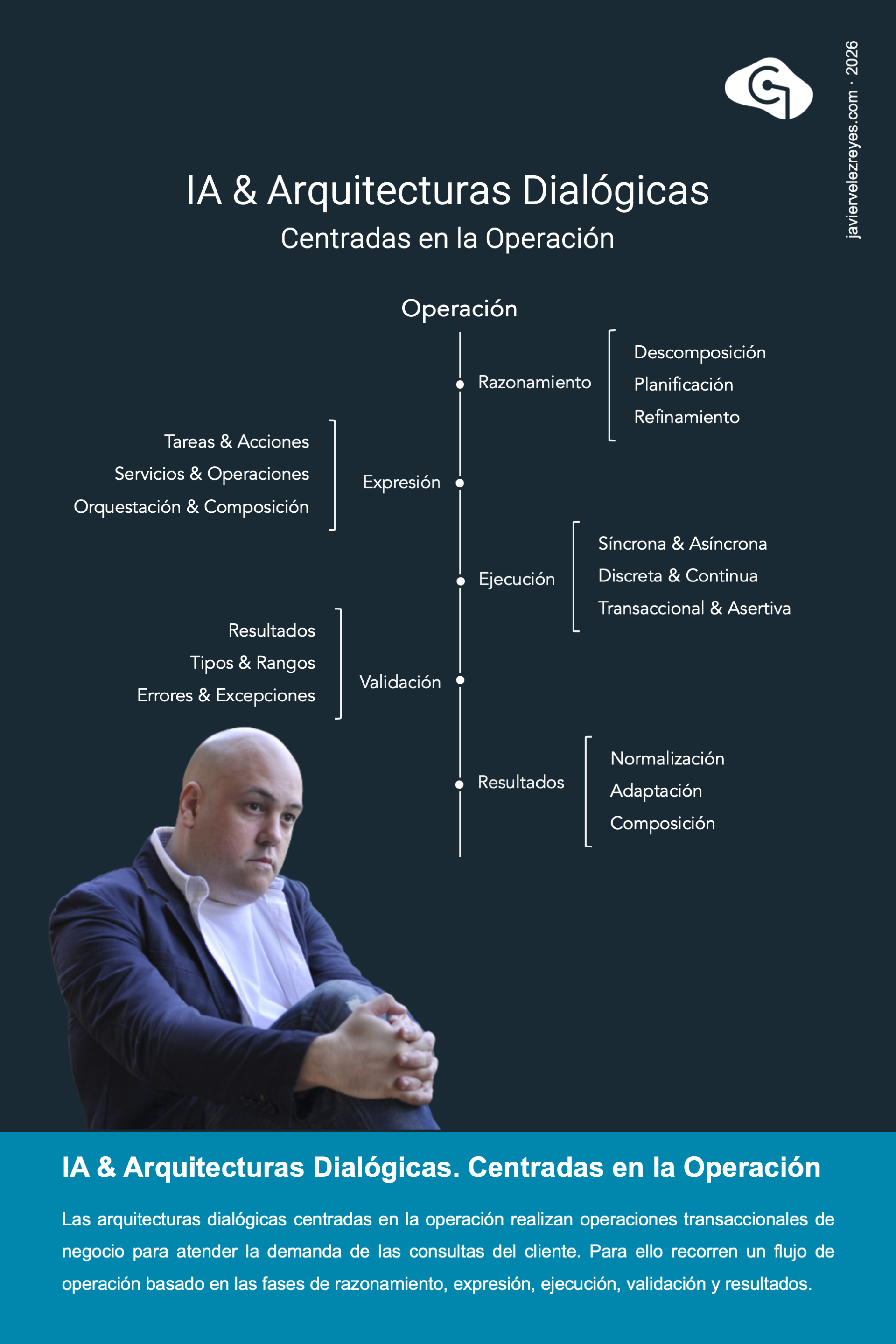

Sin lugar a dudas la otra gran categoría dentro de las arquitecturas dialógicas son aquellas que están centradas en la operación. En este caso, se trata de modelos de solución cuyo propósito es atender la demanda intencional del cliente para realizar determinada lógica de operación transaccional sobre el entramado de capacidades de negocio de la organización. En este caso, cada ciclo de demanda recorre una secuencia de fases prototípicas dentro de las cuales es posible aplicar diferentes tipos de estrategias en función del contexto empresarial y el tipo de problema a considerar. En particular, en la fase inicial de razonamiento se procede a trazar un plan de acción para proceder con la resolución de la solicitud. En la fase subsiguiente de expresión dicho plan se concreta en tareas y acciones especificas. Durante la siguiente fase cada una de esas tareas son lanzadas a ejecución transaccional sobre el entramado de servicios. A continuación se validan los resultados obtenidos en la fase anterior. Y finalmente, se procese con la expresión argumentativa de los resultados para presentarlos al usuario.

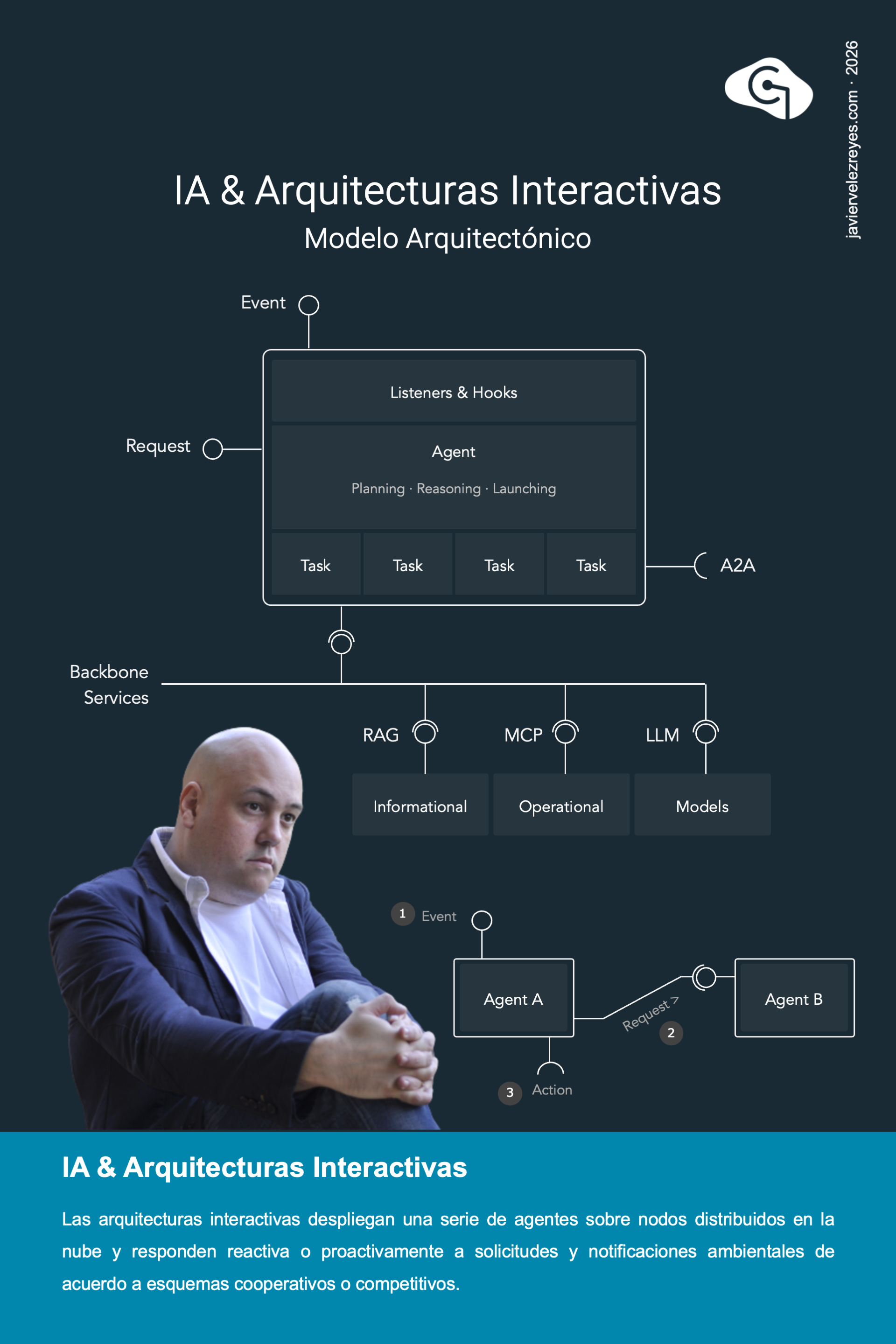

El último tipo de soluciones de Inteligencia Artificial que repasaremos en las próximas semanas son las Arquitecturas Interactivas. En ellas un sistema multiagente es desplegado sobre un entramado de computación distribuida en la nube para que realicen un acompañamiento tanto en el tiempo como en el espacio del viaje de cliente en su interacción sobre la arquitectura de canales de una organización enfrentando escenarios tanto cooperativos como competitivos. Cada agente es una unidad de comportamiento inteligente especializado que responde a notificaciones ambientales y solicitudes entrantes del resto de agentes. Además puede realizar acciones operando sobre los perímetros operacionales de la organización. Para lo primero se propone típicamente el protocolo A2A y para lo segundo se utilizan técnicas RAG y MCP respectivamente.

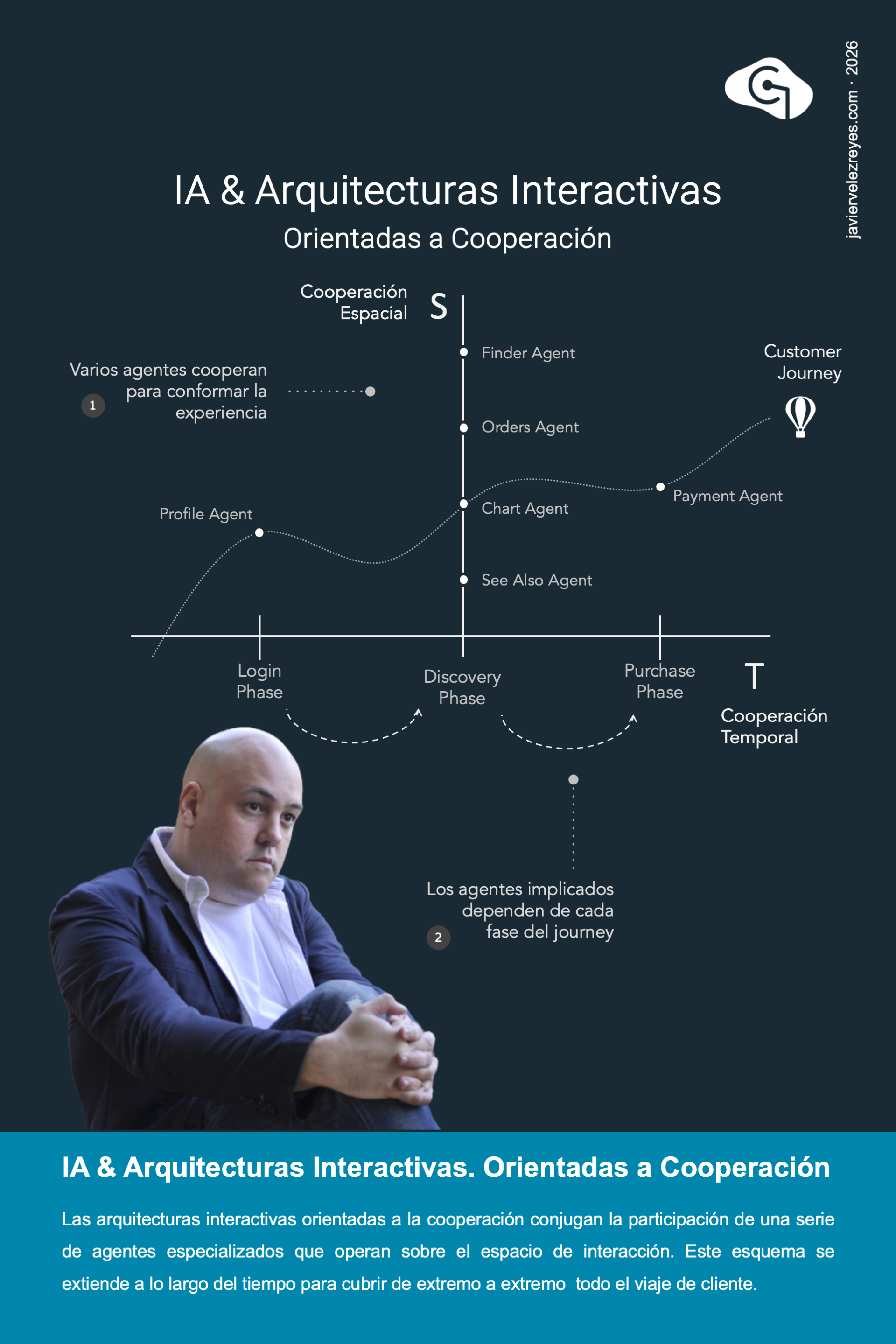

En las arquitecturas interactivas impulsadas por Inteligencia Artificial orientadas a la cooperación, diferentes agentes participan conjuntamente para acompañar al usuario en su viaje de cliente, a través de la arquitectura de canales de la organización. Como ejemplo, podemos pensar en usuarios que realizan compras en la web de una tienda en línea. En un instante de tiempo determinado, esta cooperación se despliega sobre el espacio de interacción. Por ejemplo, durante la fase de descubrimiento de productos intervienen agentes de búsqueda, pedidos, compra y recomendación, que actúan de manera coordinada para ofrecer una experiencia de cliente mejorada. Considerado desde una perspectiva temporal, este mismo esquema cooperativo se extiende a lo largo del tiempo y acompaña al usuario a través de todas las fases transaccionales que conforman el proceso de compra.

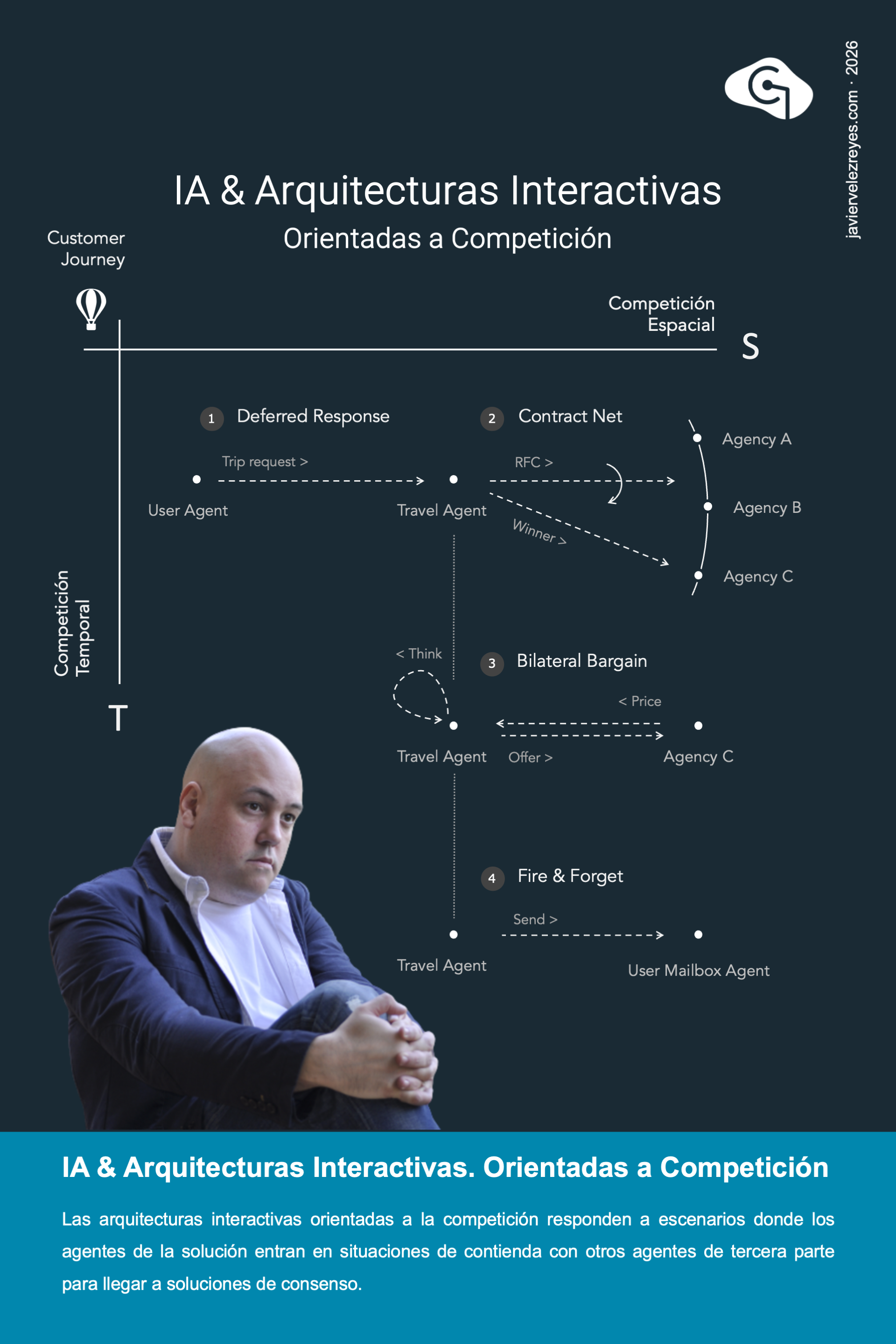

En las arquitecturas interactivas orientadas a la competición, los agentes del sistema se enfrentan a situaciones recurrentes de contienda con otros agentes externos de tercera parte. La misión de este tipo de soluciones es lograr que los primeros lleguen a soluciones de consenso favorables para la organización. Un ejemplo claro es el que se representa en este poster, en el que un agente de cliente realiza una solicitud diferida para le reserva de un billete contra el agente de viaje. Como consecuencia, este agente articula un sondeo entre las agencias ofertantes y es la agencia C la que obtiene la oportunidad. Después el agente de viaje se embarca en un regateo bilateral para acordar el mejor precio por el viaje. Y finalmente, el agente de viaje comunica al agente de usuario las condiciones obtenidas y remite todos los recursos vinculados a la transacción.

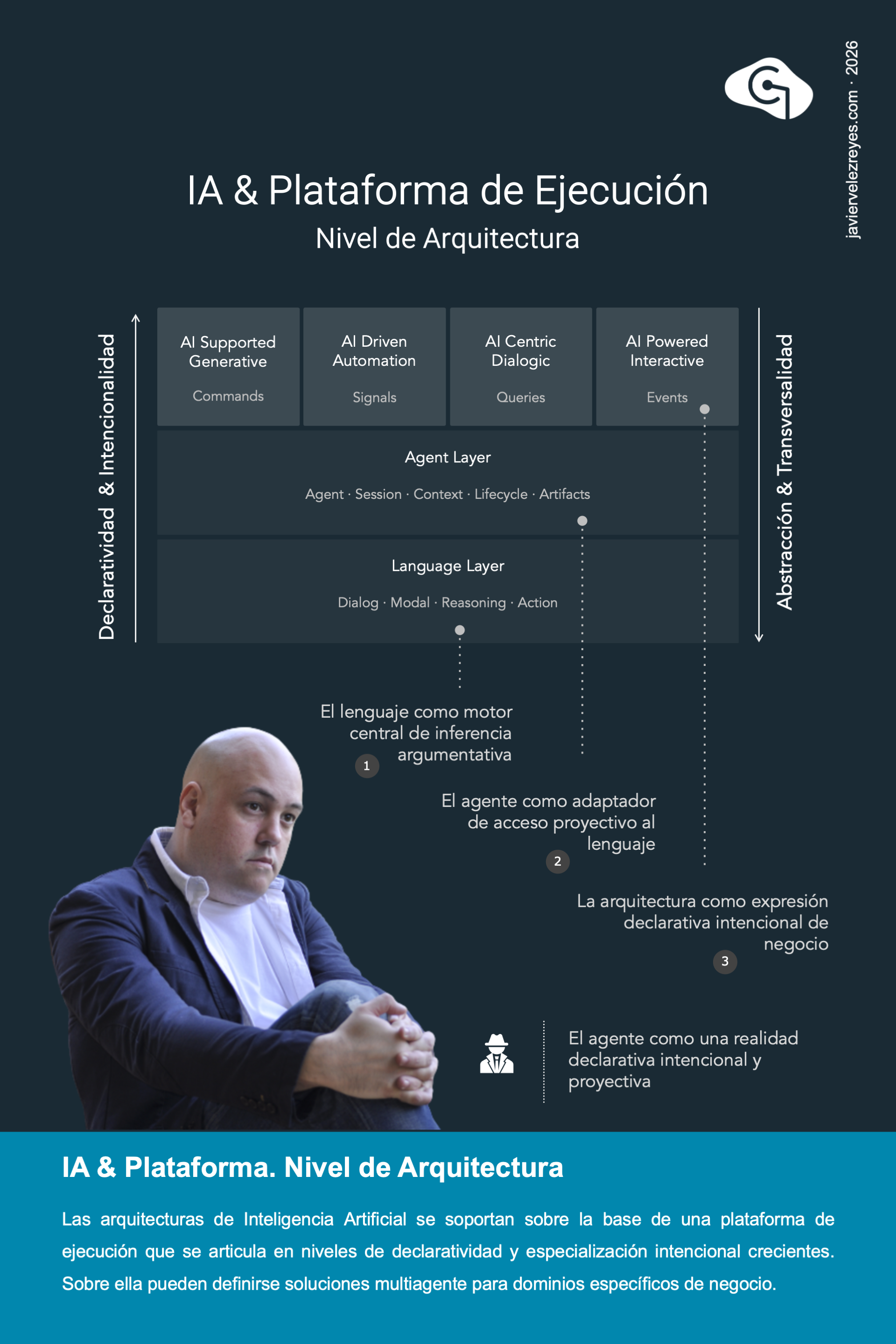

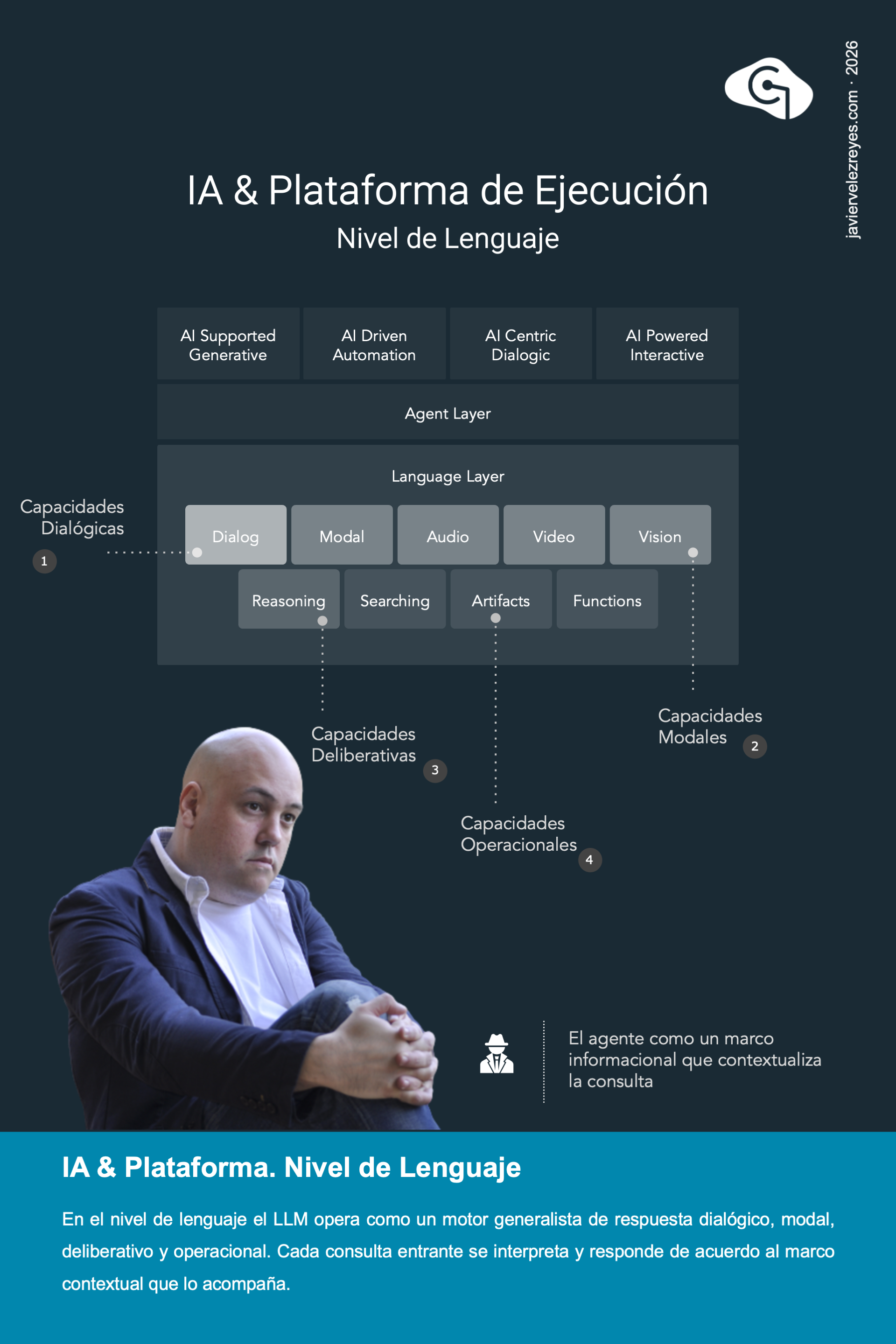

Cada una de las 4 familias de arquitecturas de Inteligencia Artificial que hemos venido discutiendo en las últimas semanas hacían frente a distintos tipos de problemas empresariales y se centraban en distintos modelos de interacción, ya fueran basados en comandos, señales, consultas o eventos. A este nivel superior una arquitectura de esta naturaleza debería concebirse como un esfuerzo de diseño donde un conjunto de agentes encapsulan modelos de comportamiento inteligente especializados descritos de manera completamente declarativa, proyectiva e intencional. Más que pensar en los agentes como entidades de operación funcional atadas a prescripciones procedimentales se debe pensar en que los agentes representan espacios de responsabilidad capaces de operar con autonomía y poder de decisión en el marco de la arquitectura donde operan para hacer frente a problemas pretendidamente abiertos. Pero, ¿de donde salen esas capacidades asumidas de fabrica? Esa es precisamente la responsabilidad de la plataforma de ejecución subyacente que discutiremos en las próximas semanas.